Instinct MI300Xは

8ダイで合計320 XCU

さて、話を戻そう。AMDから提供されたInstinct MI300Xの写真が下の画像だ。

8つのGPUのダイに、それぞれ40個のXCUが搭載されているように見える。ということは、8ダイで合計320 XCUである。これはMI250Xの220 XCU(112 XCU/ダイながら2つ無効なので、110 XCU/ダイ)と比べると、わずかに1.45倍の増加に過ぎない。

先に書いたAI性能が8倍というのは、実際にはデータ型の変更(FP16/BF16のサポートに加え、おそらくFP8をサポート)を加味しての数字と思われるので、演算器そのもので言えば4倍になると考えられるのだが、いくらなんでも1.45倍は差がありすぎる。

ただもしここでRDNA 3の時と同様に、1つのXCUあたりの演算性能が2倍に変更されたと考えると、実質640 XCU相当になって演算器の数は2.91倍に増えた計算となる。これならわりとありそうな話である。もちろんこれではまだ4倍に達しないわけだが、Instinct MI250XはPeak Engine Clockが1.7GHzとわりと控えめである。なのでPeak Engine Clockを2.34GHzあたりまで引き上げると考えると、ほぼピーク性能は4倍になる計算だ。この場合、MI300Xの性能は下表の数字になると想像される。

| MI300Xの性能 | ||||||

|---|---|---|---|---|---|---|

| 演算 | 性能 | |||||

| PF64 Vector | 192TFlops | |||||

| FP64 Matrix | 384TFlops | |||||

| BF16 Matrix | 1536TFlops | |||||

| FP8 Matrix | 3072TFlops | |||||

ただし、電力効率が5倍でしかないので消費電力は1.6倍に増える計算だ。Instinct MI250Xがピーク560WとされていたのでInstinct MI300Xは896W、ほぼ900Wというあたりだろうか。

「フォームファクターそのものはOCP(Open Compute Project)のOAM(OCP Accelerator Module)に互換だ」というので「では消費電力もMAX700W?」(OAMは48V供給で最大700W、12V供給で600Wが定格の上限)と聞いたら、笑って誤魔化された

このFP8のMatrixで3PFlopsという値は、NVIDIAのH100の4PFlopsにはややおよばないように見える。ただこれはピーク性能で比較して、という話である。実際には容量は不明ながら、少なからぬであろうインフィニティ・キャッシュと、さらにHBM 3が8ch(H100は6ch)というあたり、実際には互角の性能である公算が高い。もっとも性能が互角だからと言っても、CUDAがそのまま動かないあたりがH100に対する大きなネックであることに変わりはないのだが。

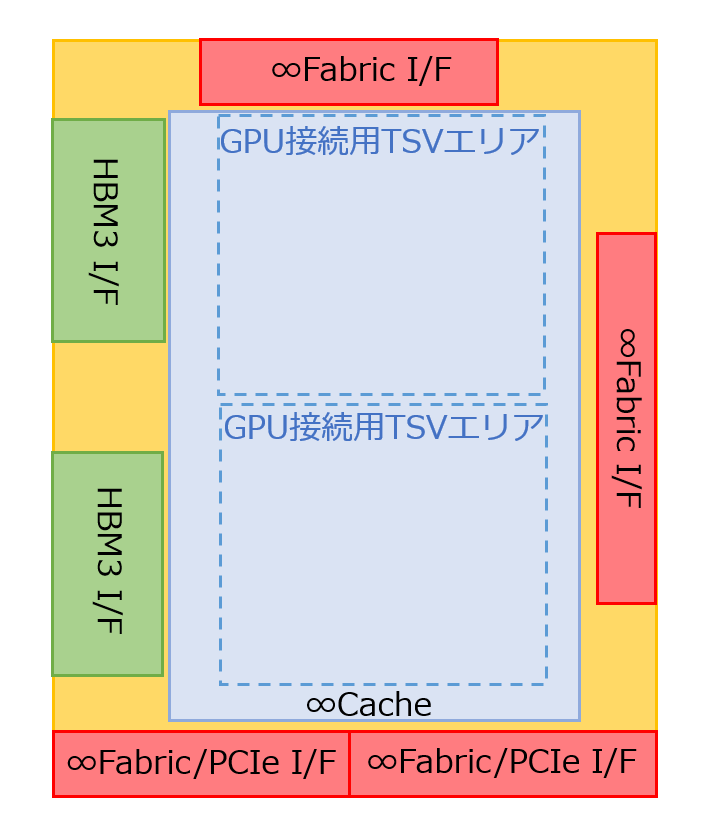

I/Oダイの構造の推定図を下図に示す。これはInstinct MI300Xを上から見た構造図で言えば左下のI/Oダイに相当する(左右対称のI/Oダイもあるはずだ)。インフィニティ・ファブリックのI/Fが4つあるが、上辺と右辺のものはI/Oダイ同士の接続用、そして下辺のものは外部接続用である。と言うのは、Instinct MI300Xを8つ搭載するソリューションが今回も展示されており、この8つのInstinct MI300Xを相互接続するのに7本のインフィニティ・ファブリックが必要である。

ただ7本だけでは相互接続して終わり(外部へのI/Fがない)なので、外部接続にも1本必要になる。4つのI/O ダイからそれぞれ2本づつ外部接続用のインフィニティ・ファブリックが出れば、ちょうど8本というわけだ。

週刊アスキーの最新情報を購読しよう