12月7日~11日にかけ、サンフランシスコでIEDM(International Electron Device Meeting) 2024が開催された。前回に続いてこの内容について取り上げたい。

今年のテーマは"Shaping Tomorrow's Semiconductor Technology"となっており、実際次世代向けのプロセスに関する話題が多く発表されている。

今回は、招待講演である21-6の"Tomorrow's Modular & Scalable Compute Systems"の内容をご紹介したい。講演者はAleks Aleksov博士(Principal Engineer, Semiconductor Packaging and Systems Integration Research)ら4人となっている。

AI向けシステムが抱える課題は

膨大な消費電力とメモリーの使用量

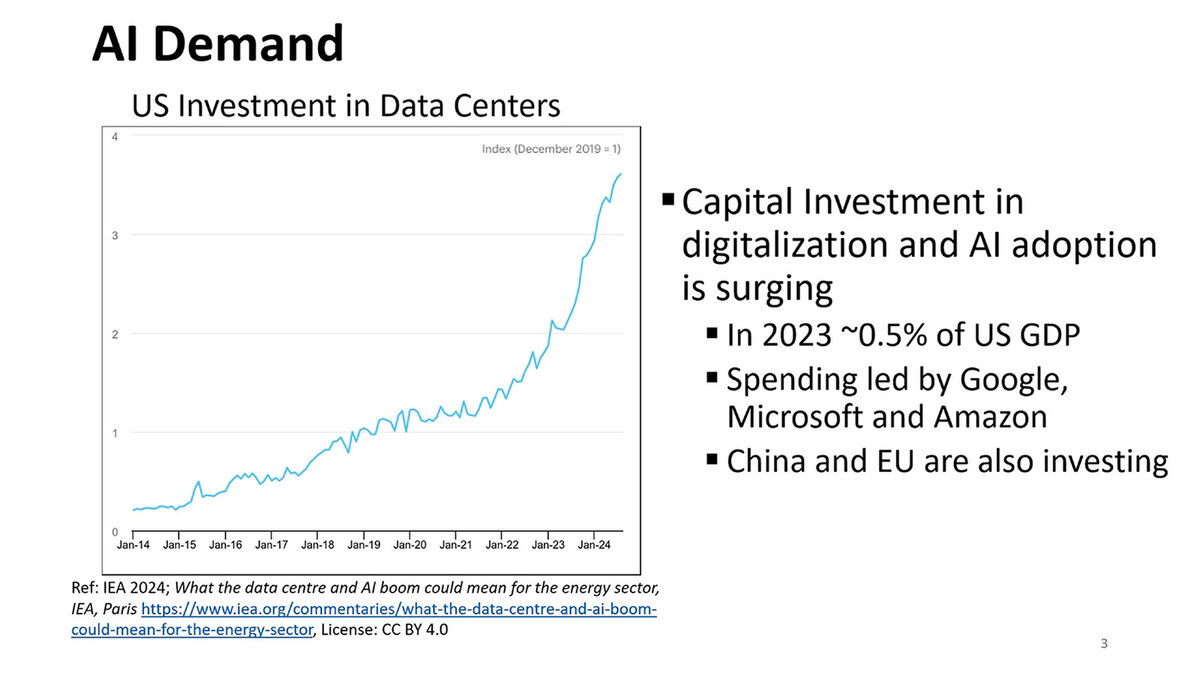

講演はまず市場概観から。2014年以降のAI関連の投資がすさまじいという話はこれまでもあちこちで言われている話である。

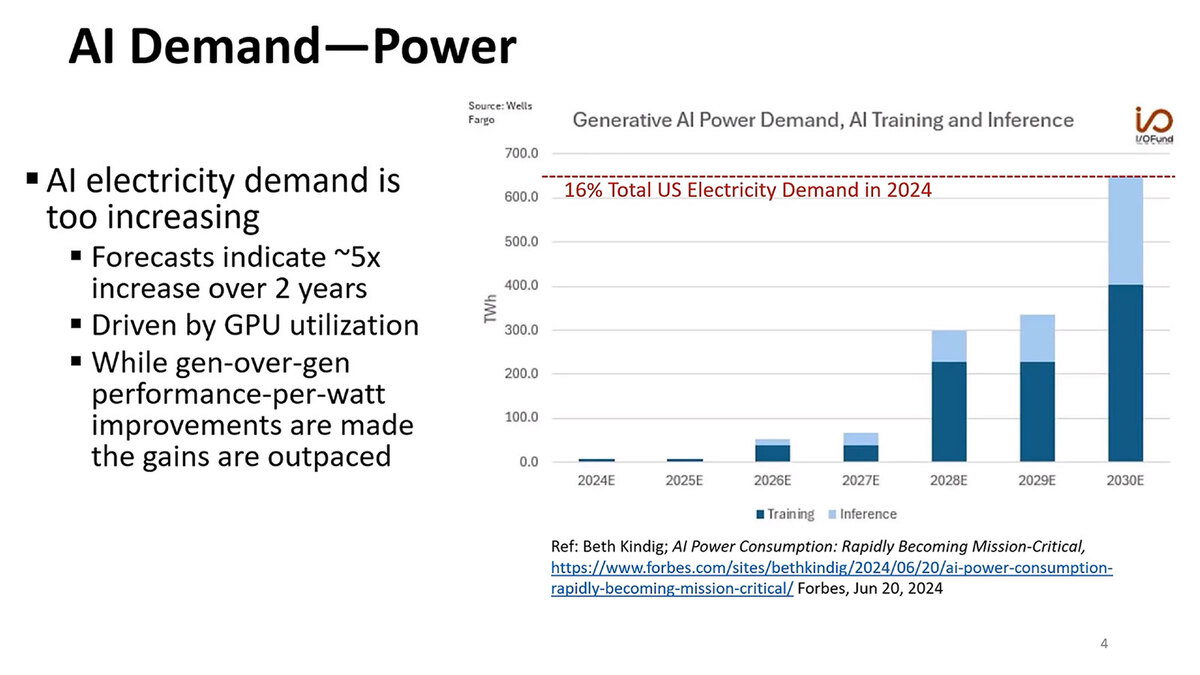

この結果として市場に急速にAI向けのシステムが導入されるようになったことで消費電力量が急増しているわけだが、現在の伸びからの推定で言うと、2030年末にはアメリカの消費電力量の16%を占める、という衝撃的な推定がなされている。

興味深いのは、現状はほとんどがAIのトレーニング向けで占められている電力消費が、今後は次第に推論もバカにならなくなると見られていることだ。LLM(大規模言語モデル)の推論は結構な消費電力を必要とするのは事実である。

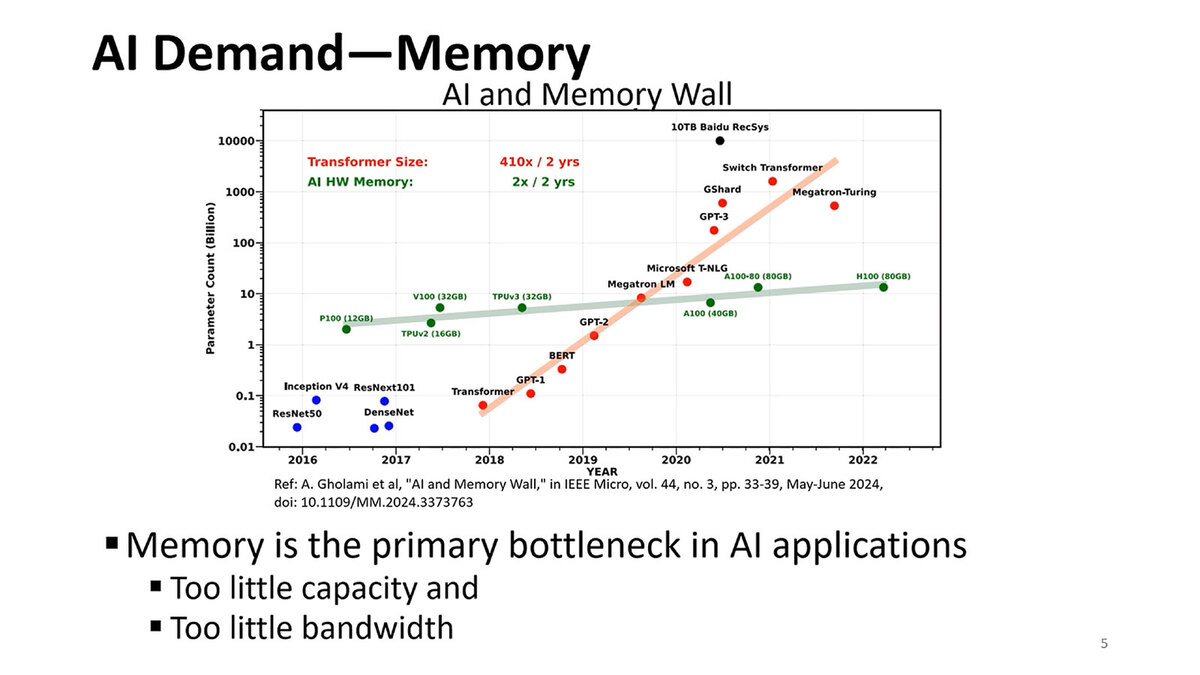

もう1つ問題になっているのがメモリーの問題である。メモリー容量は2年で2倍という、これはこれで猛烈なペースでの増加になっているが、特にLLMの方は2年で410倍という、尋常ではない勢いでネットワークが拡大しており、この結果メモリー容量とメモリー帯域の両方が足りない現象が起きている。

メモリー容量「だけ」の問題なら、それこそSCM(Storage Class Memory)を利用すればなんとでもなるのだが、当然こうしたメモリーは演算速度に全然追いつけないほどに遅いので、結局メモリーアクセス待ちになってしまう。メモリー容量と帯域の両方を向上させないといけない

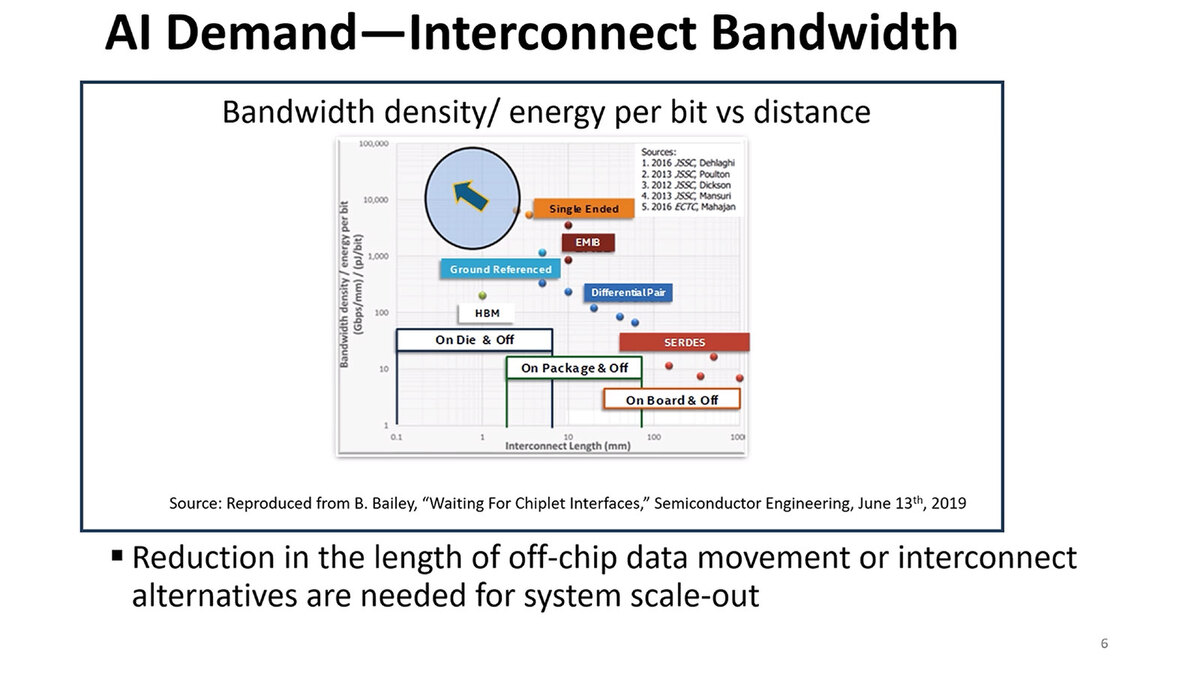

このメモリーに絡んでもう1つあるのがインターコネクトの能力不足である。単にチップレットだけでなく、昨今はモジュールを複数接続してキャビネットに収め、そのキャビネットを集積したラック同士をさらに接続というようにスケールアウトの方向にどんどん展開しつつある。

Single Ended、つまり1本の信号線で済ますのが一番エネルギー効率が良いのだが、当然制約がいろいろあるし、なにより到達距離が非常に短いものになる(チップレット間の通信ですら怪しい)。Single Endedは現状、3D積層の接続くらいにしか使えないことになりそうだ

また、オンダイで集積できるメモリーの量に限界がある以上、ダイの外にメモリーを集積する形になるため、このメモリーとの接続もまた問題である。余談だが上のグラフ、縦軸が単位距離・単位消費電力当たりの転送速度という複雑なものになっているのがおもしろい。

連載801回で少し触れたが、UCIeはStandard Packageで1mm幅に56対、Advanced Packageで330対の信号を通せる。配線密度が上がれば信号速度を落としても帯域は確保しやすいわけで、このあたりもバーターになっている。結果、縦軸がGbps/mmをpJ/bitで割る、という形になっている。

ちなみにスライドの一番下にあるように、データの移動をどうやって減らすかがキーであり、これを突き進めるとIn-Memory Computingになるわけだが、現状では汎用性がないので、なにかしら汎用プロセッサーと組み合わせないと処理が難しい。

さらに、In-Memory Computingといっても1つのダイに収められるComputation Unitとメモリーの量には限界があるから、スケールアウトを考えると結局なんらかのインターコネクトが必要になるので、結果としてIn-Memory Computingだけで解決するわけではない、というあたりが難しいところである。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります