AWS(Amazon Web Services)のCEOとして初めてAWS re:Invent 2024の基調講演の舞台に立ったマット・ガーマン氏。前半ではコンピュート、ストレージ、データベースの改善を説明するある意味クラシカルな内容だったが、後半は生成AIへの取り組みが満載。元AWS CEOであるAmazon CEOのアンディ・ジャシー氏もゲストとして登壇し、独自開発の基盤モデル「Amazon Nova」を発表した。

生成AIはコアのビルディングブロックになる

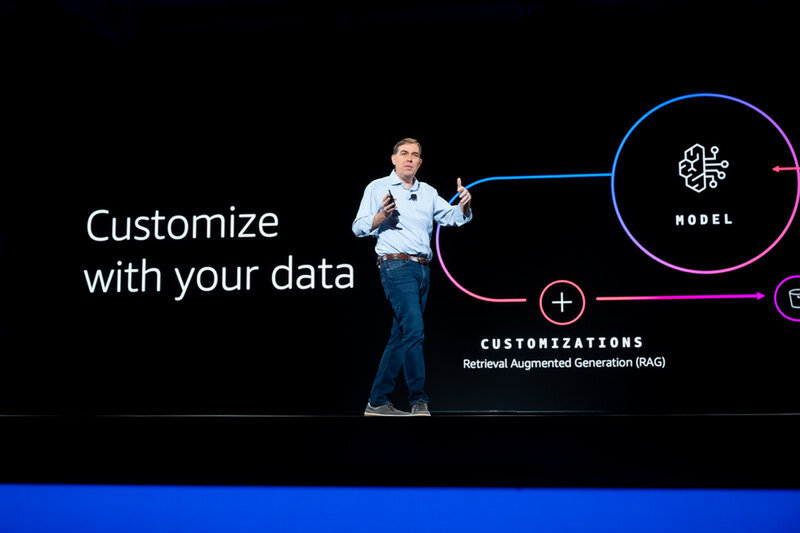

2日目の基調講演の前半、AWSのサービスを構成するコンピュート、ストレージ、データベースのサービス概要と新機能を説明してきたガーマン氏(関連記事:AWSの再構築が始まった “既存の”ビルディングブロックはどう変わったか?)。新たにビルディングブロックに加えたのがAI開発に必要な「推論」だ。「生成AIの登場でアプリケーションの考え方が変わってきている。生成AIはすべてのアプリケーションにとってコアのビルディングブロックになる。今後アプリケーションはなんらかの形で推論を必要とするのではないか」とガーマン氏は語る。

生成AIアプリケーションの開発に必要なデータを統合し、適切な性能、セキュリティ、コストで提供できる生成AIのプラットフォームがAmazon Bedrockになる。Amazon Bedrockは昨年は従来の5倍の成長を遂げており、エンドユーザーが直接利用するだけではなく、SAPやWorkdayなどのSaaSにその機能が組み込まれている。

Amazon BedrockはAmazon、Anthropic、AI21Labs、cohere、Meta、Mistral AI、Stability.aiなど数多くの選択肢からニーズにあった基盤モデルを選べるのが特徴だ。一方で、専門家でない限り、やりたいことに応じた基盤モデルの選択は難しい。昨今は基盤モデルも精度一辺倒でなく、コストやサイズでさまざまなモデルを用意しているため、「適切な回答を適切なコストで得る」ためのハードルはますます上がっているとも言える。

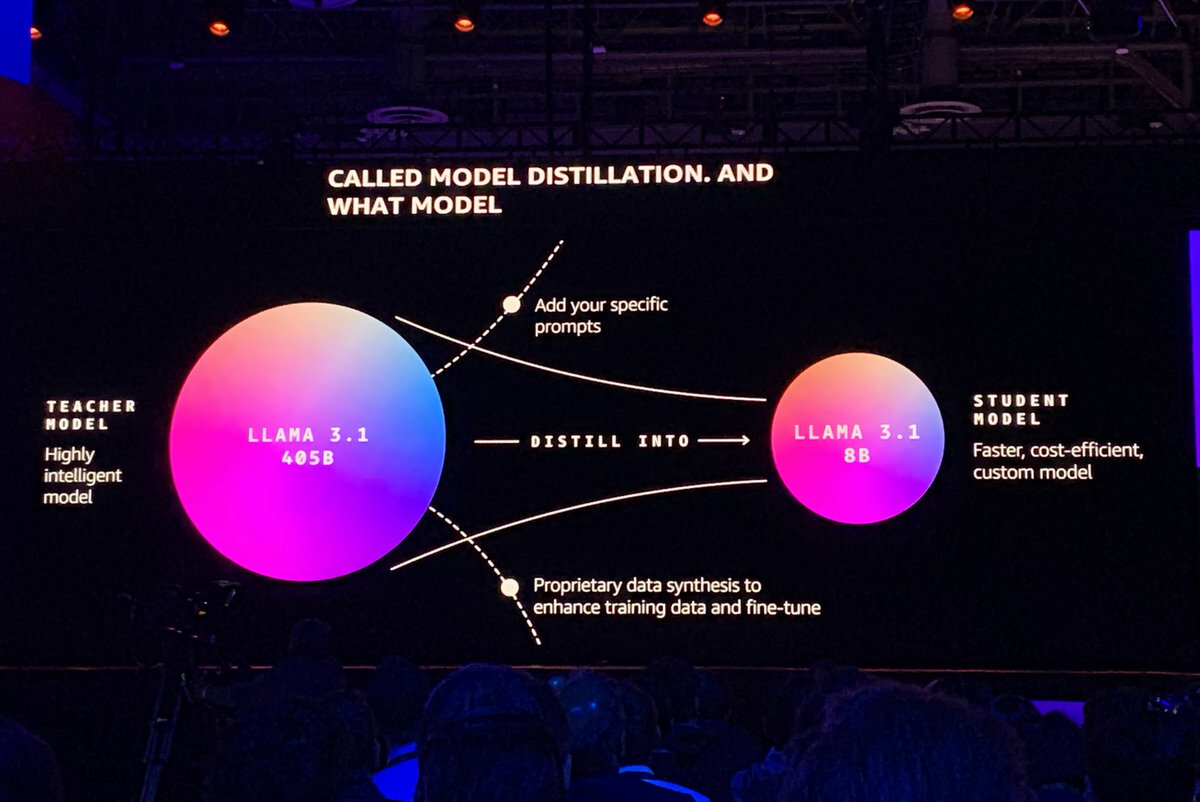

これを実現するため、Amazon Bedrockには「Model Distillation」という機能追加された。Distillationは「蒸留」を意味しており、モデル蒸留を意味する。Model Distillationでは大規模で高い能力を持つモデルを元に、特定のユースケースにおいて同等の能力を持ちつつ、小型・高速・コスト効果の高いモデルを利用できる。

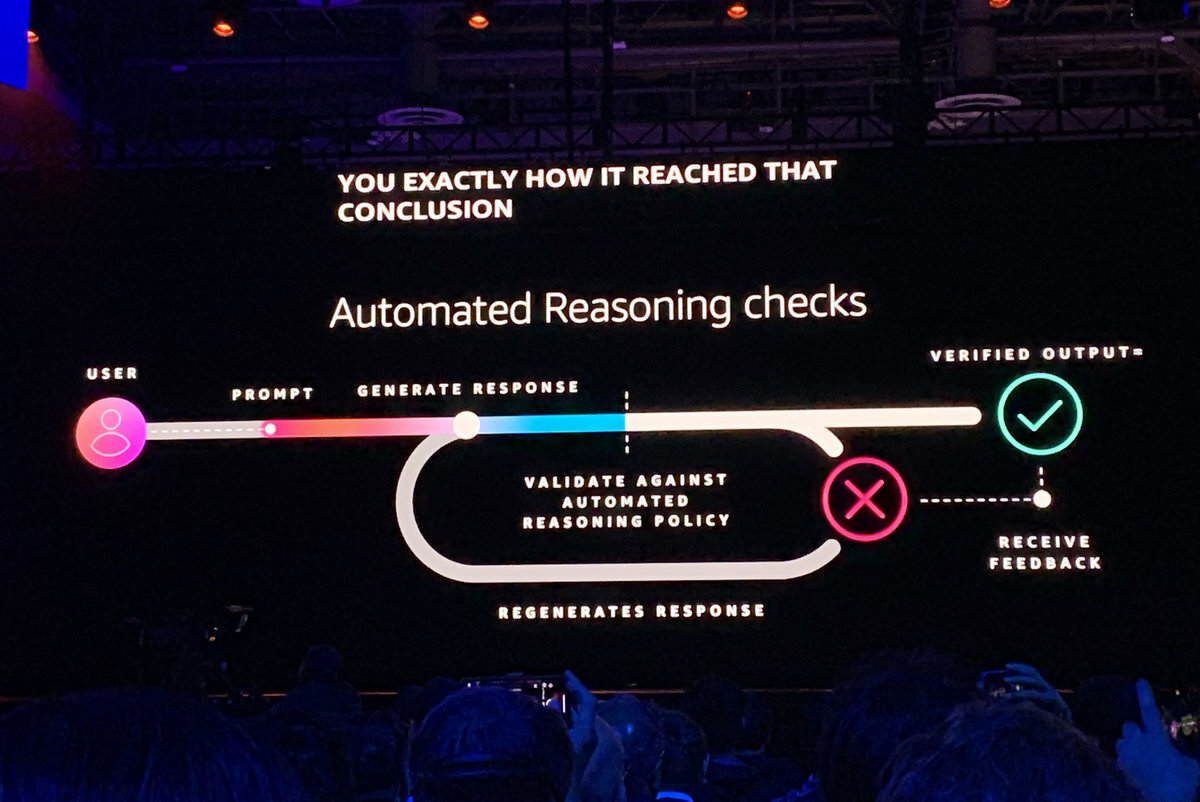

また、モデルの応答がポリシーに準拠していることを数学的な手法で検証し、ハルシネーションを排除する「Amazon Bedrock Guardrails Automated Reasoning check」も用意された。たとえば、保険分野のチャットボットであれば、政治的な話や医療的なアドバイスをしないように質問に答える範囲を限定することができる。高い精度を要求される用途に対して、生成AIの適用を可能にするセーフガードとして利用することが可能だ。

さらに複数のAmazon Bedrock Agentのコラボレーションも可能になった。タスク解決のための複数のAIエージェントのオーケーストレーションが容易になり、データへのアクセスポリシーやエージェントの並列実行など複雑なワークフローも処理可能になった。複雑なニーズに対応するエージェントを迅速に構築・デプロイできる。金融アナリストのリスクマネジメントを提供するムーディーズは、1週間かかっていたリスクレポートの作成を複数エージェントの連携により、PoCでは1時間にまで短縮できたという。

Amazon CEOのアンディ・ジャシー氏が登壇 古巣で「Amazon Nova」発表

実際の生成AIの活用ユーザーとして登壇したのは、AWSのCEOからAmazon CEOとなったアンディ・ジャシー氏。ガーマン氏は、「私の友達、クラウド業界のゴッドファーザー」と紹介する。

Amazonは顧客ごとのパーソナライズやリコメンデーション、需要予測などさまざまな場面でAIを活用してきた。顧客からの問い合わせは、セルフサービス、コンタクトセンターなどいろいろ用意されているが、チャットではユーザーの購入履歴などを元に、到着時間や返品の案内などを自動生成。人間のエージェントと連携しながら、満足度を高めている。また、200万人いる売り手向けには、AIによるページ作成サービスを提供している。

フルフィルメントセンターでは、顧客のもっとも近くから配送できるように在庫と照らし合わせたり、在庫を管理するための需要予測を行なっている。商品ピックアップではAI+ロボットを現場投入。スパローというロボットは、出荷が必要な商品をピックアップし、箱に適切に詰め込むところまで行なう。PoCで終わらせない実践的な使い方が印象的だ。

ショッピングアシスタント「Rufus」を使えば、まだ買いたいモノが定まってない場合でも、店員に相談する感覚でショッピングを楽しめる。商品の詳細を調べたり、類似製品を比較したり、カテゴリごとのリコメンデーションも可能だ。AIデバイスのはしりであるAlexaも数ヶ月後には生成AIを組み込んだモデルが登場する見込み。「現在、生成AIには、ニーズを聞いて、アクションに結びつけるものがない」(ジャシー氏)とのことで、5億のアクティブノードを持つAlexaには期待できる。

ショッピング体験を向上させる新しい利用提案もある。たとえば、Amazon Lensは撮影したモノを画像認識し、そのまま買い物が可能なアプリ。「友人のうちに鉢が素晴らしかったら、Amazon Lensで写真を撮れば、検索できる。マルチモーダルに対応するので、まさに魔法のような体験だ」とジャシー氏は語る。

また、Sizingには多くのブランドの服のサイズが登録されているので、顧客の既存の購入履歴から最適と思われるサイズを割り出すことができる。また、Prime Videoで配信されているNFLの番組には「NextGen Stat」が導入され、弱点となっているゾーンが画面上にオーバーラップされる。いずれもClaudeやLlamaなどのLLMをベースに構築されており、Amazon社内では1000ものアプリが開発されているという。

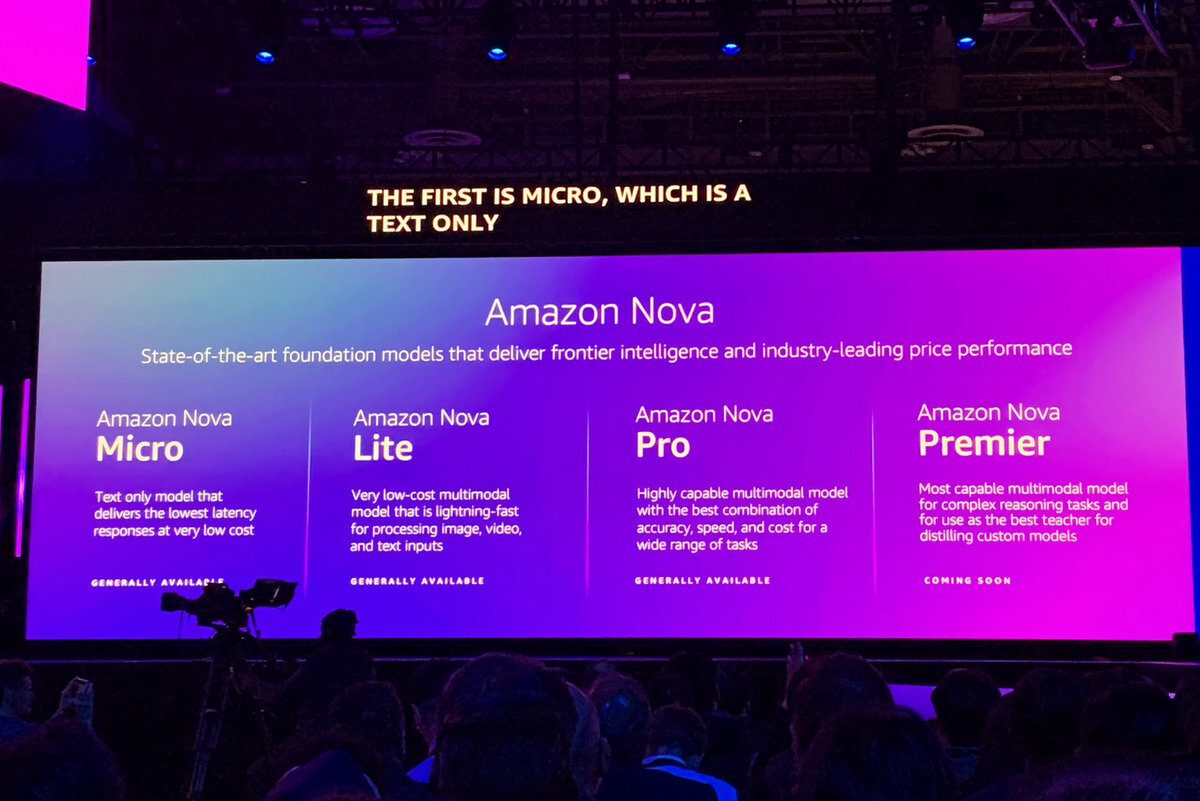

今回はこれらのサービスに活用されているAmazon自社開発の新しい基盤モデルがAmazon Bedrock向けに提供されることになった。「Amazon Nova」と名付けられたこの基盤モデルは「State-of-the-art foundation models that deliver frontier intelligence and industry-leading price performance」と説明されており、性能とコストパフォーマンスを特徴とする。

Novaはテキスト対応の「Micro」、マルチモーダル対応の「Lite」、マルチモーダル対応で、速度とコストのバランスに優れた「Pro」、カスタムモデルの教師に向いた「Premier」の4つのプランが用意されている。特に競争力の高いMicroは、「LlamaやGeminiと比較したベンチマークでは、両者と同等、もしくは超える性能を出している」(ジャシー氏)とのこと。また、他社に比べて75%もコスト効果が高いという。

画像生成モデルの「Amazon Nova Canvas」と動画生成モデルの「Amazon Nova Reel」も発表。詳細は不明だが、「Amazon Nova Speech-to-Speech」と「Amazon Nova Any-to-Any」というモデルも提供予定。AWSはこれまでもTitanブランドで自社基盤モデルを提供してきたが、Amazon自体からの基盤モデルも追加され、Amazon Bedrockはますます選択肢が増えることになる。

Amazon QがIT部門を救う .NET、メインフレーム、VMwareからの移行を支援

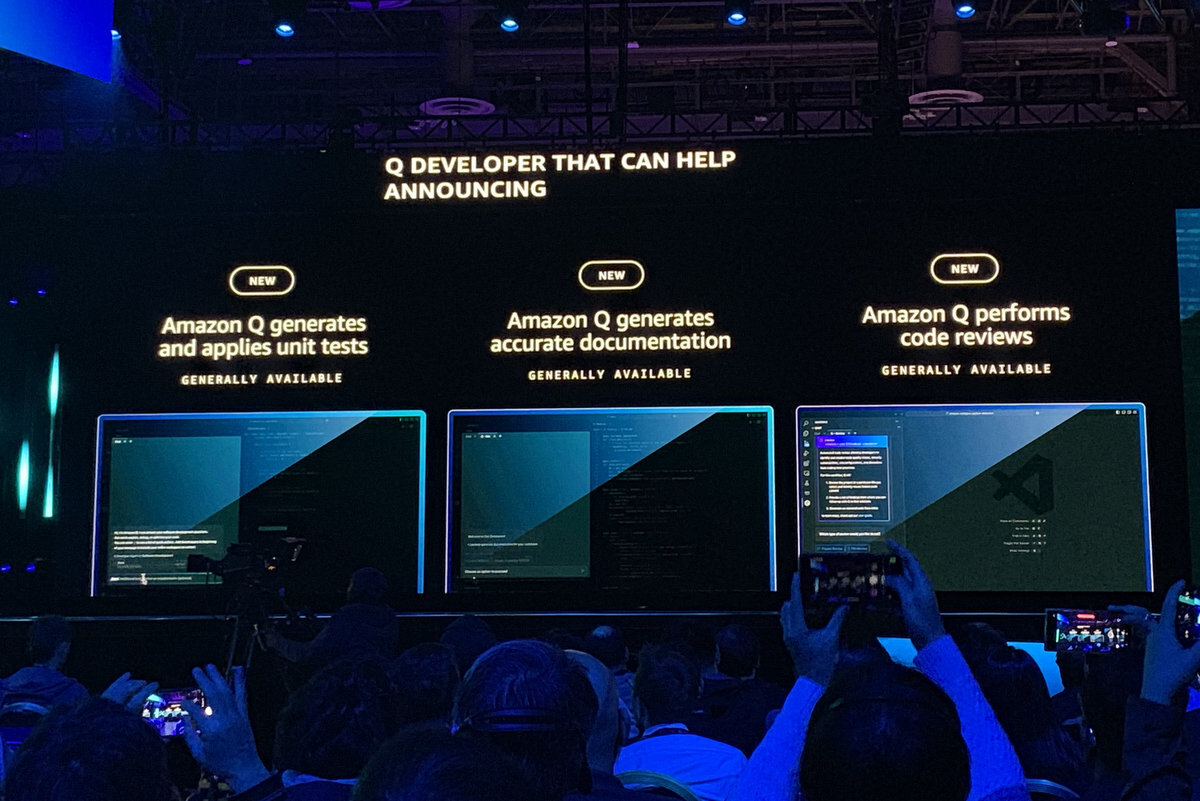

舞台に戻ってきたガーマン氏がフォーカスしたのは、AIアシスタントのAmazon Qだ。開発者向けのAmazon Q Developerには、ユニットテストとドキュメント作成、コードレビューの3つのエージェントが追加された。エージェントは、コンソールや開発ツール、Slackなどさまざまなツールから呼び出せるが、このたびGitLabのDevSecOpsプラットフォームにAmazon Qのエージェント機能が組み込まれることも発表された。「開発者がもっと付加価値の高い作業に集中できる」とガーマン氏は語る。

Amazonは社内のJavaアプリケーションのモダナイズで生成AIを活用し、大きな成果を挙げている。モダナイズ対象のアプリは1万を超えており、これらを人手で移行すると、なんと4500年(!)かかっていたという。ハードウェアも減っているため、2億6000万ドル相当のコスト削減にもつながっているという。

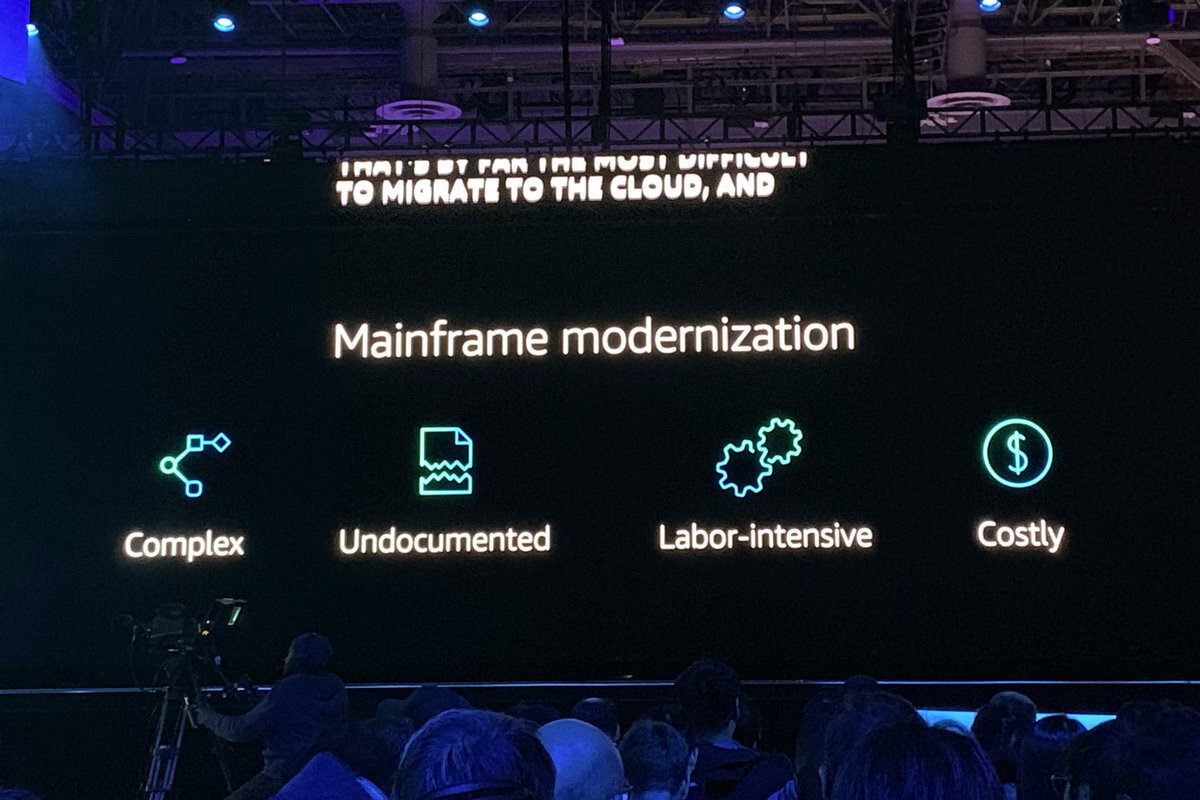

今回はAmazon Q Developerでは「.NETアプリケーションのクロスプラットフォーム化」「メインフレームのモダナイゼーション」「VMware環境の変換」などのシステム移行支援機能が強化された。

.NETアプリケーションの移行機能では、Windowsベースの.NETアプリから、Linuxを含むクロスプラットフォーム対応の.NETへの移行を支援。非互換性を検出し、変換プランを提案し、ソースコードをリファクタリングする。これにより、作業を最大4倍高速化し、Linux化することでライセンスコストも最大40%削減する。

メインフレームの移行機能はIBM z/OSの対象コードを読み込み、アプリケーション資産を分類・整理。ユーザーとの対話を通してモダナイゼーションの計画を立案するとともにドキュメント生成までを自動的に行なう。レガシーなCOBOLからJavaへの変換にも対応する。

VMware環境の変換では、VMwareベースのシステムのEC2ベースへの移行を支援する。エージェントがIDの依存性やネットワーク設定などを調べ、プランを生成。セキュリティと耐障害性を向上し、コスト削減にも寄与するという。

Amazon Q DeveloperはAWS環境全体の運用調査も行なう。「Operational Investigation Capability」では、クラウド環境と稼働中のリソースの知識に基づき、問題とその原因を検出。解決のためのステップを提案する。

AIとデータ分析を融合した次世代のSageMakerの姿とは?

ビジネスパーソン向けのAmazon Q Businessにおいて、AIとデータ分析との融合がうち出された。従来別々だったデータ分析とAIだったが、ワークロードとしては共通化が進んでいる。AWSでもAIとデータ分析はそれぞれプロダクトのピラーが異なっており、これらを連携・融合させていくのは、プラットフォーマーとして必要な方向性と言える。

まずは同社のBIツールQuickSightで利用しているデータベース、データレイク、DWHのデータとAmazon Q Businessをインデックス上に統合する。Amazon Q Businessでは顧客とのメール、通話履歴、発注書、顧客情報などが蓄積されるため、両者を統合することで顧客に対する正しい洞察が得られる。また、ISVと呼ばれるサードパーティとのデータを取り込み、Amazon QからアクセスできるAPIを提供するほか、複雑なワークフローの自動作成も可能になった。

AIとデータ分析が統合されたベストな形は、データ管理、AI、アナリスティック、カタログ、ガバナンスなどが1つの画面から扱えることだ。これを実現すべくAmazon SageMakerはAIとデータ分析を統合環境としてリブランディング。既存のSageMakerは「SageMaker AI」となり、データ分析のためのAmazon EMR(データストア)、AWS Glue(ETL)、Amazon Redshift(DWH)、Bedrockなどで利用可能な機能を統合した次世代Amazon SageMaker「Amazon SageMaker Unified Studio」が新たに提供される。ユーザーはAIとデータ分析を統合した環境で、ユースケース全体で最適なツールを利用できる。

さらにAmazon SageMaker Lakehouseでは、S3のデータレイク、RedshiftのDWHをはじめ、サードパーティのデータソースを統合するオープンデータアーキテクチャが提供される。Amazon SageMaker LakehouseとRedshiftでは、SalesforceやSAP、ServiceNow、Zendeskなどの8つのアプリケーションがZero-ETLで統合される。

「私はいま未来に対して、エキサイティングな気持ちでいっぱい。イノベーションはAWSだけではなく、お客さまやパートナー、企業、スタートアップなどのイノベーションもある。今はイノベーションに最適なとき」と語ったガーマン氏は、「We invent so you can reinvent」を掲げて降壇した。

2014年、re:Inventに登壇したアンディ・ジャシー氏は「クラウドはニューノーマルになった」と宣言した(関連記事:「クラウドは“新しい標準”になった」AWS re:Inventを振り返る)。あれから10年が経ち、クラウドが新しい標準になったのは間違いないが、時代はすでにAIとデータ分析という次の標準に向かって動いている。革新的なサービスとビジネスモデルでクラウドの代名詞となったAWSが、AI時代でもリーディングポジションを確保できるのか。新しいAWSのリーダーであるガーマン氏の今回の基調講演は、そのスタート地点になる内容だったと思える。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります