SORACOM Tech Days 2021でAIカメラの最前線を学ぶ

今ある監視カメラをエッジAIデバイス化 AWLが創意工夫で実現した店舗DX

2021年12月14日 10時00分更新

11月16・17日、オンラインで開催された「SORACOM Tech Days 2021」には、AWL取締役CTOの土田安紘氏が登壇。「AI×カメラ活用最前線 リテール業界にイノベーションを起すプロダクト開発」というタイトルで自社サービスの紹介と自身のエッジAIにかける思いを語った。

AIの社会実装への思いが捨てきれず起業

土田氏は北海道大学在学中、現在のAIの基礎となっているニューラルネットワークの研究をしていた。だが、当時はコンピューターリソースが乏しく、AIのアプリケーションを作ることはできなかった。

2001年に大学卒業後パナソニックに入社、モバイル通信事業者向けソフトウェアの開発を主導し、社内ベンチャーでシリコンバレーにて新規事業の立ち上げリーダーなどを務めた。

時は流れ、2012年にAIの画期的な技術が登場したことで、土田氏は再びAIの開発に戻る決断をする。「その後にAIが社会に実装されていくきっかけとなる畳み込みニューラルネットワークの『アレックスネット』が登場した。これを見て、大学時代に取り組んで諦めていたAIに再挑戦したいという思いが沸き起こり、AWLを立ち上げた」

AWLは2016年に創業。北大発の認定ベンチャーとして、川村秀憲教授と北出宗治社長、土田氏ら数名のメンバーでスタートした。ちなみに社名は、AIにふくろうを意味する「OWL」を合成した造語である。

現在は84名の社員を抱え、東京本社、札幌本社、北大のラボ、そしてベトナム・ハノイの4拠点で事業を行っている。土田氏は札幌本社に所属し、AI技術の開発を主導している。その技術を東京本社側で営業する事業体制となっている。

同社のもう1つの特徴は、グローバルな人材が集まっていることだ。社員の国籍は17カ国におよぶ。ハノイの拠点で開発を行うほか、AIの開発で有名なインド工科大学との共同研究も進めている。

既存の店内カメラをAI化できるエッジAIソリューション

同社が手がけている技術が「エッジAI」だ。エッジAIとは何か。土田氏は同社の主力製品である「AWLBOX」の説明とあわせて話を進めた。

AWLBOXは、VMSと呼ばれている店舗などのセキュリティカメラの画像を蓄積する装置にAIを搭載したものである。セキュリティカメラの信号を、既存のVMSからAWLBOXにつなぎかえることで、エッジAI化を実現し、来店客のさまざまな分析ができるソリューションだ。

具体的には、カメラの画像から人物の性別、年齢などの情報を割り出し、店舗のオペレーション改善に生かすことができる。「AI用に、新しくカメラを設置する必要がなく、すぐにAI技術を導入できる。この技術で特許も取得している」(土田氏)

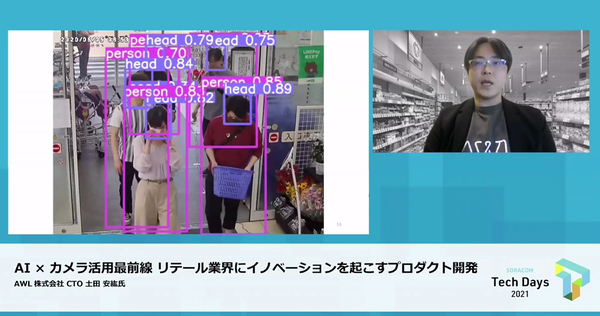

実際に、店舗入り口に向けたカメラに同社のエッジAI技術を採用したデモでは、大量の来店客が店内に入ってくる映像で人物の顔を検出し、来店者数をカウントしたり、年齢性別などを特定していた。

これをさらに進めて、1人の来店客をトラッキングし続ける技術も搭載する。混雑した店内で人の後ろに隠れても、同じトラッキングIDを維持できる。「これによって入店から退店まで、お客さまがどんな行動をとったのかを理解することができる」(土田氏)

店内に置かれた複数のカメラで人物の情報を追い続け、IDによってはじめての来店か再来店か、レジ待ちにどれぐらい時間がかかったか、買い周り、ついで買いの傾向などを分析できる。「これらのデータと店舗のPOSデータ、棚割データなどを組み合わせて、店舗のオペレーションを改善し、売り上げ向上につなぐことができる。つまりAWLBOXによって、店舗DXが実現する」(土田氏)

一見すると、このようなソリューションはすでに珍しいものではない。AIで人物を特定するためのプログラムコード程度は、GitHubなどで公開されているほど一般的だと思う人がいるかもしれない。だが、それをエッジに実装するのは非常に困難で、高い技術とノウハウが必要だと土田氏は言う。

AIの実社会への実装には念入りなチューニングが必要

土田氏は、ディープラーニングが社会実装される歴史を紹介しながら、技術的な課題を説明した。

「ディープラーニングを用いたコンピュータービジョンは、アレックスネットの登場で一気に広まったが、当初は非常に大きなコンピューターリソースを消費したため、クラウドベースのGPUサーバーなどで利用されていた。それが2017年ごろから登場した新たなチップによって、エッジ上でも処理できる可能性が出てきた。それがエッジAIカメラの実現につながった」

グーグルやインテルなどから発売された「DNNチップソリューション」に、カメラを接続することで、IoTデバイスとしてAIカメラを実装できるようになったのである。たとえばDNNチップの先駆けとして登場したGyrFalcon2801Sは、非常に低消費電力で、高いディープラーニングの処理性能を誇っていた。

だが、いいことばかりでなく、畳み込みの処理方式は非常にシンプルなものしか使えず、そのままでは店舗のカメラで人物を識別するような用途には使えなかった。DNNチップだけで、実用に耐える性能と精度の両立は難しかったため、結局は、ホスト側のCPUパワーに頼ることになり、エッジの処理は小さくする必要があった。

そうなると、今度はエッジ側の汎用性が得られなくなって、特定の分野でしか運用できなくなる。「実際にやってみると、エッジAIカメラの社会実装は非常に難しいということがわかった」(土田氏)

そこで同社は、このようなエッジAIカメラの導入の難しさを解決する技術を開発、「AWLBOX system」と名付けた。

特徴は、合理的なコンピューターリソース配分のためのさまざまな工夫だ。たとえば店舗内に複数のカメラが設置されていると、入り口付近のカメラは多くの人が出入りするため、大量のGPUリソースを割り当てる必要がある。しかし店内の売り場を写すカメラは人が少ない時間が多く、あまりリソースを必要としない。

また、カメラが検知した入店人数に応じて、レジの開け閉めを調整するようなオペレーションは、店舗運営にとって非常に効果が高い。そのため人数カウントはリアルタイムでしたいというニーズは多い。逆に、年齢性別など来店客の属性に関しては、その場でわからなくてもいい。

このように、カメラの位置や利用用途によって必要なリソースは異なるが、それを柔軟に切り替えることで有効活用するのが、同社の「GPU MANAGER」という技術である。

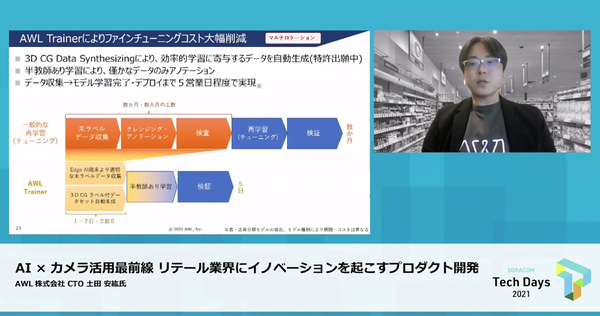

もう1つが、カメラの設置場所に合わせた学習の精度改善(ファインチューニング)である。カメラごとに画角や光源の位置などが異なり、全てのカメラに対して最適化した教師データを用意することは難しい。そこでAWLBOX systemでは、膨大な撮影データのうち、学習に必要な情報に絞り込んだごく一部(数%)の画像だけを自動的に抽出し、効率よくAIに学習させる。

また、実際にカメラに写っている画像が高年齢の男性だけに偏っていて、学習が進まないケースもある。そんなときはAWLが、3DCGによって女性や若者の画像を送り込んで、学習を促すこともできる。

これらの支援の結果、非常に高効率、短期間で店内AIカメラの学習が進むという。「多数の店舗にAIカメラを導入しても、少ないリソースで短期間の実装が可能になる」(土田氏)。実例では、客と店員の分類モデルの場合、データ収集から学習、運用開始まで5営業日程度で進めることができる。

土田氏は「当社は、エッジAIカメラという最先端技術の社会実装を進めている。私は技術が社会を変えていくと信じており、常にチャレンジとこだわりを持っていこうとチームのメンバーにも話している。これは技術者にとっては、自分の技術が世の中を変えていくというモチベーションになる」と語る。

現在のAWLは、資金調達を完了し、ここから事業を成長させて上場を目指すステージにいる。しかし土田氏は、「安定成長を目指すのでなく、先端技術にどんどん挑戦を続け、失敗を乗り越えて新しい技術を生み出していきたい」と意気込みを語った。

週刊アスキーの最新情報を購読しよう