|

|---|

2015年のNVIDIAは、車載型カーコンピューターに大きく舵を切ることになりそうだ。

1月4日(現地時間)、アメリカ・ネバダ州ラスベガスで開幕するCES2015の前夜祭イベントに合わせる形で開催された、NVIDIAのカンファレンス。

事前の業界情報で「モバイル専門のプレスに案内がないらしい」といった情報があったこと、また今回はCES2015の噂として「自動車系の大きな発表があるのでは?」と言われていたこともあり、NVIDIAがここ数年発表はし続けていてつつも、なかなか現実的な結果が出ていなかったAutomotive分野の何かを発表するのだろう、程度に考えていた。

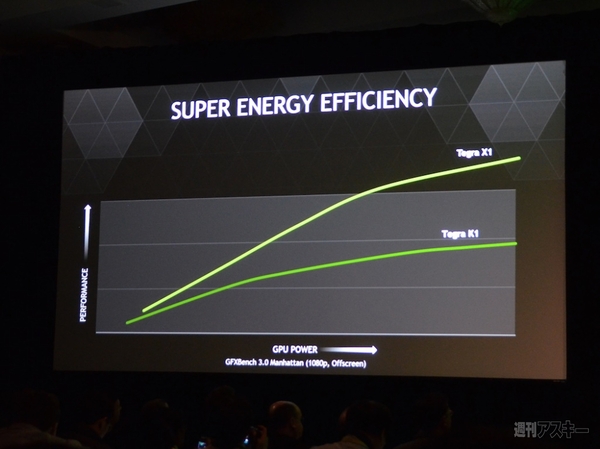

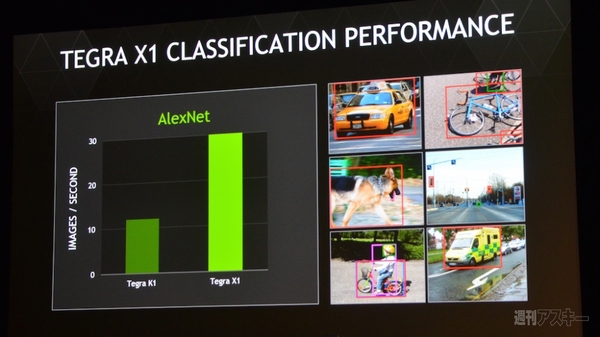

そうしてカンファレンスでまず発表されたのは、GPUを最新のMaxwellアーキテクチャに刷新したSoC、『Tegra X1』。昨年発表されたTegra K1の後継にあたり、世界最速のテラフロップス級モバイルプロセッサをうたう。パフォーマンスはK1に対して2倍という。

|

|---|

| ↑Tegra X1チップを持つ、ジェンスン・ファンCEO。 |

|

|---|

| ↑GFXベンチ3.0の結果を示し、K1に対して2倍の性能と説明。 |

例年であれば、X1を搭載したタブレットのデモや、新たなGPUの発表などを織り交ぜていくところで、そのなかのひとつとして自動車関連の取り組みが発表されるのだろうと考えていた。ところが、今年はまったく違った。

「X1の1テラフロップスもの馬力を何に使うか?きっと、電話には必要ないでしょう。我々は、未来のクルマにこそ必要だと考えている」

ジェンスン・ファンCEOがそう語るや、以降すべての説明が車載型コンピューターとその研究成果の話題に注がれることとなった。

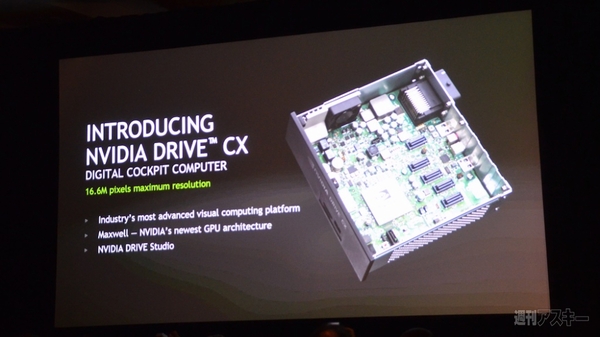

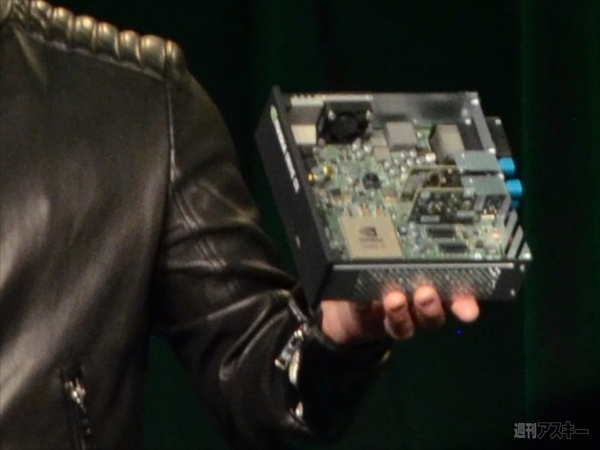

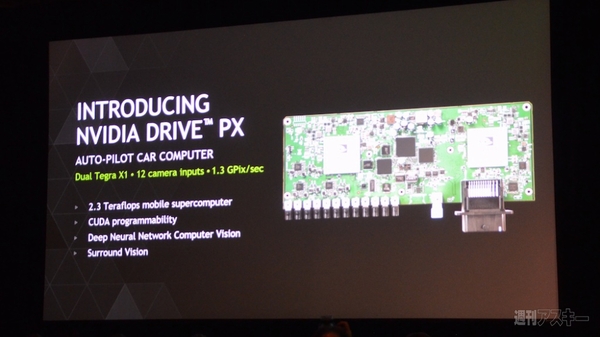

Tegra X1をコアとする自動車用車載コンピューター、『NVIDIA DRIVE』シリーズの発表だ。2製品があり、『DRIVE CX』はメーターからダッシュボードまで含めたバーチャルコクピットを実現するTegra X1を1基搭載するカーコンピューター。一方の『DRIVE PX』はTegra X1を2基搭載し、高度なリアルタイム画像認識処理が可能な自動運転の開発プラットフォームだ。

|

|---|

|

|---|

| ↑DRIVE CXのスライド(上)と、ジェンスンCEOが見せた実機(下)。小型PCのような集積度だ。 |

|

|---|

|

|---|

| ↑DRIVE PXのスライド(上)と、同じくその実機(下)。目視で、Tegra X1が2つ搭載されていることがわかる。 |

■車載ディスプレイの情報量は今後6年で25倍に増える

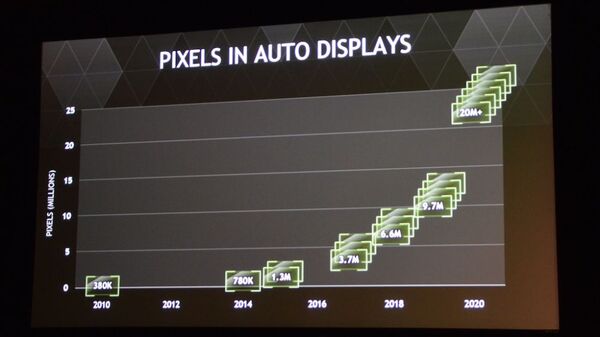

ジェンスンCEOがTegra X1を「未来のクルマに必要だ」と語った理由の1つとして、車載ディスプレイの情報量の増加があげられる。

NVIDIAは、2014年にはクルマ1台あたり78万画素だったディスプレイ処理が、2020年には2000万画素以上になると予想。これは、単純に高解像度化するというだけではなく、メーターやダッシュボードの操作ボタンなど、さまざまな部分がディスプレイ化されることによる、「枚数の増加」によるものも大きい。

現時点でその進化イメージに最も近いのは、テスラモーターズの『Model S』のようなインストゥールメントパネルの設計だ。

NVIDIAはこうしたディスプレイ化されたコクピットをバーチャルコクピットと呼んでいた。壇上のデモでは、CXのソフト「DRIVE Studio」を使って、フル3D化されたカーナビや色調や素材感が一瞬にして変更できるバーチャル・スピードメーターなどを見せていた。

カーナビについては、デジタルデータの提供元とセット考えなければ実現しないという問題はあるものの、ハンズオンで触ってみた感触としては、拡大縮小のスムーズさ、ナビや車外ディスプレイとのシームレスな連携などに可能性は感じた。

|

|---|

| ↑NVIDIAによる、車内ディスプレイのピクセル数の増加予想。 |

|

|---|

| ↑NVIDIAが提案するバーチャルコクピットのデモ機。こういう操作パネルになれば、確かに扱う総ピクセル数は大幅に増える。 |

■ディープラーニングで車両や人を見分ける自動運転コンピューター

そして今回の取り組みの中で最長の時間を割いて説明されたのがDRIVE PXによる自動運転技術の解説だ。DRIVE PXには最大12個のカメラを接続でき、そのうち3台をフロントの異なる方向に設置、そのほかをリアやサイドなどに設置。さらにデュアル4K/30pでの映像記録も可能という。

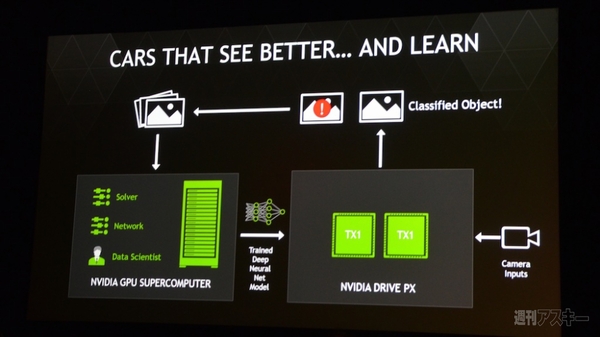

こうして入力されたカメラからの対象物認識には、ディープラーニング(深層学習)が使われている。脳の学習方法を数学モデルでシミュレーションするニューラルネットワークの手法だ。DRIVE PXは最大75個の対象物を同時に認識でき、車両の周囲の環境を理解する。

仮に認識できない対象物があった場合は、データセンターに情報が送られ再学習され、DRIVE PXに反映される仕組みになっているという。

|

|---|

| ↑映像のオブジェクト認識は、あらかじめNVIDIAのスパコンでディープラーニングしておき、その学習結果をもとにカメラインプットからの映像情報を処理する。分類できないオブジェクトがあった場合は、それを再度学習するというサイクル。 |

カンファレンス後半、壇上に上がったドイツの自動車メーカー アウディのエレクトロニックデベロップメント担当の副社長・リッキー・ヒューディ氏は、NVIDIAとの共同の取り組みに賛辞を送り、「本日、我々は自動運転のマイルストーンを迎えた。初の長距離自動運転ツアーを開始し、シリコンバレーからラスベガスまでを8人のジャーナリストとともに行っている。彼らは1日目の目的地・Bakersfieldに無事に到着した。そして明日、ラスベガスに到着する」と語った。

ということは、おそらくCES2015の会場で、シリコンバレーからはるばる880キロを走ってきた自動運転カーの姿を拝めることになるのだ!アウディの自動運転カーの取り組みは、「Audi RS7 piloted driving」というプロジェクトとして以前からサーキットで行われていたものの、公道かつこれだけの長距離とは驚くほかない。

とともに、同様の社会実験を日本で行うことは法規以外の側面も含めて実現が非常に困難だろうことを考えると、アメリカの状況はうらやましくもある。

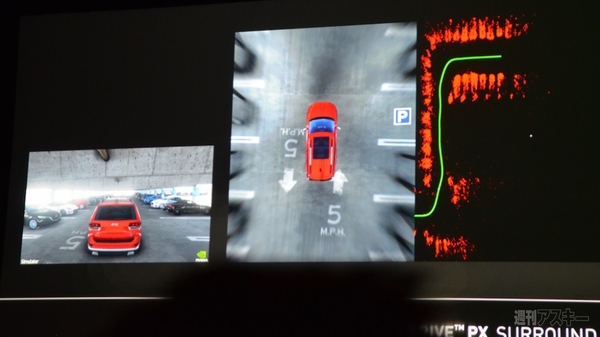

カンファレンスではこのほかNVIDIA独自の取り組みとして、「Auto-Valet」機能も紹介された。NVIDIA本社のガレージを3D空間で詳細に再現し、DRIVE PXで仮想運転させるというもの。車自身が時速8キロで走りながら周囲の車両や空間を認識し、空いた場所をみつけ、自動的に車庫入れするという様子を見せた。

仮想とはいえ、クルマの周囲のカメラ映像までシミュレーションして実行されているので、実車への導入も現実的な気がする。

大きな展示こそなかったものの、NVIDIAとアウディの自動運転の取り組みは自動車業界にとっても大きなマイルストーンになるだろう。無事、CES2015開催地のラスベガスにやってこられるのか?その結果は続報でお届けします!

|

|---|

| ↑シリコンバレーからスタートしたAudi A7 Sportback piloted driving concept car。ハイウェイをひた走り、ラスベガスに向かう。 |

|

|---|

| ↑Auto-Valet(オートバレー)機能のデモ。中央の写真は、仮想カメラの映像を実際のカメラのように読み込んでつくった頭上視点の映像。左の緑の線は、走った奇跡で、周囲の赤い部分が障害物(クルマ)と認識していることがわかる。 |

|

|---|

| ↑Tegra X1とK1の単位秒あたりに認識できるイメージ数の比較。X1が1秒に30イメージ認識できるのに対し、K1はその半分ほどだ。 |

|

|---|

| ↑実際に車両認識をさせている映像。左は、背後カメラで、トラックとパトカーをそれぞれ認識している。右は「つい先日撮影した」と語っていたラスベガス市内中心部の道路風景。それぞれ車種が違うクルマをVAN、SUV、SPORTSCARといったように分類認識できている。 |

|

●関連リンク

NVIDIA CES2015特設サイト(英語)

Audi USA CES2015出展情報リリースPDF(英語)

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります