GeForce RTX 50 SUPERシリーズは……発表なし

画質向上&フレームレート6倍のDLSS 4.5にG-SYNC Pulsarディスプレーの発売など、NVIDIAのCES 2026発表まとめ

2026年01月06日 14時30分更新

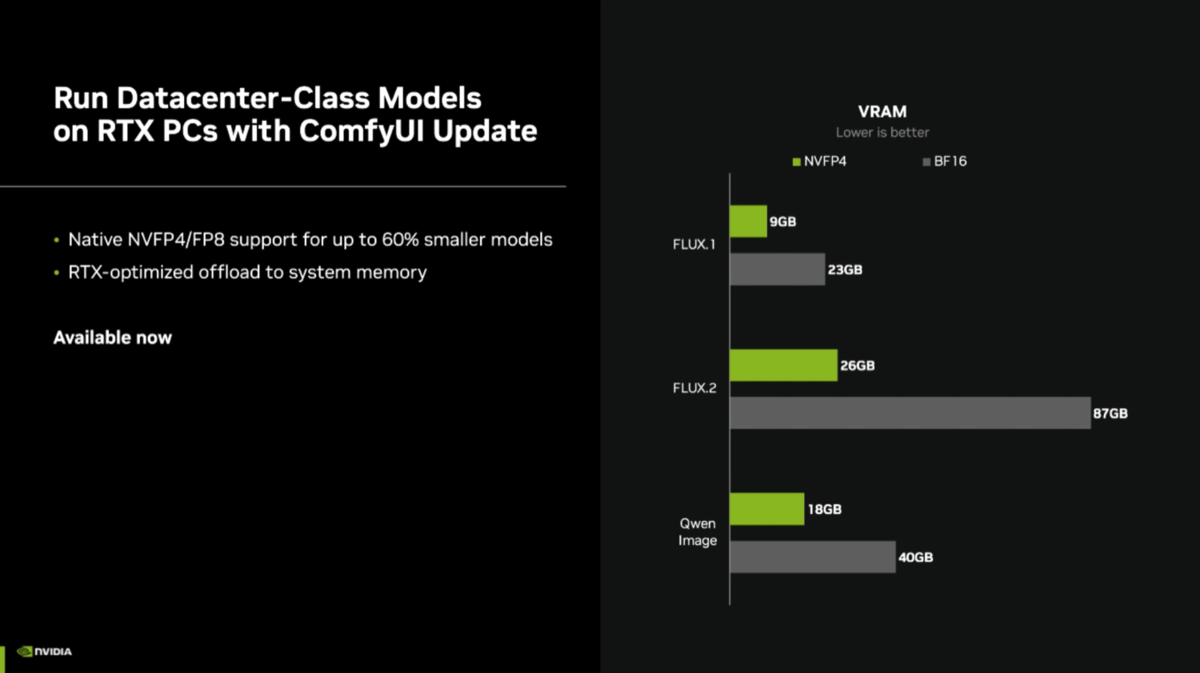

VRAM16GBでも26GB相当の学習モデルが利用できる?

最後にAI PCに関しても軽くまとめておこう。現状さまざまなAIサービスが存在しているが、無料で利用するには限界がある上にプライバシーの問題もある。ローカル環境でAIを動かし、プライバシーを保護しつつ自分のファイルをAIに処理させたいというニーズが高まっている(もちろん「無料で」だ)。

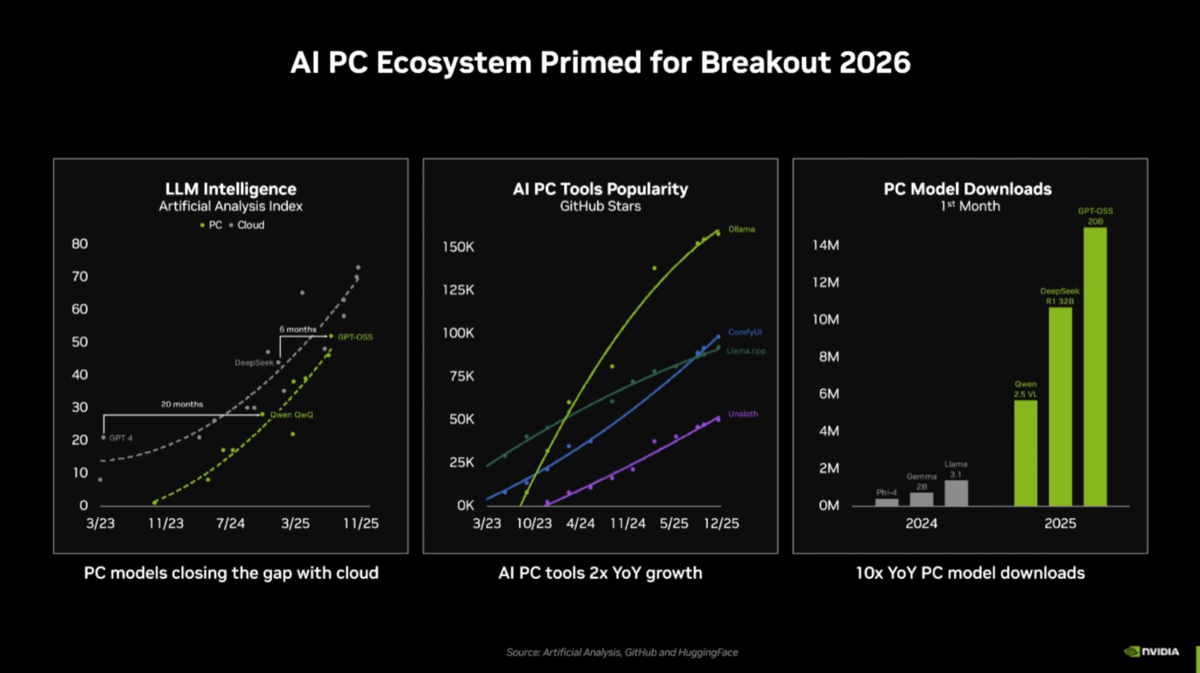

NVIDIAによれば小型LLMの性能がこの1年で急速に進化し、クラウドのサービスに対しローカルLLMは6ヵ月遅れ程度にまで差を縮めている。OllamaやComfyUIといったPC向けツールの進化、PC向け学習モデルのダウンロード数の急増を考えると、今年中に「AI PCエコシステムがブレイクする条件が整いつつある」という観測を強めている。

ローカルで動かすLLMの“知性”はオンラインのそれにどんどん接近している(左)ほか、PC向けAIツールの成長度合い(中央)も著しい。ローカルAIに欠かせないPC向け学習モデルのダウンロード数(右)も、2025年に爆発的な伸びをみせている。特に「gpt-oss-20B」のダウンロード数は1400万以上とすさまじい数字だ

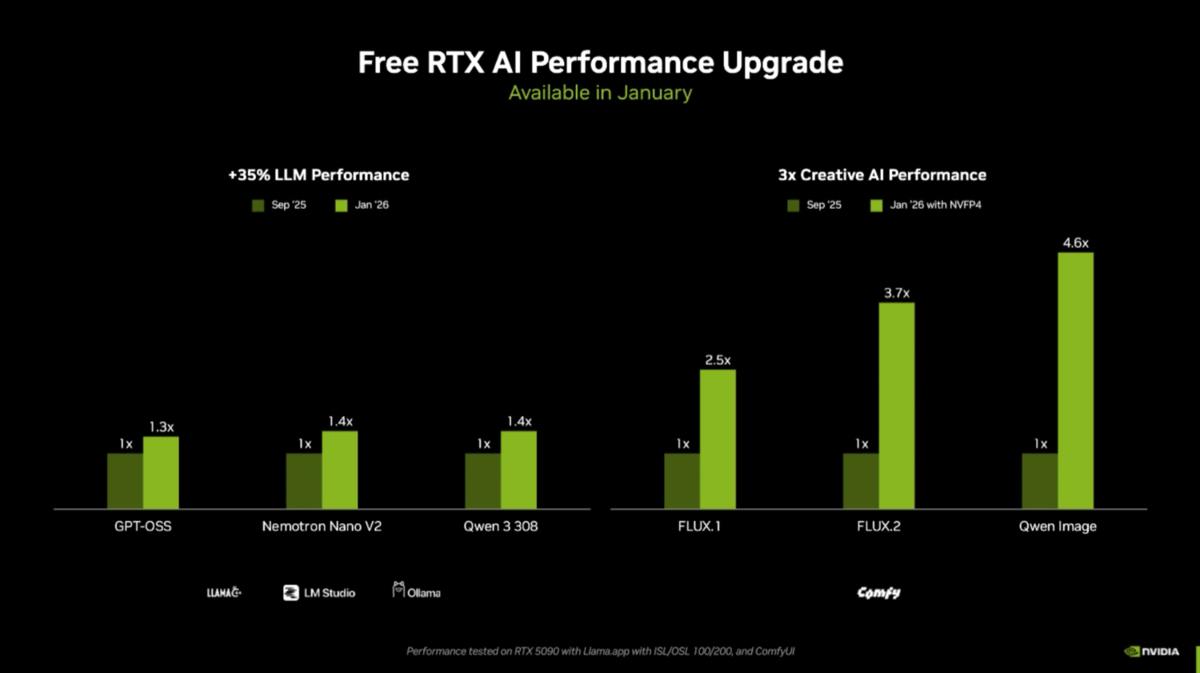

そこで、NVIDIAは主要なツールやアプリの開発者と組み、GPUを利用したAIパフォーマンス改善に力を入れている。LLMでは35%、画像生成では2.5~4.6倍と大幅なパフォーマンスアップが見込めるという。画像生成でここまで伸びる理由はPyTorch側の最適化に加え、ComfyUI側が「NVFP4」「NVFP8」といったデータ形式に対応するためである。

NVFP4とNVFP8は、VRAM使用量を削減して推論性能を向上させることを意図したGeForce(のTensorコア)向けフォーマットである(参考:NVIDIAのブログ)。BlackwellではFP4とFP8をネイティブサポートしているため、NVFP4とNVFP8もGeForce RTX 50シリーズで効率の良い処理が期待できる。BF16フォーマットを利用する巨大な学習モデルもNVFP4などで量子化することにより、VRAMの使用量を最大60%削減できるようになるのだ。

LLMや画像生成AIが2026年1月に予定されているアップデートで大幅にパフォーマンスアップする予定。LLMは35%、画像生成においては最大4.6倍になるという。これらのアップデートに関しては「LM Studio」や「ComfyUI」のリリースを待ちたい

さらに、ComfyUIにおいては、VRAMが不足した場合、一部の処理をメインメモリーに退避させる機能も実装。FLUX.2だとNVFP4で量子化してもVRAMを26GBも消費するが、メインメモリーへの退避を利用すれば普通のPCでも扱いやすくなるという。ただし、VRAM 8GBや16GBのGeForceではFLUX.2がどのような挙動をみせるのかは明言されていないため、これも今後の検証の課題になる。

BF16を利用した学習モデルをNVFP4で量子化したモデルに置換した場合、VRAM使用料はこのグラフのように激減する。FLUX.2だと87GBもVRAMを消費するモデルがNVFP4だと26GBに減る。さらに、メインメモリーへの退避を利用すれば、VRAM 16GBのGeForce RTX 5070 TiでもFLUX.2が動くかもしれない(未検証につき明言は避けたい)

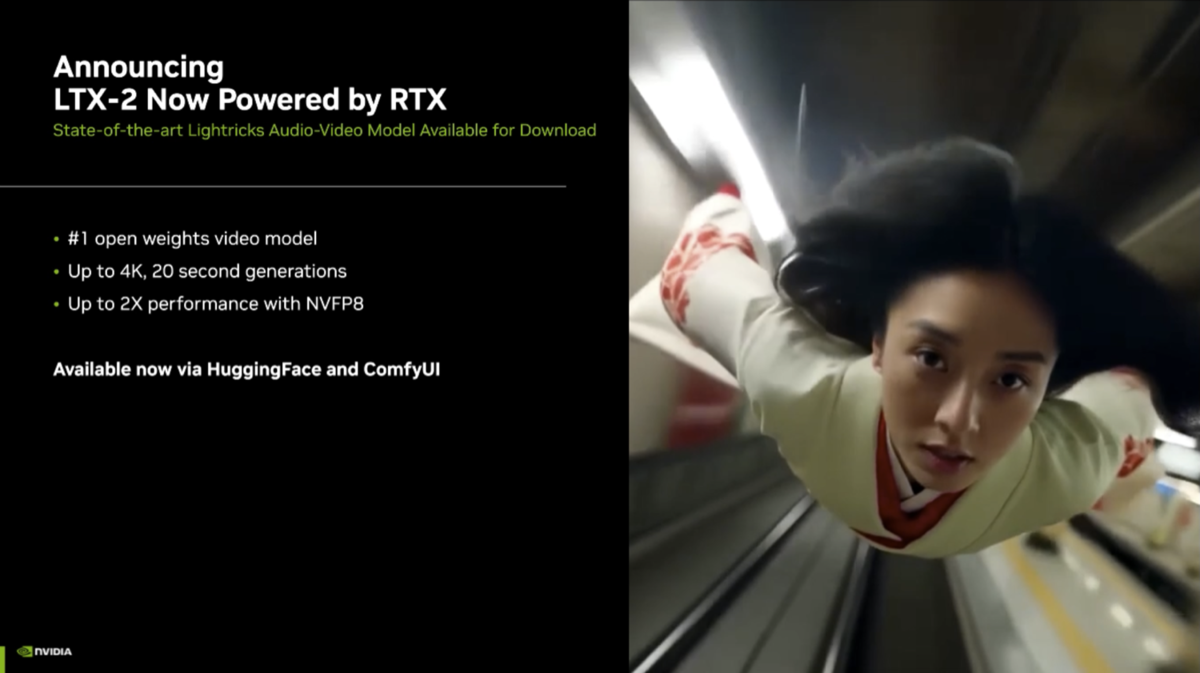

そして、最近ホットな動画生成AIに関しても動きがある。オープンソースの動画生成AIエンジン「LTX-2」のRTX最適化版がComfyUIやHugging Faceよりダウンロード可能になるという。LTX-2はすべてロードするとなるとVRAMが70GB(!)も必要な巨大なモデルだが、NVFP8で量子化すれば26GBまで削減でき、前述のメモリー退避を利用すればVRAM 16GB環境でも動作するという。

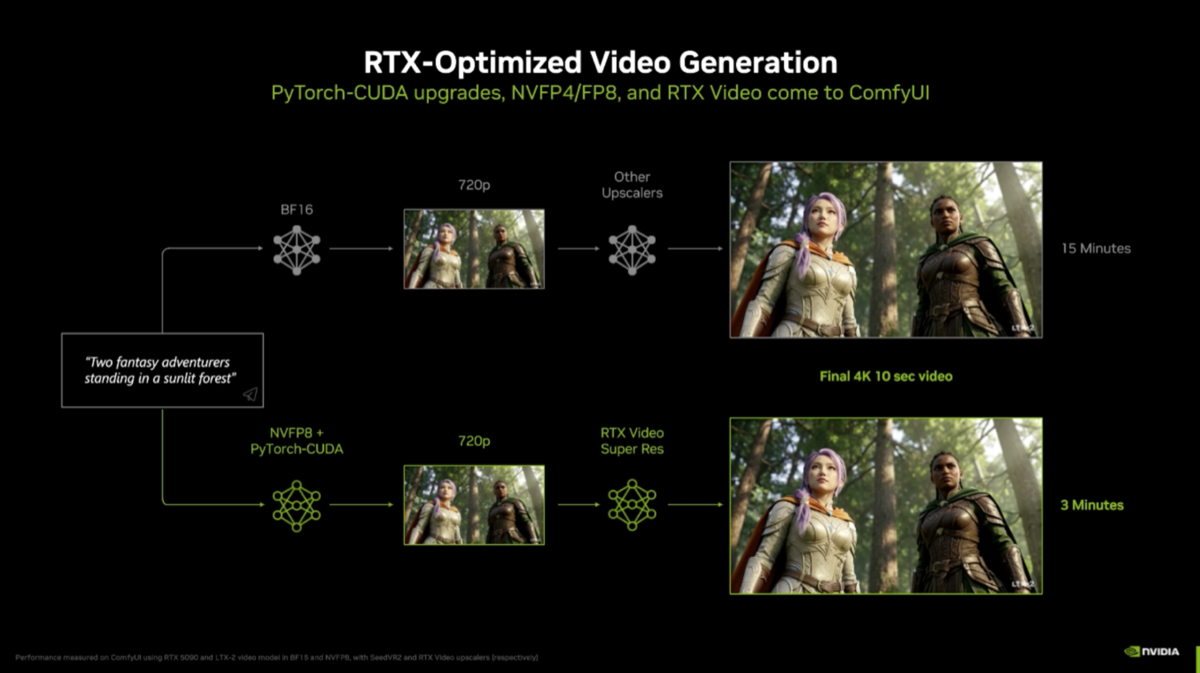

さらに、2026年2月にはComfyUIにリアルタイムのビデオアップスケーラーである「RTX Video」が統合される。低解像度で作成した動画のアップスケールはもとより、動画生成からアップスケールのフロー全体も高速化するという。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります