第856回

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析

2025年12月29日 12時00分更新

Kyber Rackにブレードが収まらない問題

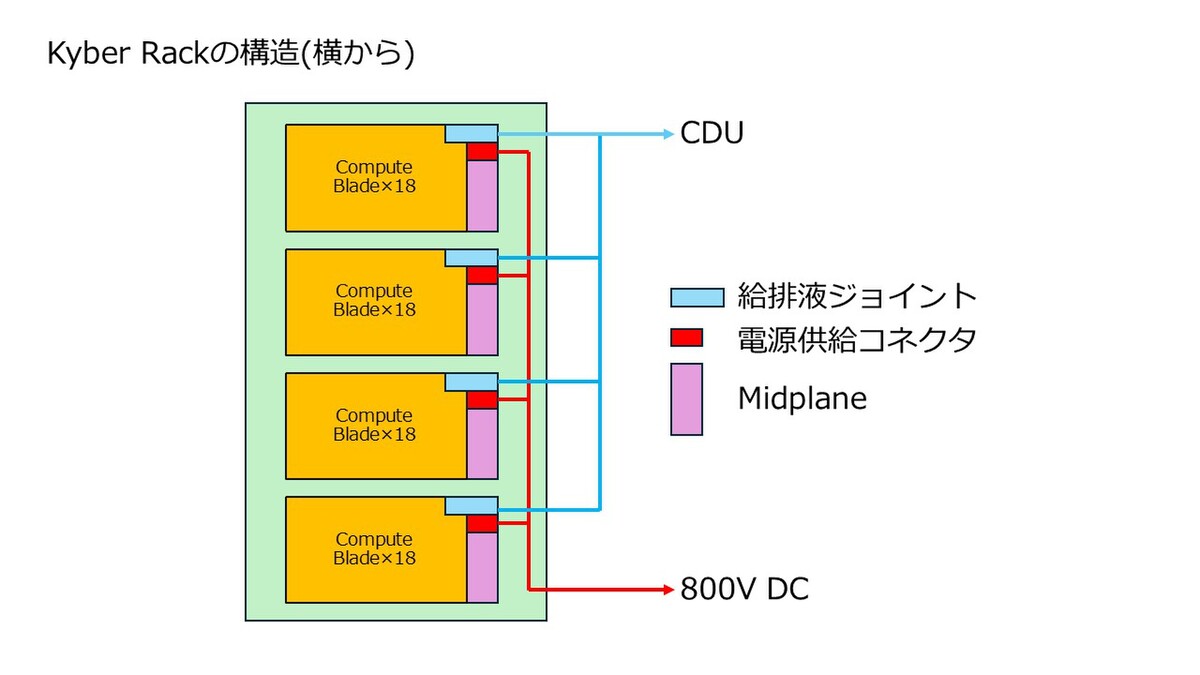

Kyber Rackに関してもう1つ。Kyber Rackを横から見た構造は下図のようになっているはずだ。

下の画像はNVIDIAがGTC DC 2025の様子としてFacebookに投稿したリールからのキャプチャーであるが、18枚のCompute Nodeが1つの塊になり、それが4段に渡って実装されているのがわかる。

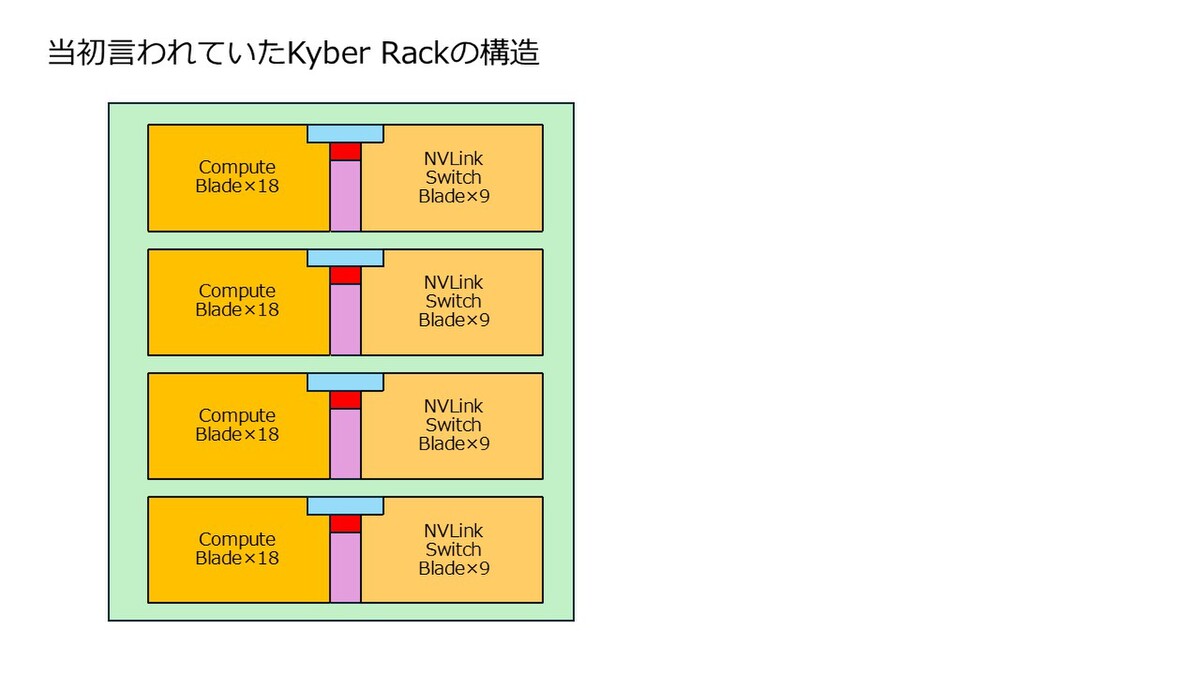

問題はこの奥行きが普通のラックに見えることである。当初Kyber Rackが展示された折、下図のような構造になっているのではないか、という話があった。Midplaneの反対側にNVLink Switch Bladeがそのまま刺さる構造である。

一見すると配線が大幅に削減できるように見えるのだが、子細に見てみるといくつかの大問題がある。まずMidplane同士をどうつなぐか? である。Midplaneを展示する様子はXのポストがわかりやすいのだが、72層の基板を使って構成されているものの、Midplane同士の配線をするためのコネクターが上下に見あたらない。

With the #Kyber rack NVIDIA changes a lot in the rack design for Rubin Ultra NVL576. There will be a copper midplane instead of the spine that is currently used.

— Andreas Schilling 🇺🇦 (@aschilling) May 22, 2025

- 72 connectors

- 152 pins each

- 10.944 pins per midplane

- 72 layer PCB to distribute all the pins pic.twitter.com/1fA9WYU1dI

給排液の配管や電源供給ラインもあるため、これを避けて上下方向の配線をするのは大変に困難である。Midplaneの横も、先のポストの写真で見るようにフラットになっており、ここに配線するような余地はない。

それと、上図の構造ではラックの奥行きが極端に長くなることは避けられない。中山智氏撮影の写真を見直していただくと、どちらのブレードも相応に長く、ラックに1枚収めるのは不可能ではないが、2枚を並べると明らかにはみ出す。

したがって筆者の見解としては、Kyber Rackの隣りにSidecarがあり、ここにNVLink Switch Bladeが収まるものと考えている。FacebookのリールでもCompute Bladeの左に、まだなにも入っていないSidecarが並んでいるのが確認できるからだ。

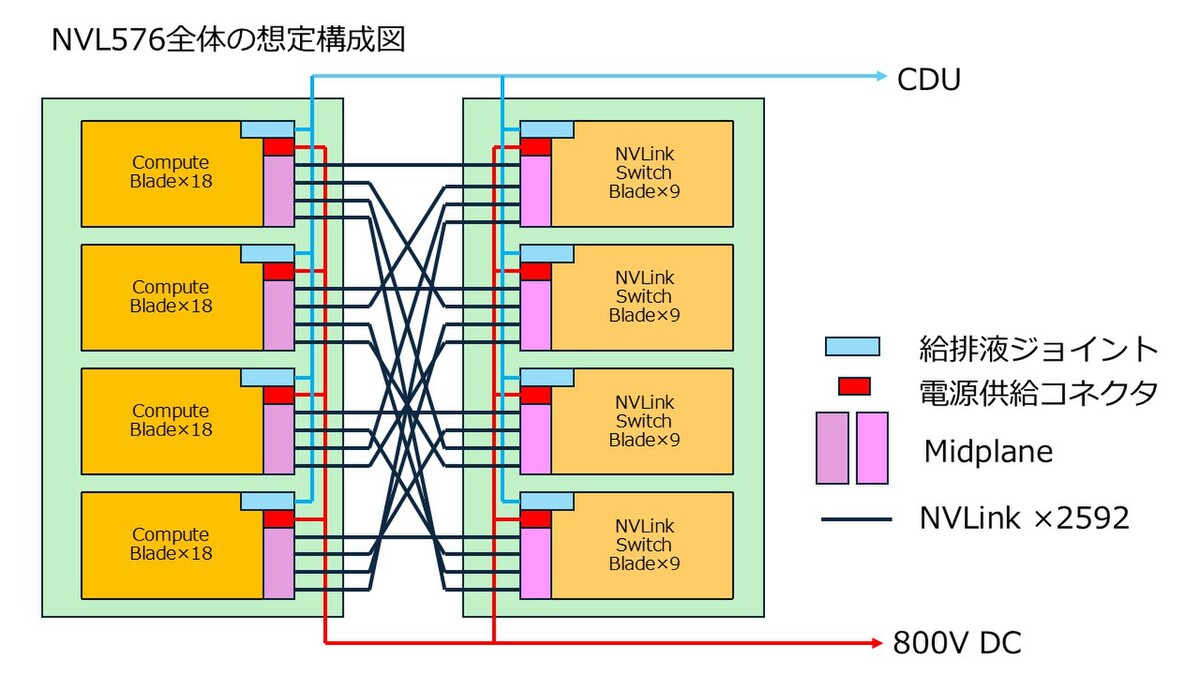

要するに下図のように、MidplaneもCompute BladeとNVLink Switch Blade用が別に設けられ、間が2592 レーン(288レーン×9)の巨大なNVLinkケーブルで相互接続される構図である。

ちなみに図ではCDU(Coolant Distribution Unit:前回の記事を参照)を記載していないが、ひょっとするとNVLink Switchが収まるSidecarの中にCDUも含まれるのかもしれない。

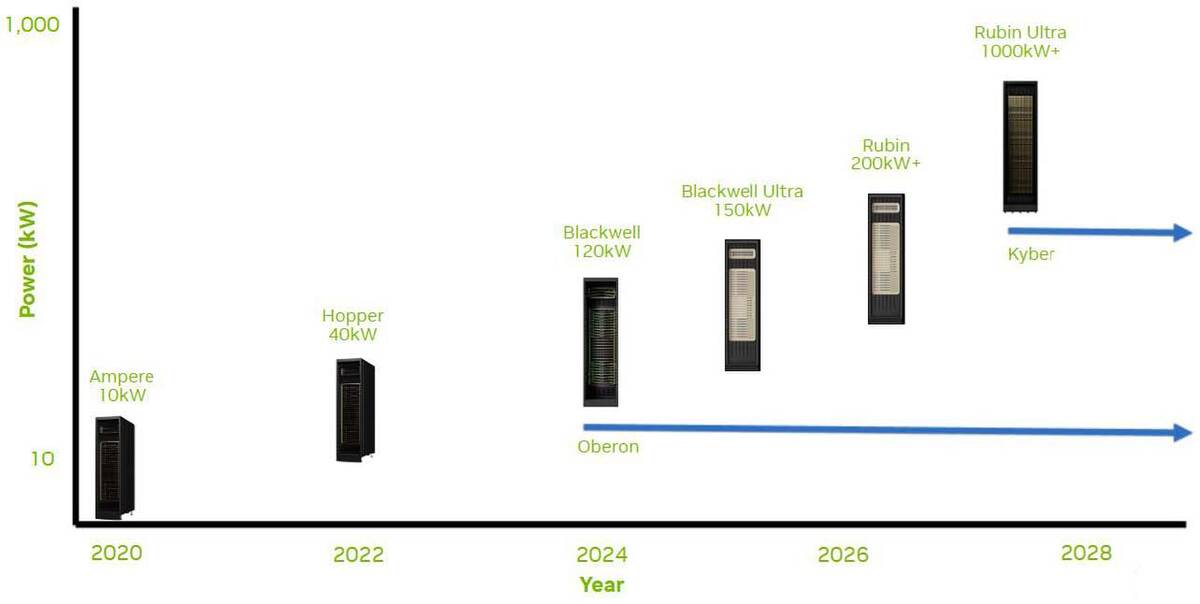

ここまで書いてきて気が付いたのだが、Rubin Ultraの消費電力に600kWと1MWの2つの数字があるのは、Compute Bladeが収まるラック単体が600kW、NVLink Switch Bladeが収まるSidecarまで含めた全体の消費電力が1MWということかもしれない。だとすれば連載854回でRubin Ultraが1000kW+と記載されるのも納得である。

いろいろと並外れた構成をがんばって既存のインフラに収めようとした結果がこのKyberソリューション、という気がする。Scale-upのネットワークをいかに現実的に収めようとして、収まらなくなった結果がこの構成である。なんというか、すさまじさを感じる。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります