第854回

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌

2025年12月15日 12時00分更新

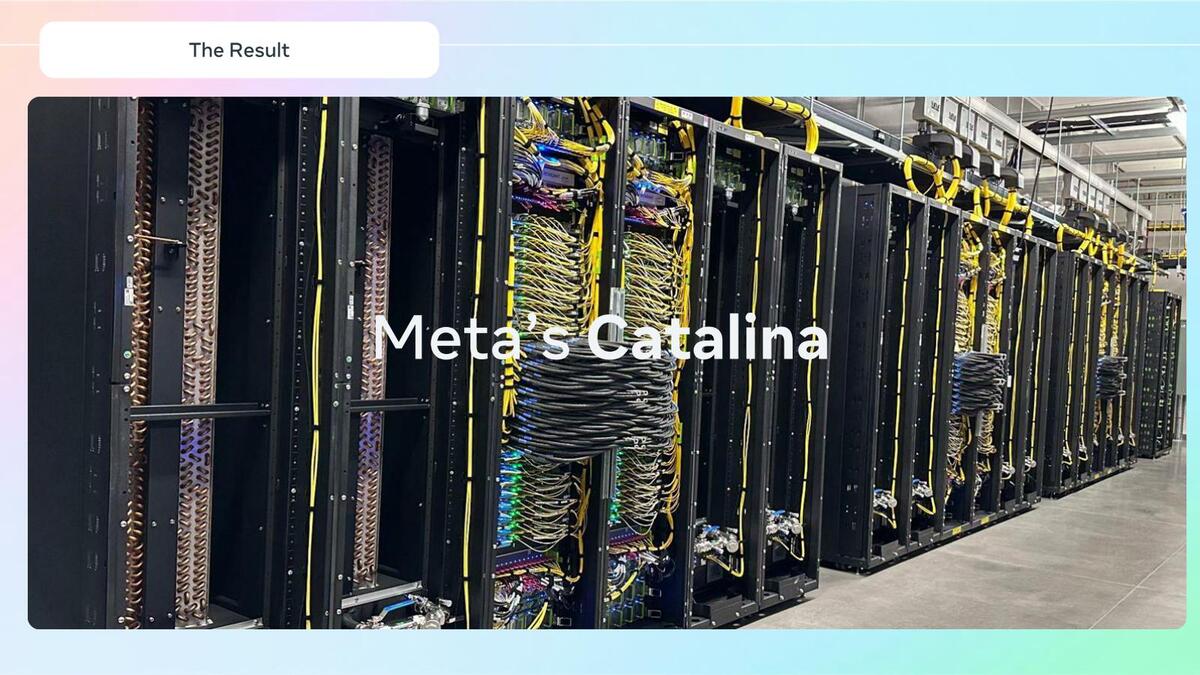

GB200 NVL72をベースにしたシステムCatalinaは

巨大なラジエーターラックで冷却と設置問題を解決

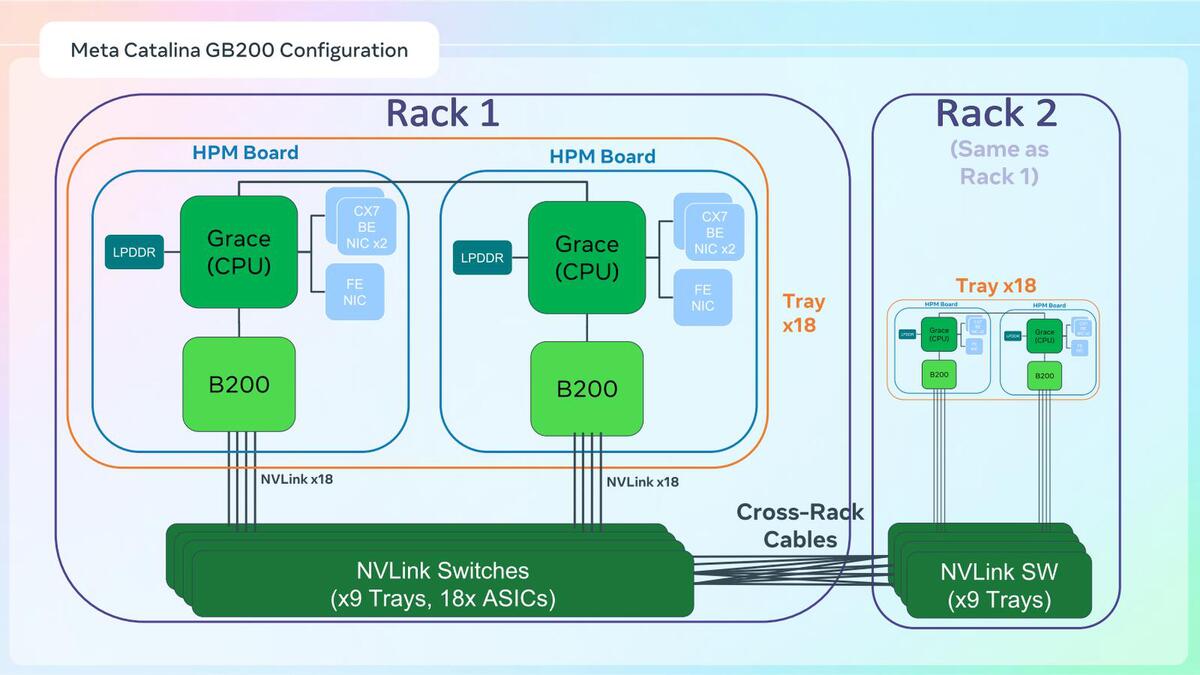

MetaはGB200 NVL72をベースにしたCatalinaと呼ばれるシステムを導入している。

2024年10月にCatalinaが発表された時と明らかに構成が異なる。おそらく最初はNVL72をそのまま導入したものの、後で変更したのだろう

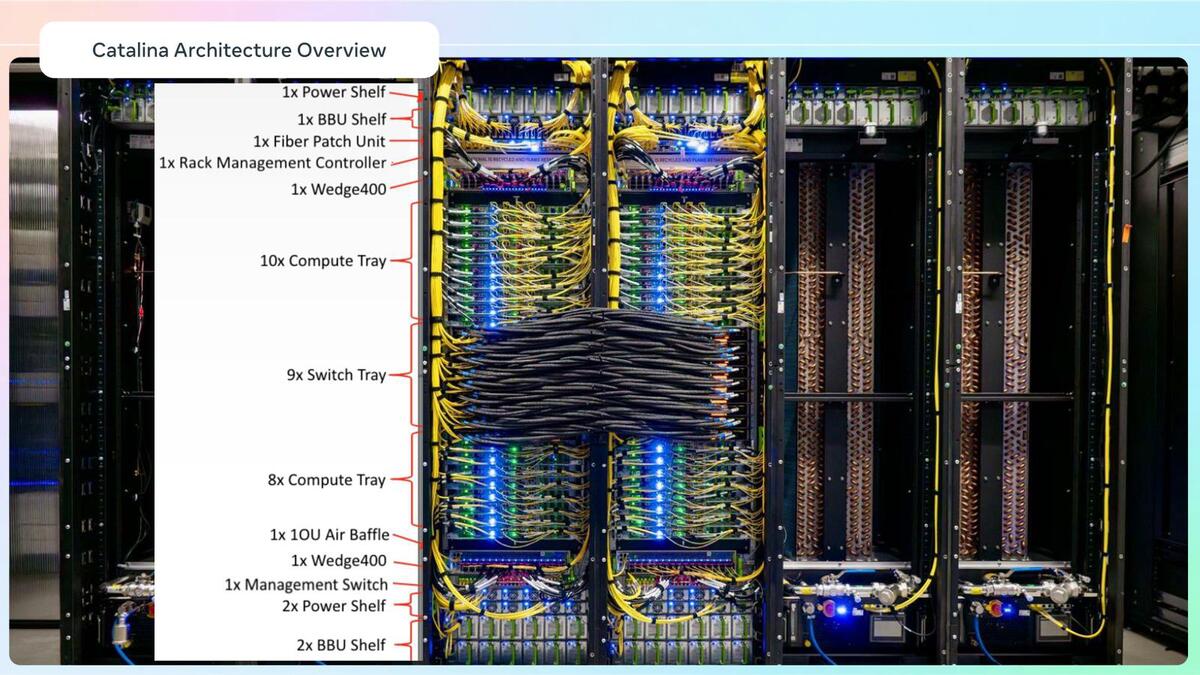

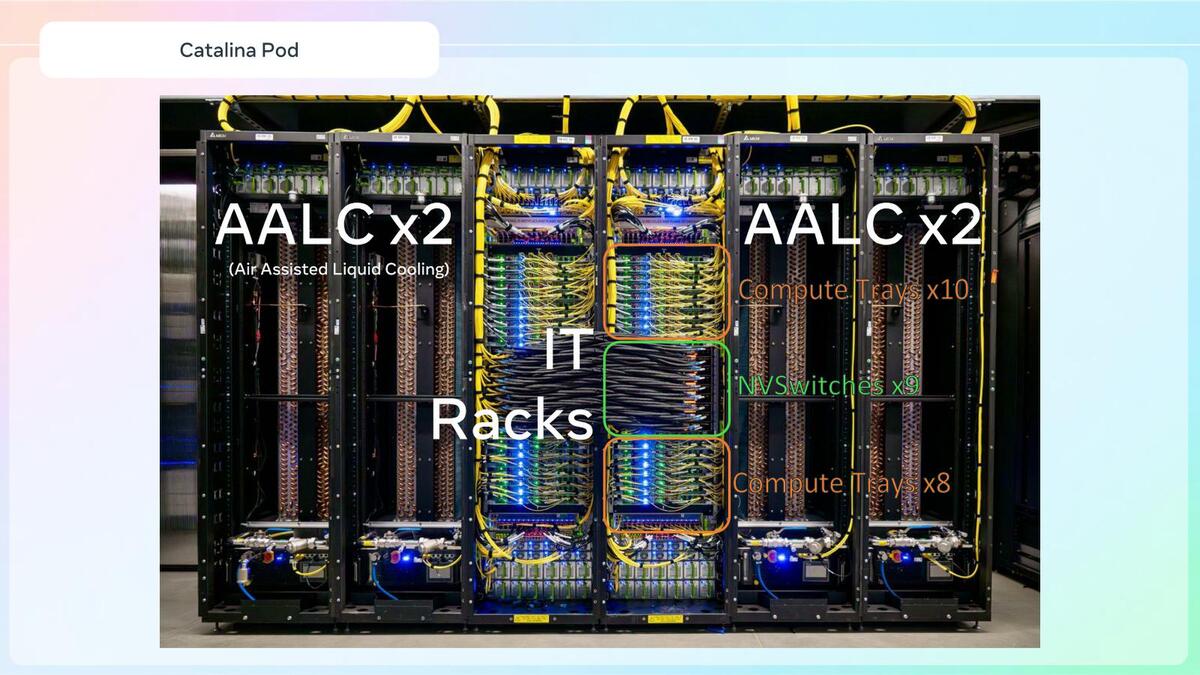

ただしその構成はNVIDIAのNVL72とやや異なり、ラックが2本になったうえ、両側にAALC(Air Assisted Liquid Cooling)×2が並ぶ、6ラックで1つのユニットという巨大な構成になっている。

AALCは要するにラジエーターである。ITラックで熱せられた冷却液を、AALCに配された巨大なラジエーターで冷やすわけだ。これだと既存のデータセンター内の空調でそのまま稼働させられるので、外部にクーリングタワーを設ける必要はない

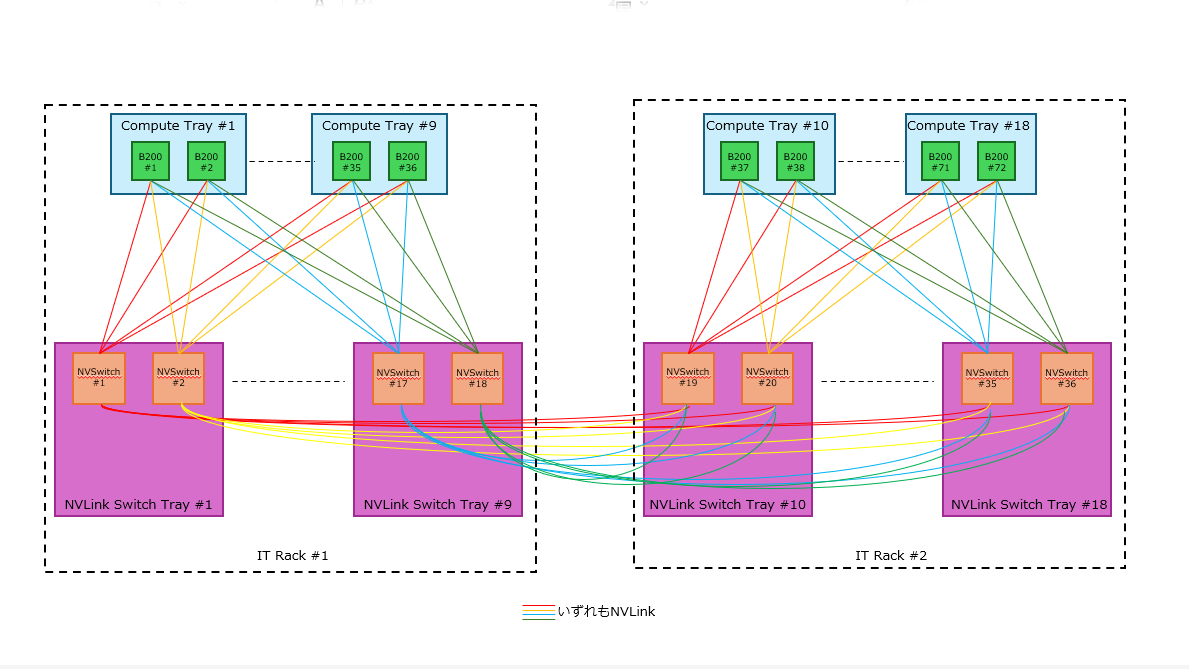

1本のNVL72に巨大なラジエーターラック×4が必要、というあたりに発熱の大きさがわかる。なお、上の画像でNVSwitches×9と書かれている部分で横方向の配線が走っているのは、NVLink Switch同士の相互接続の部分である。

そもそもITラックがなぜ2本か? であるが、下の画像が従来のNVL72の構成なのに対し、Metaはさらにその下の画像にある構成になっている。

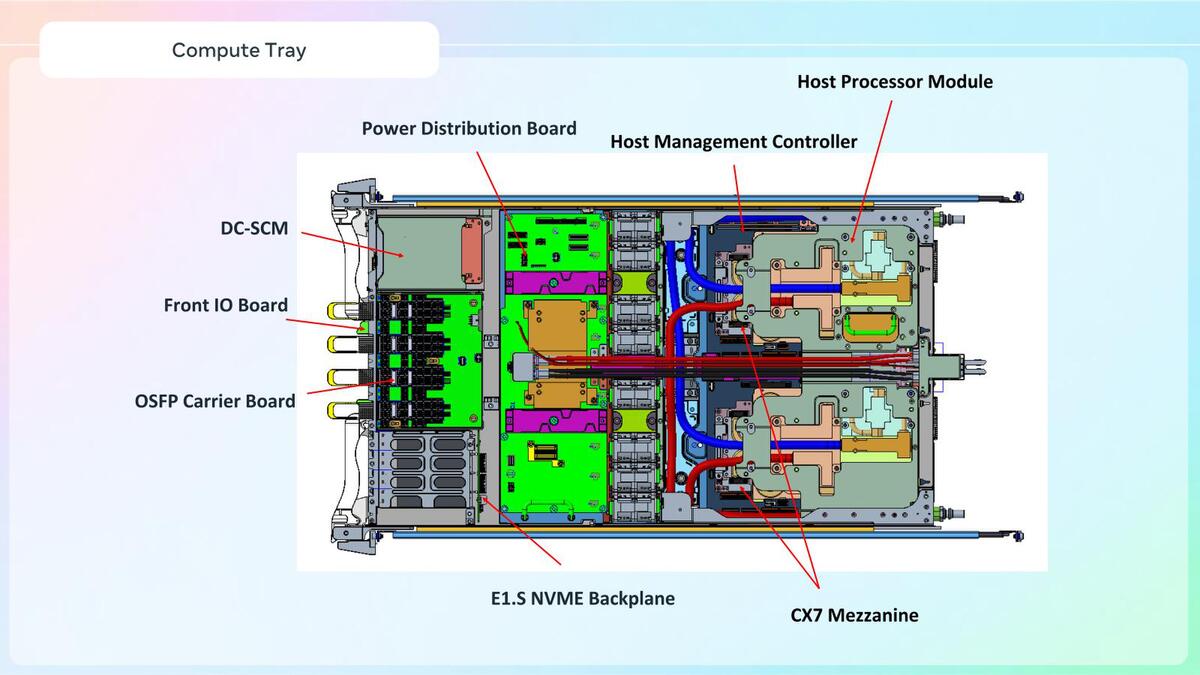

NVIDIAが提供するBlackwell Superchipをそのまま使うのではなく、独自の(それがMeta謹製なのか、NVIDIAにカスタムで製造を依頼したのか、それともサードパーティ製造のものなのかは不明)B200とGraceが1つずつ搭載されたボード(HPMボード)を使い、これを2枚で1つのCompute Trayに収めている。

ラックあたりのCompute Tray数は18と変わらないので、1ラックあたり36個のGB200とGraceが実装されているわけだ。そのラックを2本並べ、NVLink Switchそのものを相互接続する形で構成している。これをもう少し細かく書いたのが下図である。

NVIDIAのNVL72の標準品とMetaのCatalinaの特徴の違いをまとめたのがこちら。

Graceの数が倍増している関係でLPDDRメモリーの容量は倍増しているし、結果としてシステム全体のメモリー量も増えている一方、NVLink Switchの数は全体では倍増しており、これはシステム性能の向上につながる。

一方、NVL72の標準品では72個のB200同士が必ず1Hopで接続できていたのが、Catalinaでは1Hopの場合と2Hopの場合の両方が混在し、平均1.5Hopになるあたりはむしろ性能低下の要因になりうる。

性能面だけを考えると微妙なバーターとなる気もするのだが、これを選んだのはおそらく性能ではなく実装の問題だろう。つまり既存のデータセンターに入れようとするとNVIDIAのNVL72のままでは問題が多いので、もう少し入れやすくした結果として2ラックにならざるを得なかった、というあたりだろう。

だったら1本のCompute TrayにBlackwell Superchipを1つだけ実装、という案もあった気がするのだが、それを選ばなかった理由は説明されなかった。

内部の詳細が下の画像だ。Compute Trayの中身はこんな感じになっており、MGX Accelerated Computing Tray(前ページ最初の画像)に比べてもあまり差は感じない。こうした工夫をすることで、従来のデータセンターにそのまま設置可能、という説明であった。

逆に言えば、もうNVIDIAの標準的なNVL72は、専用のデータセンター設計が必要であり、この先登場するKyberやAMDのHeliosなどは、AIデータセンター向けの専用設計なしには設置・稼働ができないわけだ。

MetaのCatalinaは、本来なら専用データセンター設計が必要なところを、普通のデータセンターで使えるように工夫した成果と見ることもできよう。ではこの先ラックはどうなって行くのか? という話を次回説明したい。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります