第854回

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌

2025年12月15日 12時00分更新

Hot Chipsで目立った製品の紹介は前回までで終わったのだが、最後に初日のチュートリアル・セッションでおもしろい話がいろいろ出てきていたので、これをいくつか紹介したい。

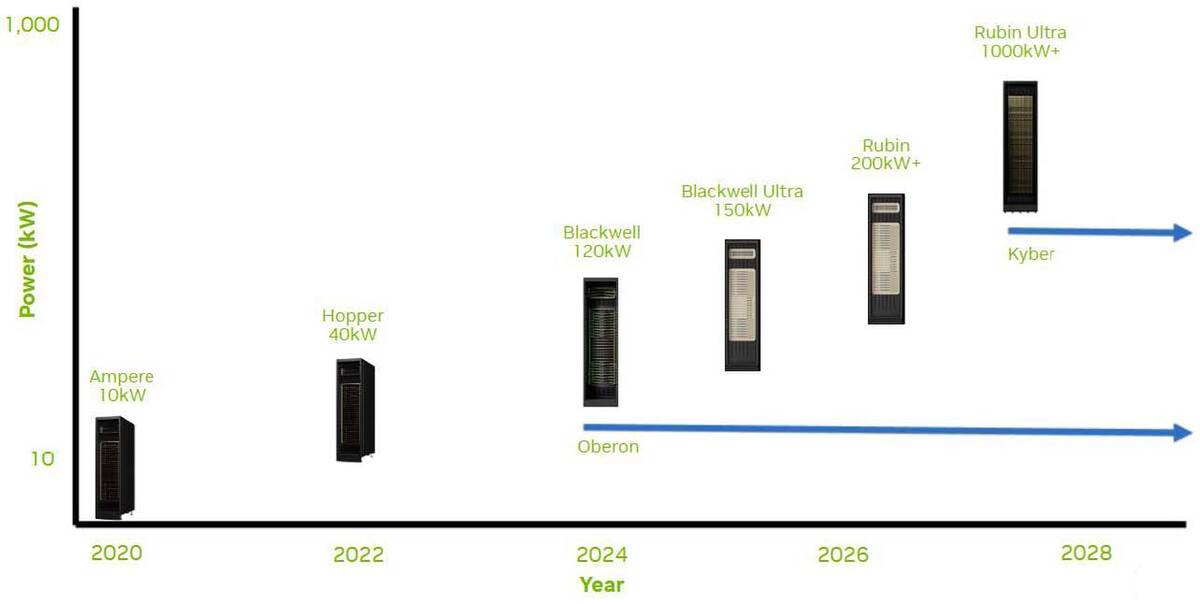

今回はNVIDIAのGB200/GB300を使ったNVL72ラックソリューションである。今年後半に入って、データセンターのラックに熱い注目が集まっている。直接的なきっかけは今年3月に開催されたGTCにおいて、2027年後半に投入されるKyberラックを利用したRubin UltraベースのNVL576というラックソリューションの消費電力が、ラックあたり600kWに達することが明らかにされたためだ。

GTC 2025のJen Seng Huan氏の基調講演の1時間29分35秒付近。口頭での説明のみでスライドには数字がないので、英語字幕の自動生成を利用した

600kWというのは、例えば200Vで供給しても3000Aもの電力が流れる(3相200Vでも、力率を1.0としても1732Aほど、実際は2000A近いだろう)計算になる。そこでNVIDIAは5月頃からデータセンターのラックに800V DCによる供給をするというアイディアを発表し、10月にはこれに基づく800V DC Ecosystemがすでにそろいつつあることをアナウンスしている。このあたりの話は次回説明するとして、まずはその手前の話である。

サーバーの設置問題を解決する

NVL72のラックソリューション「Oberon」

NVL72のラックソリューションはOberonというコード名が充てられており、これをベースに2027年のKyberまでは基本同じラックを使い続ける形でBlackwell Ultra(GB300)やRubin(RB400相当)に対応するとしている。

A100世代で10kW、H100世代で40kWなのがGB200世代で120kW、GB300世代では150kWに達するとされる。Rubinは250kWクラスだろうか?

画像の出典は、NVIDIAの"800 VDC Architecture for Next-Generation AI Infrastructure"というホワイトペーパー。

ちなみに当初GB200のラックは120kWと言われていたのが、実際はGB200 NVL72は140kWに達しており、これもあって一度ラックの作り直しが発生、納入が遅延したという話があった。おそらくGB300 NVL72は150kWでは収まらないだろう。

これが問題になるのは、1つは従来のデータセンターは通常ラックあたり50kW前後、GPUを搭載する高消費電力サーバー向けのラックであっても120kWくらいを前提に設計されており、GB200やGB300のラックはこの枠で収まりきらないということ。

しかもこの先どんどん消費電力が増えてゆき、1MWまで視野に入っているとなるとデータセンターの作り方(+稼働させるためのインフラ)そのものを見直す必要があるからで、この結果として7月くらいからこの新時代(?)データセンターに向けての各社の取り組みが急に活発になってきたという事情がある。

そのあたりの話は全部次回送りにするとして、こうした議論の叩き台となる、NVIDIAのOberonラックの構造を解説しよう。

実はこうした状況をかんがみてか、Hot Chipsのチュートリアル・セッションの午前中には全部で7本のセッションがあったのだが、これが全部ラック関連の話である。紹介するのはNVIDIAの"Case Study: NVIDIA GB200/300"というものである。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります