「コードレッド」が示す競争環境とChatGPTの次の段階

GPT-5.2の発表直前、OpenAI内部で異例の事態が起きていた。12月上旬にサム・アルトマンCEOが社員向けに「コードレッド」(非常事態宣言)を発令したのだ。

Google Gemini 3という「衝撃」

きっかけは、11月に発表されたGoogle Gemini 3の好調ぶりだった。複数のベンチマークでChatGPTを上回るスコアを記録し、特に推論能力や効率性、エージェント型ワークフロー(AIが複数のツールを使って作業を遂行する仕組み)で高い評価を受けた。グーグルのユーザー数も、7月の4億5000万人から10月には6億5000万人へと、わずか3ヵ月で44%増という急成長を見せていた。

さらに、Salesforce CEOのマーク・ベニオフが「ChatGPTからGemini 3に乗り換えた。推論、速度、画像、動画……すべてがシャープで速い。もう戻らない」とXで公言するなど、企業ユーザーの乗り換えまで起き始めていた。OpenAIにとっては看過できない状況だった。

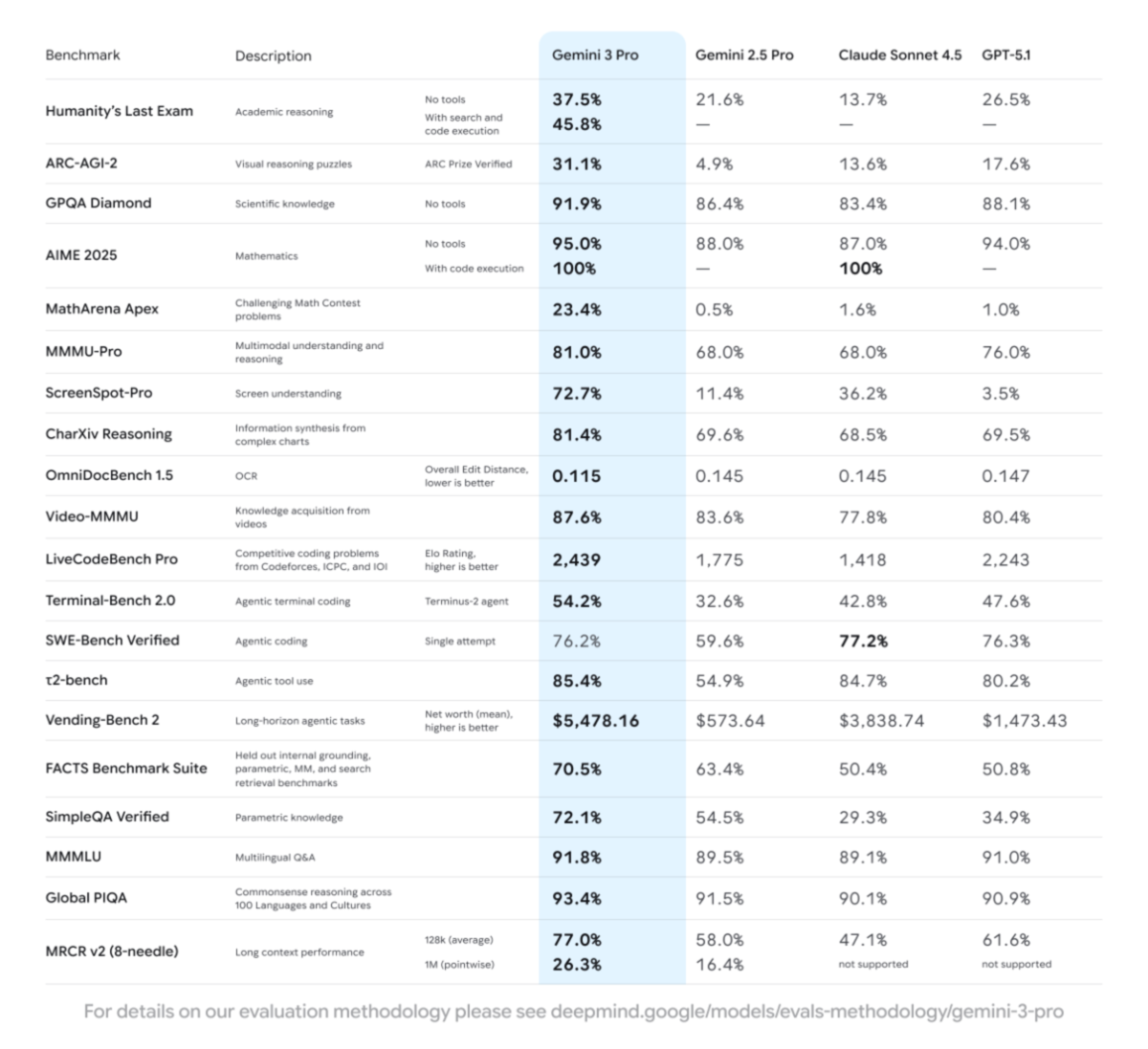

Gemini 3 Proは20項目のベンチマークのうち18項目でトップスコアを記録。特にMathArena Apex(23.4%)、ScreenSpot-Pro(72.7%)、ARC-AGI-2(31.1%)などで他モデルを大きく引き離した

内部での方針転換──「ChatGPT最優先」へ

アルトマンの社内メモは、OpenAIがこれまで進めてきた複数のプロジェクトを棚上げし、リソースをChatGPTの改善に集中させる内容だった。具体的には、広告機能の統合、ヘルスケアやショッピング向けAIエージェント、そして「Pulse」という先回り型アシスタント機能が延期された。

改善の重点は5つ。パーソナライゼーション(個別最適化)、応答速度、信頼性、幅広い質問への対応、そして「過度な拒否」の削減だ。「過度な拒否」とは、AIが安全性を重視するあまり、本来答えられる質問まで拒否してしまう問題を指す。実際、GPT-5(8月リリース)は「臨床的すぎる」「地理や数学が弱い」との不満が出ており、11月のGPT-5.1でようやく修正された経緯がある。

アルトマンは「次の推論モデルは、内部評価ではGemini 3を上回っている」とも述べており、その成果の一つが今回のGPT-5.2だ。OpenAI幹部は記者向けブリーフィングで「GPT-5.2はGemini 3への対抗ではなく、数ヵ月前から開発していた」と説明しているが、「コードレッド」がリリースタイミングやリソース配分に影響を与えた可能性は高い。

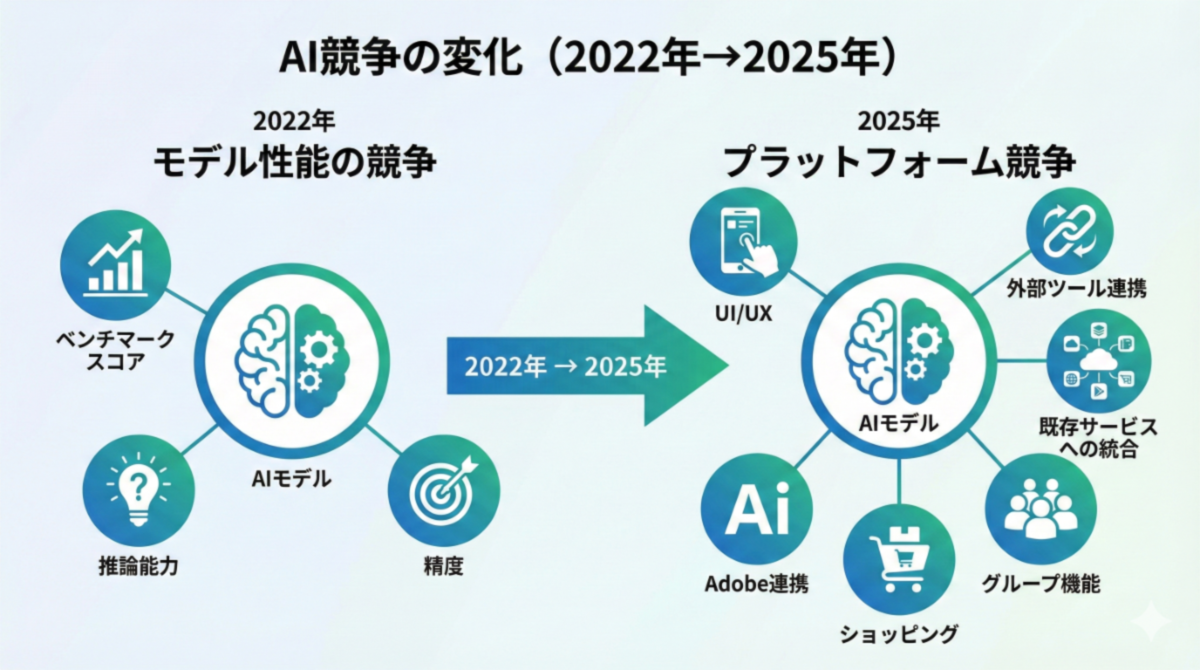

競争軸の変化──モデル性能だけでは勝てない

この「コードレッド」が示しているのは、AI競争の軸が変わりつつあることだ。

これまでの競争は、主にモデル性能(ベンチマークスコア、推論能力、精度)で勝負が決まっていた。しかし現在は、グーグルの巨大なユーザーベース(検索、Gmail、YouTube、Androidなど)への組み込み、Anthropicの企業向け安全性重視戦略、そしてOpenAIの機能拡張(グループチャット、ショッピング、Adobe連携など)といった「プラットフォーム競争」に移行している。

モデル性能が拮抗してきた今、ユーザーが「どこで、どう使うか」が勝敗を分ける。グーグルは既存サービスへの統合で、OpenAIは機能拡張で、Anthropicは安全性重視で差別化を図る──それぞれが違う土俵で戦い始めている。

興味深いのは、12月9日に発表された「Agentic AI Foundation(AAIF)」という業界横断組織だ。Linux Foundation(Linuxなど多数のオープンソースプロジェクトを中立的に管理する非営利団体)傘下に設立されたこの組織には、Anthropic、OpenAI、Block(Square、Cash Appなどを展開するフィンテック企業)が創設メンバーとして参加し、AWS、Bloomberg、Cloudflare、グーグル、Microsoftなどがプラチナメンバーとして名を連ねる。激しく競争している企業が同じテーブルに着いた形だ。

AAIFでは3つのプロジェクトが共通基盤として扱われる。Anthropicの「MCP(Model Context Protocol、AIとデータソースを接続する規格)」、Blockの「Goose(オープンソースのAIエージェントフレームワーク)」、そしてOpenAIの「AGENTS.md(AIコーディングツールにプロジェクトの構造や規約を伝えるマークダウン形式の仕様書)」だ。いずれも特定企業の管理下ではなく、Linux Foundationという中立組織の運営に移行する。AGENTS.mdはすでに6万以上のオープンソースプロジェクトで採用されているという。

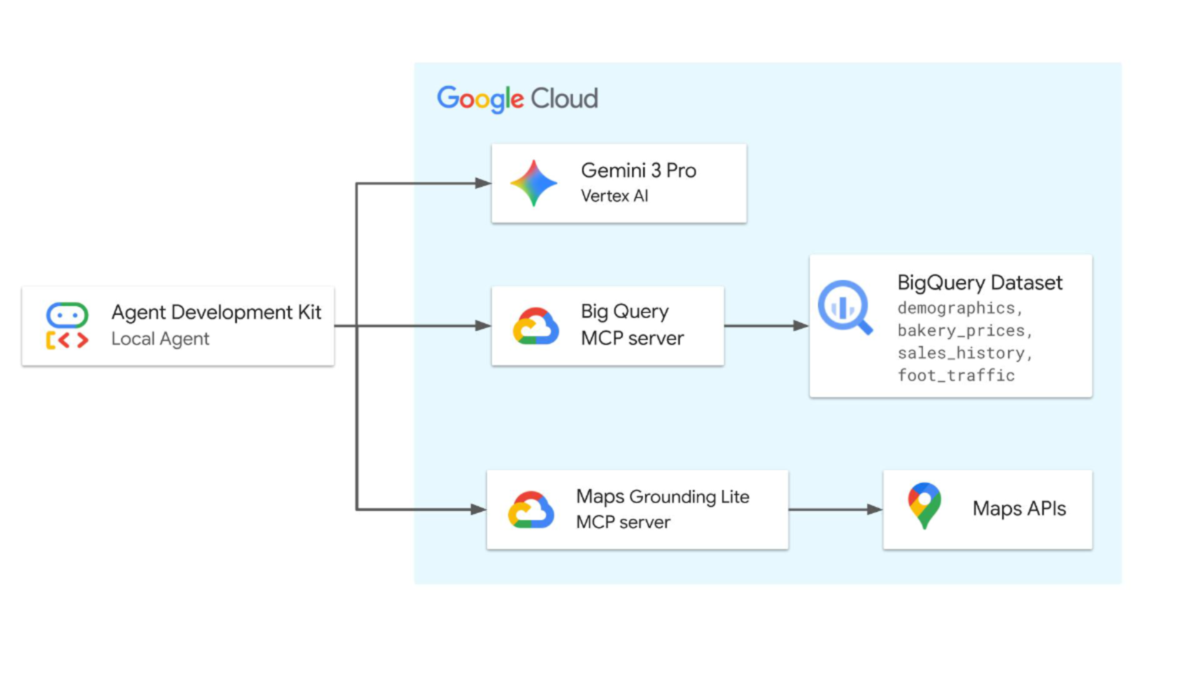

さらに注目すべきは、グーグルがその翌日(12月10日)、MCPに対する公式サポートを発表したことだ。Google Maps、BigQuery、Compute Engine、Kubernetes Engineなど、グーグルのクラウドサービス向けにフルマネージドのMCPサーバーを提供開始した。競合のAnthropicが開発したプロトコルを、グーグルがわずか1日後に採用したわけだ。

このスピード感のある動きは他社にも広がっている。Ciscoも同日、ゴールドメンバーとして参加を表明し、「エージェント同士が協力するインターネットの構築には業界横断の協力が不可欠」と述べた。競争と協調の線引きが、急速に明確になりつつある。

GoogleはBigQueryやGoogle Mapsなど、自社サービス向けのフルマネージドMCPサーバーを提供開始。AIエージェントがMCPという標準プロトコルを介して、Googleのサービスに接続できる

MCPの共同開発者であるAnthropicのDavid Soria Parra氏は「主要プラットフォーム間での採用が進むことで、AIエージェントがユーザーが既に使っているツールやサービスとシームレスに連携できる世界に近づく」とコメントしている。

つまり、インフラ部分は協調し、アプリケーション層で競争するという線引きが明確になりつつある。Linux FoundationのJim Zemlin事務局長は「プロプライエタリな閉鎖的スタックの未来を避ける」ことが目標だと述べている。競争しつつも、業界全体の底上げには協力する──AI業界が「成熟期」に入りつつあることを示す動きだ。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります