【無料】動画生成AI「Wan2.2」の使い方 ComfyUI設定、簡単インストール方法まとめ

2025年09月08日 17時00分更新

I2Vはかなり厳しい

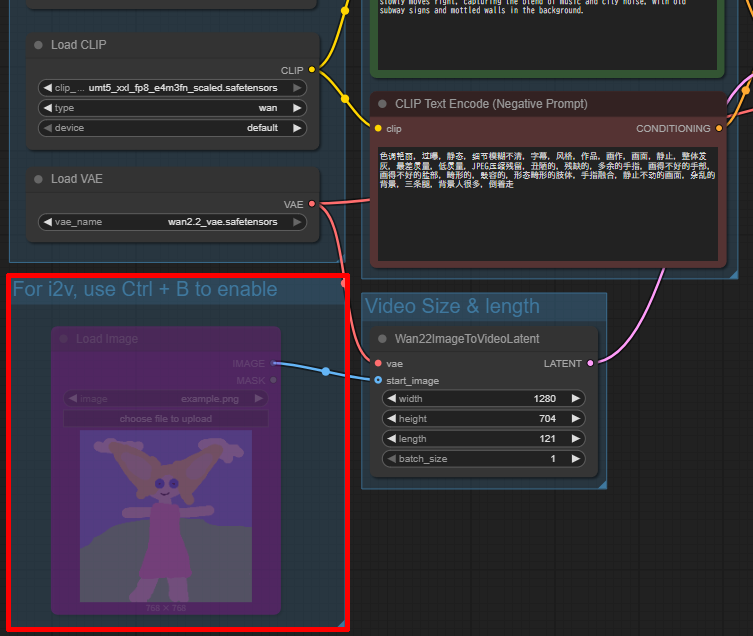

次にあらかじめ用意した画像を元に動きをつけるI2Vを試してみよう。I2Vを試すには先ほどのワークフロー内にある「For I2V, use Ctrl + B to enable」と書かれたノードを選択し、「Ctrl + B」でアクティベートしよう。

アクティベートされたノード。ここにI2Vで使う画像をドラッグ&ドロップ(または「choose file to upload」をクリック)すればよい。

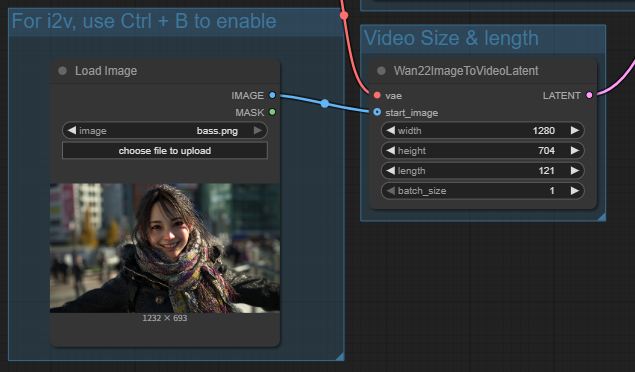

画像はMidjourneyで用意した。

生成する動画のサイズが1280×704なので、あらかじめ画像も16:9でトリミングしておいた。

トリミングが終わったらノードにドラッグ&ドロップ。

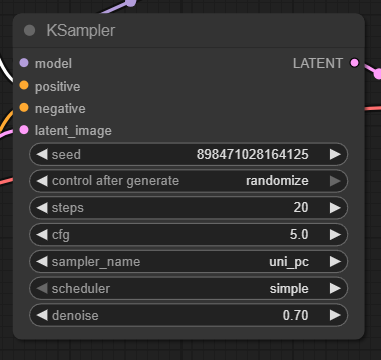

設定はT2Vの時とほぼ同じだが、「denoise」の値だけ1.0から0.7に変更した。denoiseは元画像をどの程度ノイズ化して再生成するかを決めるパラメーターで、値を下げるほど元画像を保ちやすくなる一方、動きは控えめになる。今回は元画像の雰囲気を残したかったため、やや低めの0.7に設定している。

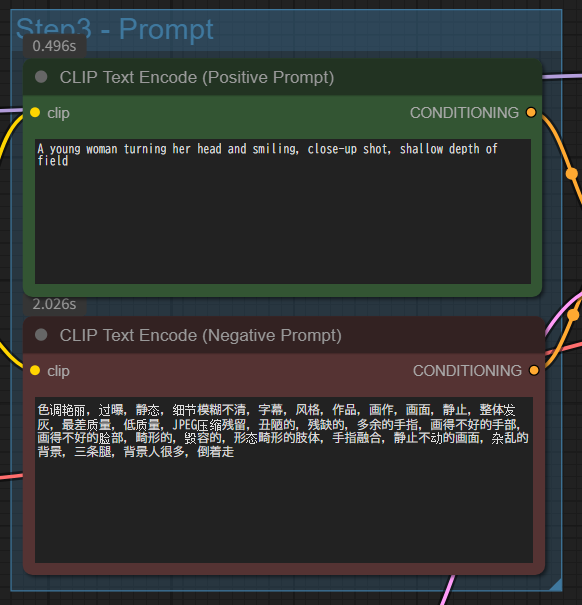

I2Vでは「元画像をどの程度動かすか」がポイントなので、プロンプトは「動き+雰囲気強化」の二軸で以下のように組んでみた。なお、ネガティブプロンプトはデフォルトのままにしておいた。

プロンプト:A young woman turning her head and smiling, close-up shot, shallow depth of field(頭を振り返って微笑む若い女性、クローズアップショット、浅い被写界深度)

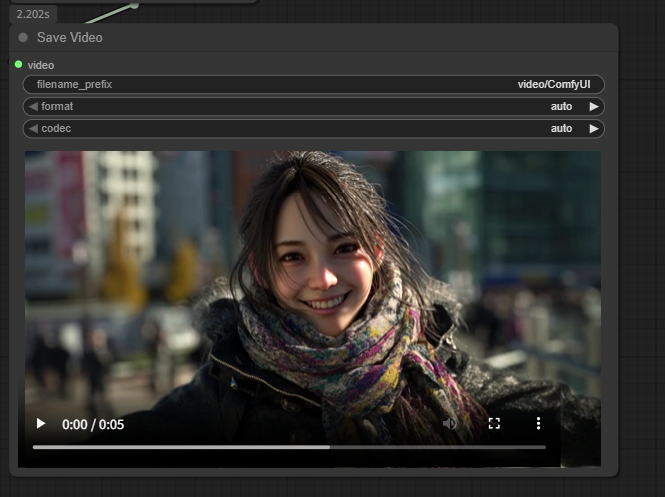

以上の設定で動画を生成。所要時間は27分とT2Vとほぼ同様の時間がかかった。

さっそく再生してみると……元画像とは似ても似つかぬ別人化した女性の映像が表示された。大失敗だ。

SNSなどの報告を見るとどうやら「静止画をそのまま動かす」というよりも「静止画を起点に別ショットを作る」という挙動になりやすいようでまさにその挙動である。

そこで今度はDenoiseの値を0.7から0.55にさらに下げることで元画像の輪郭・服・背景の保持率を上げ、CFGも5から4に下げることでテキストの支配力を落とし、画像の影響を強くしようと試みてみた。

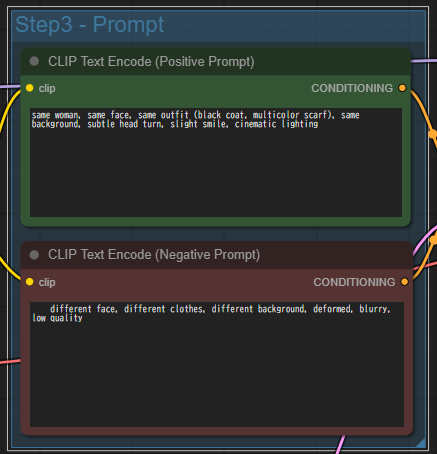

プロンプトも見直し、元画像と「同じ女性」「同じ顔」「同じ服装」「同じ背景」で描いてと強調、さらにネガティブプロンプトに「違う顔」「違う衣装」「違う背景」と思いつく限りの条件を入れてみた。

プロンプト:same woman, same face, same outfit (black coat, multicolor scarf), same background, subtle head turn, slight smile, cinematic lighting

ネガティブプロンプト:different face, different clothes, different background, deformed, blurry, low quality

結果は……。

結論としてI2Vで「写真の人物をそのまま動かす」のは、少なくともTI2V-5Bモデルではかなり難しいという印象だ。denoiseやCFGを調整しても別人っぽく生成されることが多く、「動かす」というより「元画像から新しいショットを作る」挙動になることが多い。コミュニティでも同様の報告があり、現状ではこれが通常の結果と思ってよいだろう。設定をさらに追い込めば多少改善する可能性はあるが、弊環境では生成に約30分かかるため現実的とは言いがたい。より高精度に再現したいなら、VRAMの多いクラウド環境で14Bモデルを使う、あるいは次章で紹介するEasyWan22といった別アプローチを試すのも一案だ。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります