【無料】動画生成AI「Wan2.2」の使い方 ComfyUI設定、簡単インストール方法まとめ

2025年09月08日 17時00分更新

公式ワークフローで試す

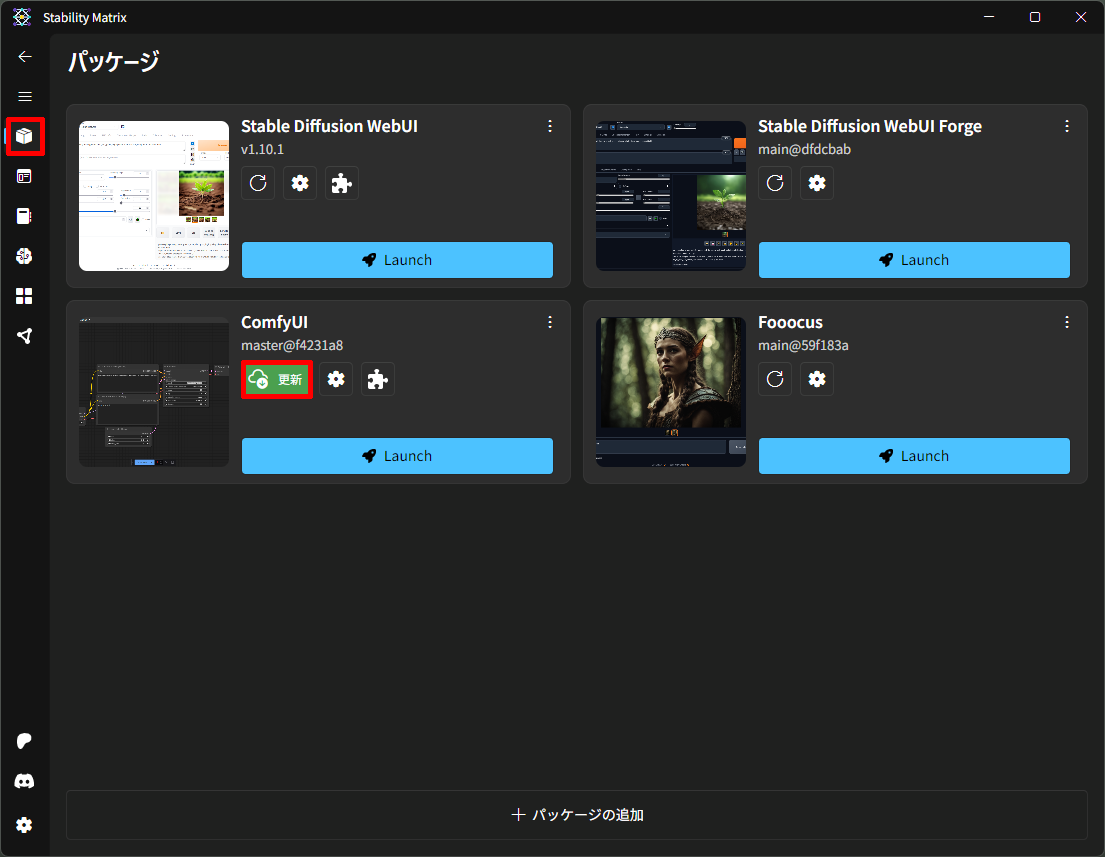

ComfyUIの「公式ワークフロー」を試すには、ComfyUIを最新のものにアップデートする必要がある。

Stability Matrixを使ってComfyUIをインストールしている場合は「更新」をクリックするだけでアップデートが完了する。Stability Matrixを使っていない場合は自分で git pull / pip update が必要だ。

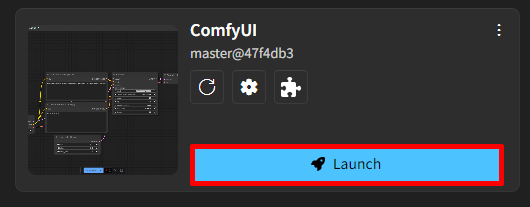

更新が終わったら「Launch」をクリックしてComfyUIを起動しよう。

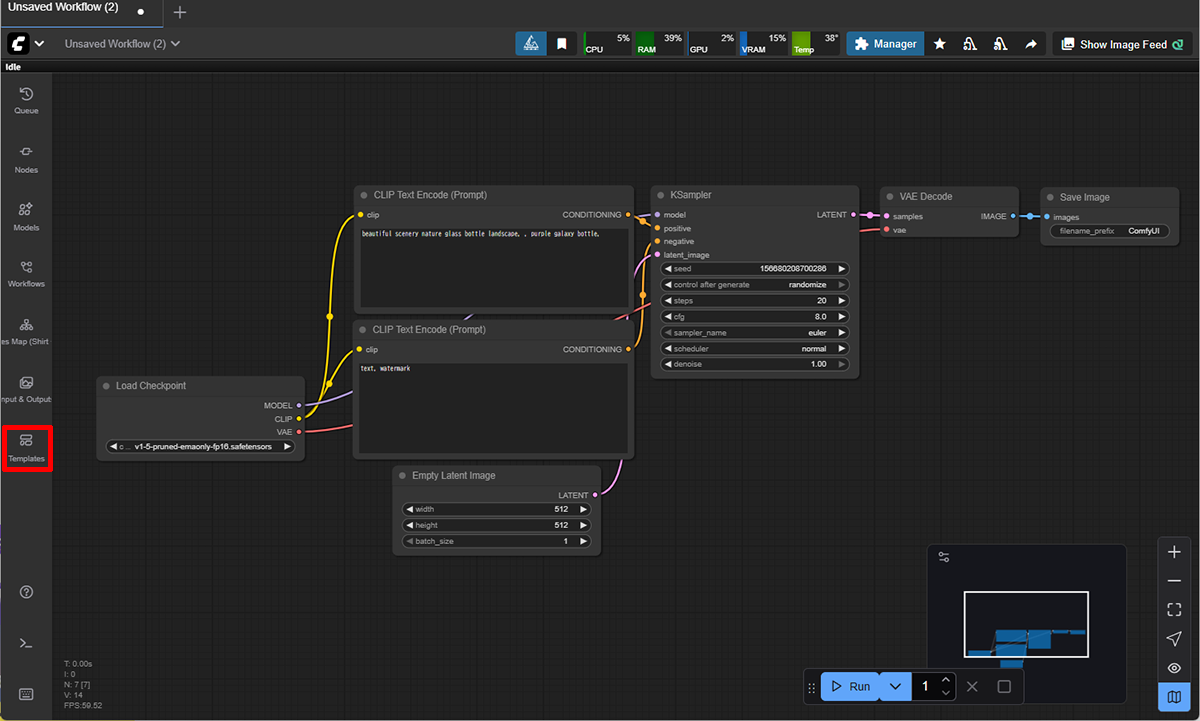

ComfyUIを起動すると、以前開いていたワークフローが表示されるが、それは無視して画面左の「Templates」をクリック。

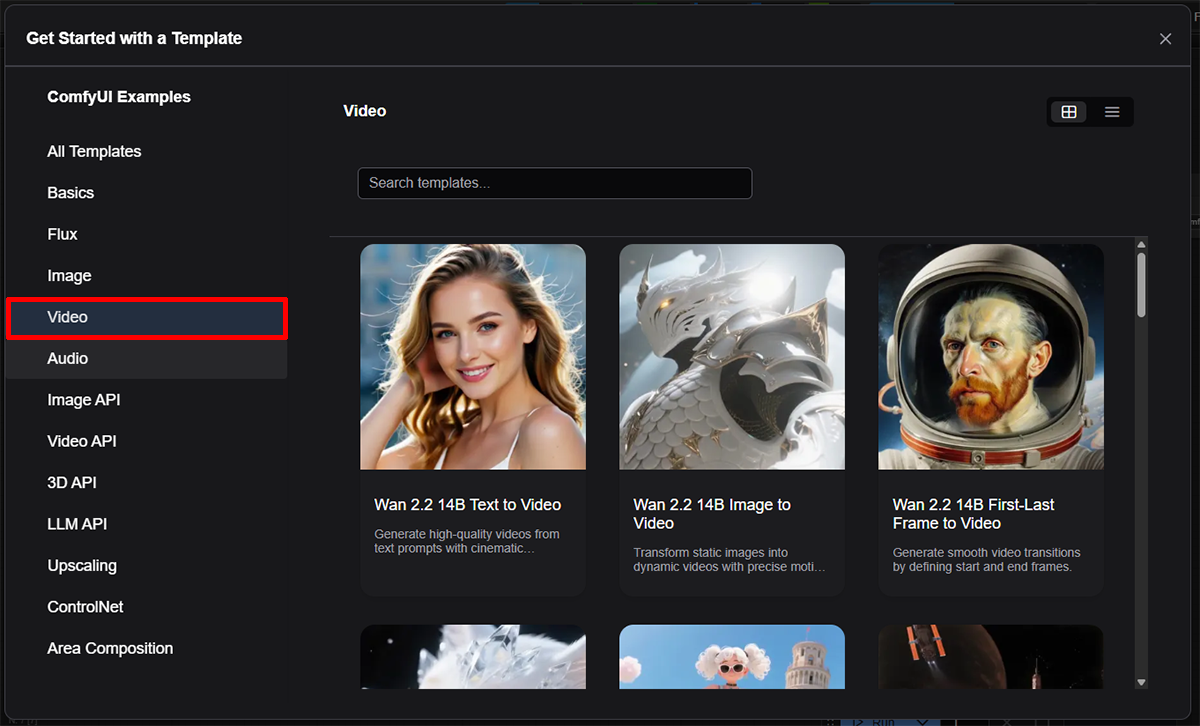

ワークフローのテンプレート一覧が表示される。ここでテンプレートを選ぶと、対応するワークフローが展開されることになる。まずはサイドバーで「Video」を選択。

少し下にスクロールすると「Wan 2.2 5B Text to Video」という「TI2V-5B(50億パラメーター)」モデルを使用するテンプレートがあるのでこれをクリック。

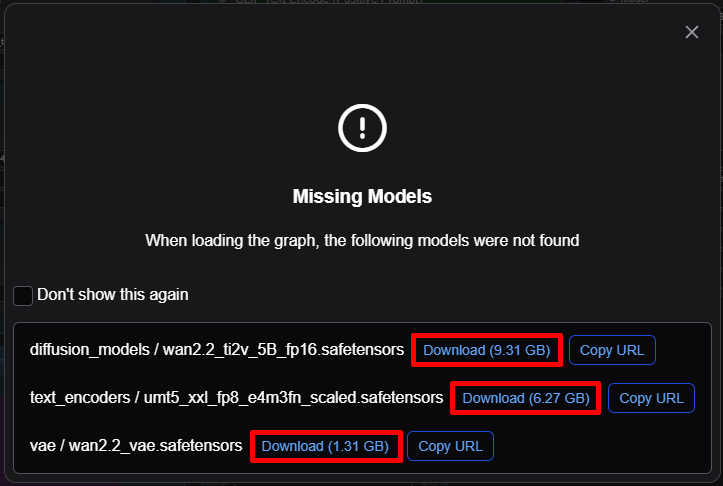

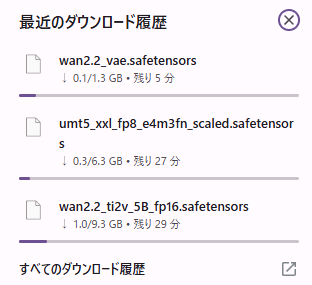

事前にモデルやVAEをダウンロードしていない場合ここで警告が表示される。すべてのDownloadリンクをクリックしてダウンロードをスタート。

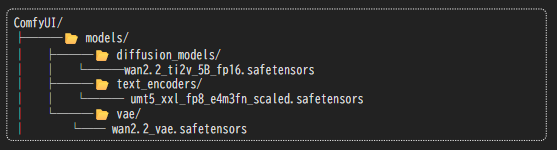

各ファイルの保存先はここになるのでしっかり確認しよう。

最大17GB近くのファイルをダウンロードすることになるのでそれなりの時間はかかる。

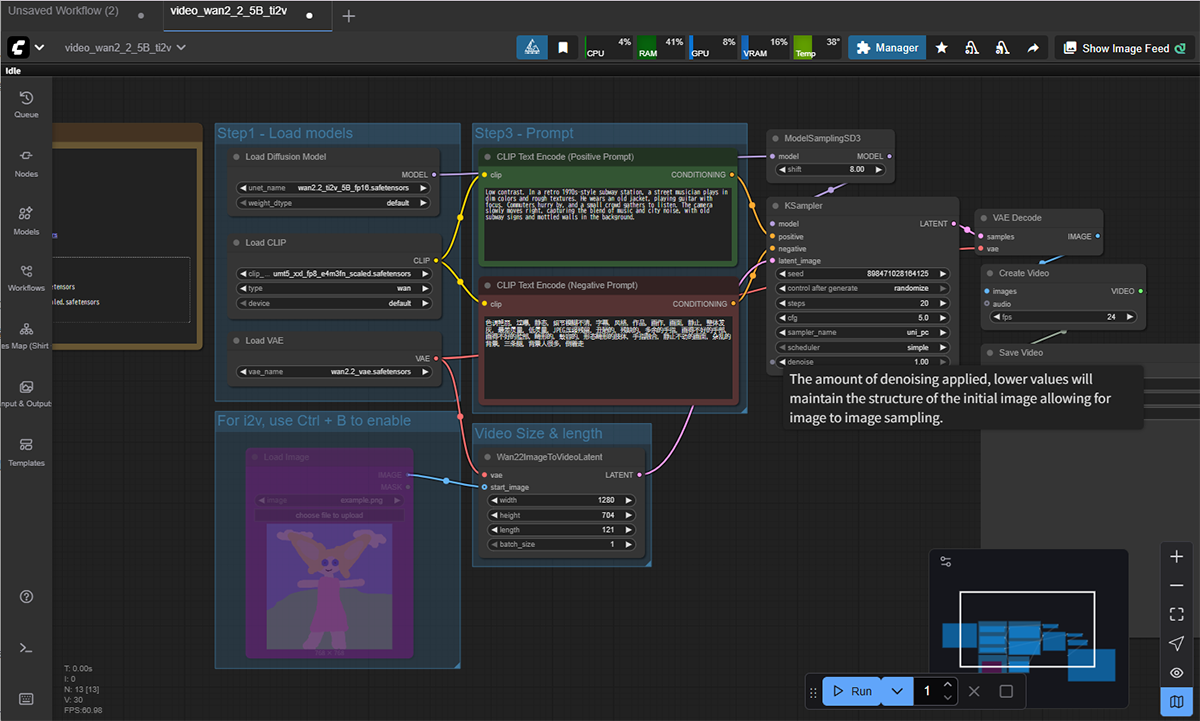

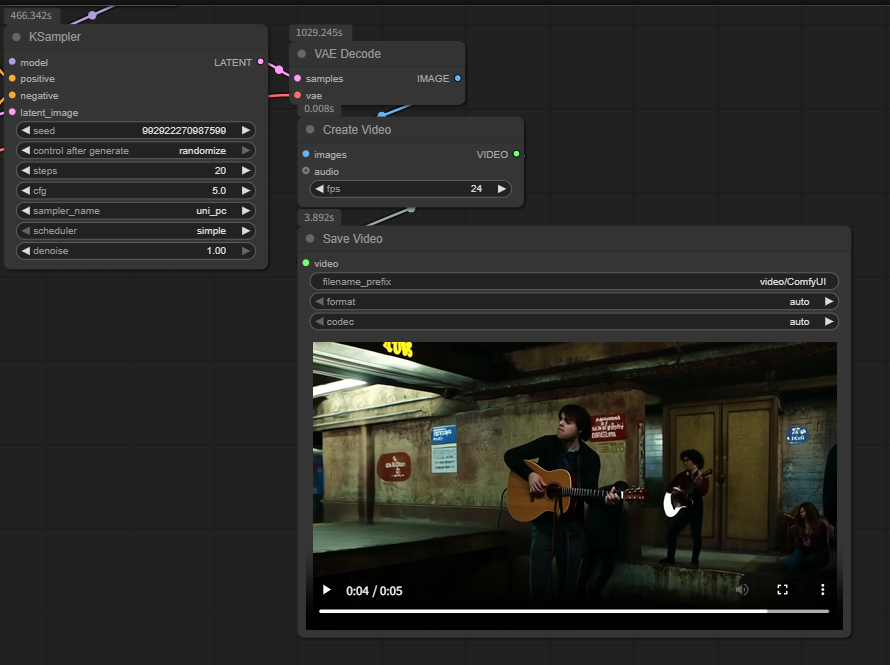

ダウンロードが終わるとComfyUI上に「Wan 2.2 5B Text to Video」ワークフローが展開される。

まずはプロンプトもそのままの状態で動画を生成してみよう。

右下の「Run」ボタン(もしくはShift+Enter)をクリックで生成が開始される。

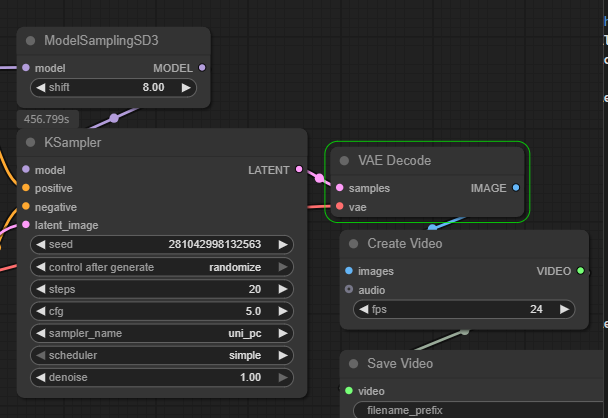

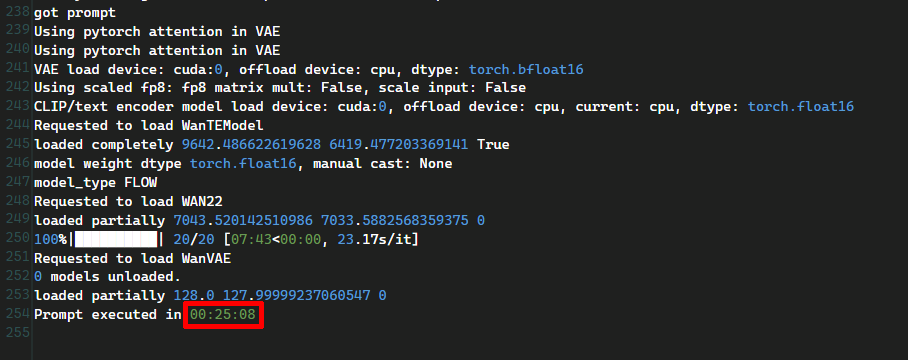

筆者の環境では「VAE Decode」ノードで10分近く動かなくなり少し心配になった。

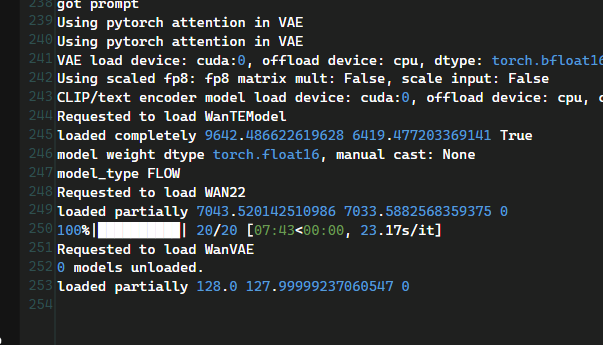

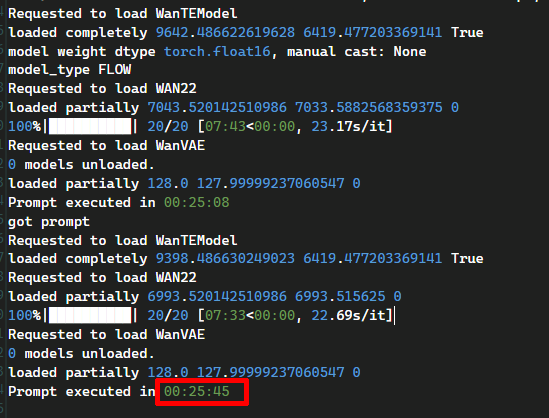

コンソールを見てみると、ログに「Requested to load WAN22」と表示されている。これはWan2.2本体モデルの読み込み開始を意味しており、ここからVAEなどの重いデータを展開するため数分間止まったように見えるのは正常動作だ。

しばらくそのまま待っているといきなり動画が完成し、右下の「Save Video」ノードに表示された。

5秒の動画を生成する所要時間は約25分だった。

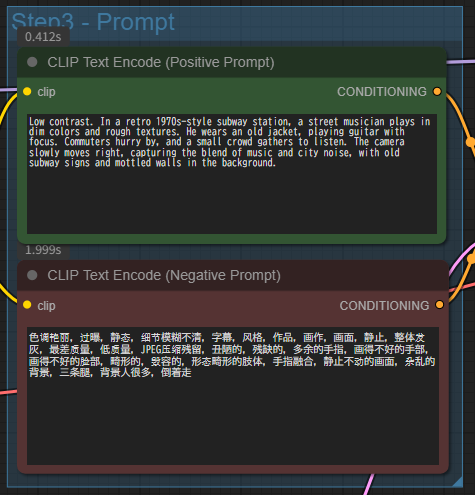

とは言え生成された動画はかなりクオリティーが高い。なお生成に使われたプロンプトは以下のデフォルトプロンプトだ。

プロンプト:Low contrast. In a retro 1970s-style subway station, a street musician plays in dim colors and rough textures. He wears an old jacket, playing guitar with focus and passion. Only a small light source from above illuminates the scene in the dark, atmospheric underground city lit less, with old subway signs and mottled walls in the background(低コントラスト。レトロな1970年代スタイルの地下鉄駅で、ストリートミュージシャンが薄暗い色彩と粗い質感の中で演奏している。彼は古いジャケットを着て、集中と情熱をもってギターを弾いている。上からの小さな光源のみが、古い地下鉄の標識とまだらな壁を背景にした、暗く雰囲気のある地下都市の照明の少ないシーンを照らしている。)

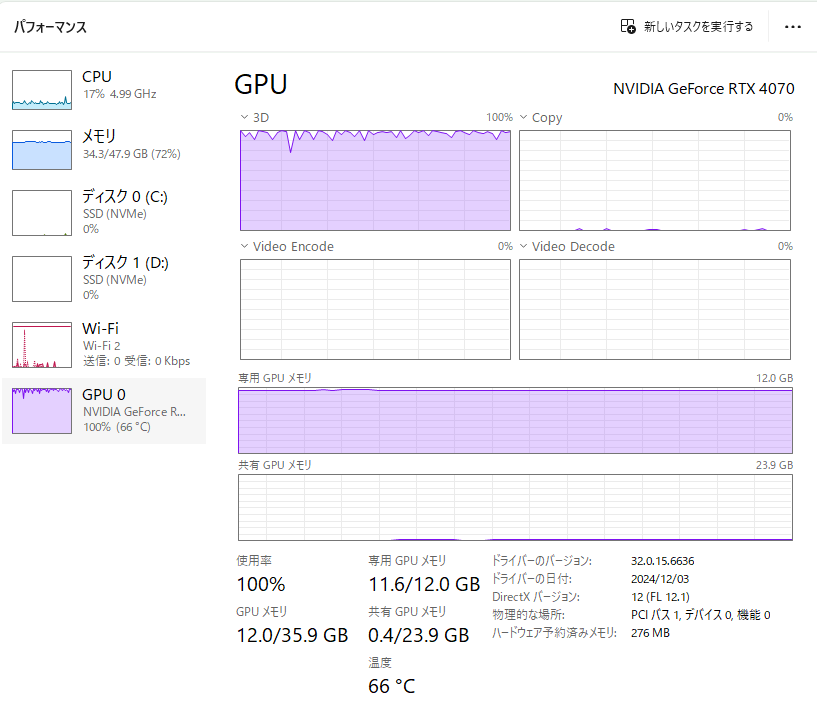

生成時のパフォーマンス。GPUメモリーは11.6GB使用、それでは全然足りないのでCPUメモリーも大量に使っているのがわかる。温度も66度とまあまあ高い。ただしCPUの負荷は限定的だ。

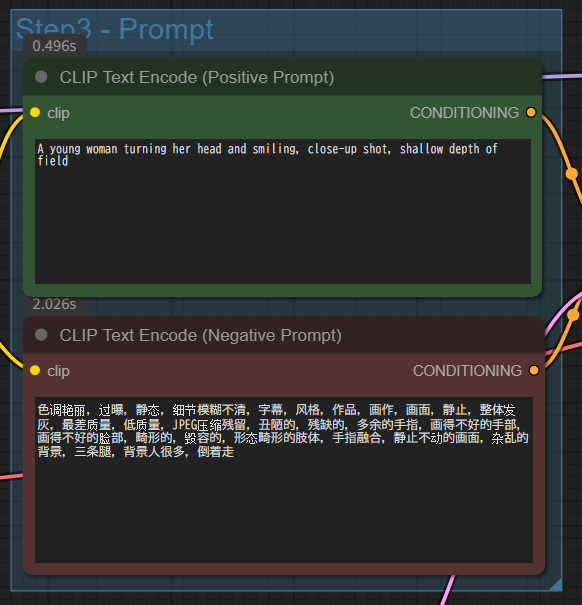

次にプロンプトをこちらで考えたものに差し替えて生成してみる。

プロンプト:A young woman turning her head and smiling, close-up shot, shallow depth of field(頭を振り返って微笑む若い女性、クローズアップショット、浅い被写界深度)

こちらが生成された動画。少々イメージとは違ったが生成された動画に破綻はなさそうだ。

2回目の生成ということで多少のスピードアップを期待したが生成時間は変わらなかった。

以上RTX 4070(12GB VRAM)環境でも問題なく動作し、高品質な動画が得られることが確認できた。ただしVAEのロードや生成には時間がかかり、短尺でも実時間の数倍〜十倍以上の待ち時間が発生してしまった。また、VRAMが12GBと限られているため、毎回メモリーをやりくりしながらモデルをロードする必要があり、2回目以降も時間が短縮されることはなく、ほぼ同じ時間がかかってしまった。

これ以上のスピードを求めるなら解像度やフレーム数を下げるなど調整を追い込んでいく必要があるだろう。量子化モデルやLoRA軽量化を検討するのも手だ。

なお、5B(50億)パラメーターモデルでこの状態なので、「T2V-A14B」や「I2V-A14B」といったよりサイズの大きなモデルをこのままの状態で動かすのは現実的ではないだろうということで今回は割愛。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります