NVIDIAがデータセンターを「AI工場」として再定義、将来的に数兆ドル規模に達すると予測 COMPUTEX2025基調講演

2025年05月20日 00時50分更新

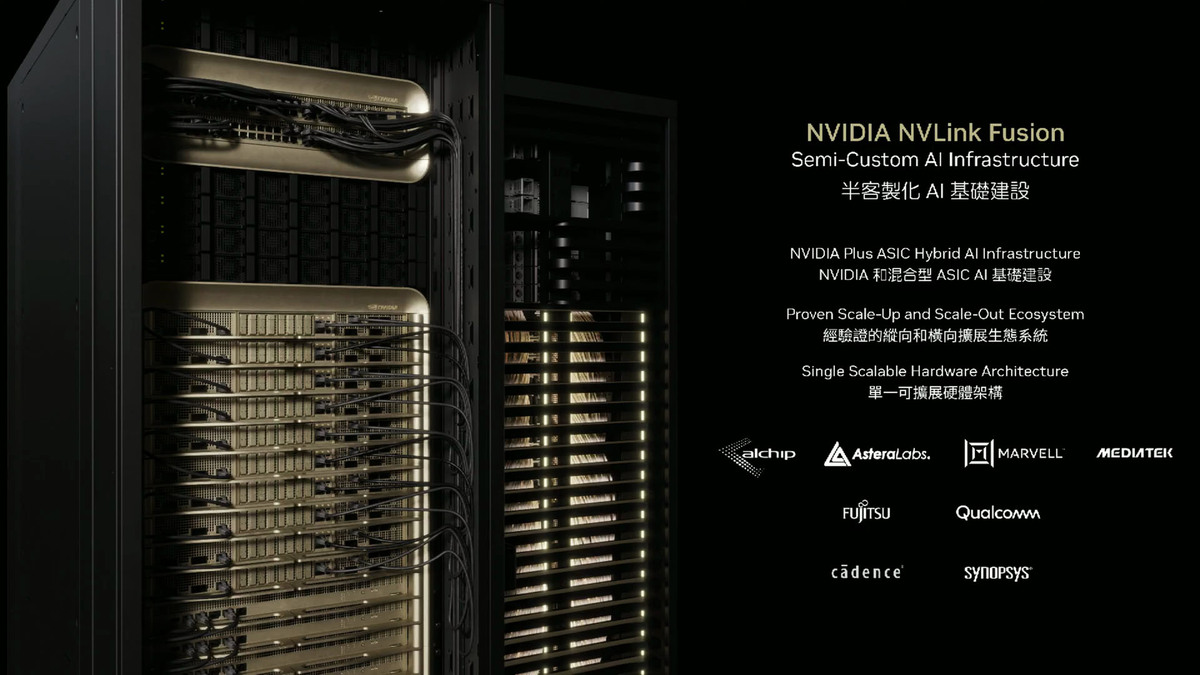

NVLink Fusionによる半導体カスタムAIインフラ構築

NVIDIAは、あらゆる企業がAIインフラストラクチャーを構築できるようにするため、新たに「NVIDIA NVLink Fusion」を発表した。これは、従来の半導体カスタムチップだけでなく、半導体カスタムAIインフラストラクチャーを構築することを可能にする。NVIDIAのCPU、GPU、NVLinkスイッチ、Spectrum Xネットワーキング、InfiniBand NICからなるNVIDIAプラットフォームを全面的に採用することも可能だが、顧客が独自のカスタムASICやCPUを組み込むことも可能となる。

NVLink Fusionでは、顧客のカスタムASICの隣にNVLinkチップレットを配置し、NVIDIAのコンピュートボードやAIスーパーコンピューターのエコシステムに統合する。また、顧客独自のCPUを活用したい場合は、NVIDIAが提供するNVLinkチップ間インターフェースを顧客ASICに統合し、NVLinkチップレットを介してBlackwellや次世代のRubenチップに接続することも可能となる。

これにより、顧客は独自のAIインフラストラクチャーにおいて、NVIDIAのコンポーネントと自社または他社のコンポーネントを柔軟に組み合わせ、NVLinkインフラストラクチャーとエコシステムの利点を享受できるようになる。

NVLink Fusionエコシステムのパートナーとして、ASICおよび半導体カスタムプロバイダーのMediaTek、Marvell、Alchip Technologies、Astera Labsと協業。ハイパースケーラーやCPUベンダーがカスタムシステムを構築するのを支援する。また、富士通とQualcommはNVLinkを搭載したCPUを開発し、NVIDIAのエコシステムに統合する。CadenceとSynopsysは、NVLink対応の設計ツールとIPを提供し、チップ開発を支援する。

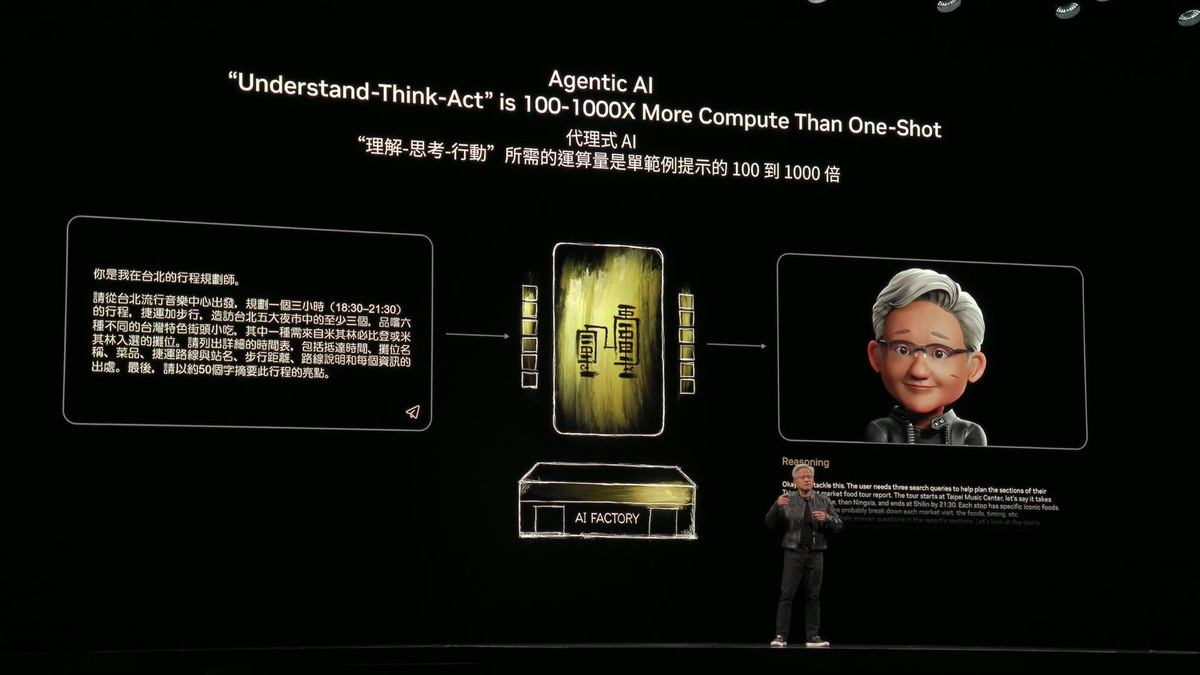

エンタープライズIT向けAgentic AIと新たなプラットフォーム

ファン氏はAIをエンタープライズITの世界にもたらすため、コンピューティング、ストレージ、ネットワーキングの各層を再発明する必要があると指摘した。この新しい能力の中核となるのが、「Agentic AI」(エージェントAI)である。エージェントAIは、推論、ツール使用、他のAIとの協調作業が可能であり、デジタルワーカーとして機能する。

2030年までに予測される労働力不足を補い、企業の成長を加速させる潜在力を持つ。NVIDIA社内では、ソフトウェアエンジニアの100%がすでにデジタルエージェントを活用し、生産性を向上させている。企業のIT部門は、将来的にはこれらのデジタルワーカーを管理、改善、評価する役割を担うことになるだろうと予測した。

Agentic AIをエンタープライズITに導入するため、NVIDIAは「RTX Pro Enterprise and Omniverse Server」を発表した。このサーバーはx86互換であり、従来のハイパーバイザー(VMware、Red Hat、Nutanixなど)やKubernetesをサポートし、Citrixなどの仮想デスクトップストリーミングにも対応する。これにより、エンタープライズIT部門は既存の管理手法をそのまま適用可能。さらに、Omniverseのワークロードを実行できるだけでなく、テキスト、グラフィックス、ビデオなど、多様なモダリティーのAgentic AIワークロードを処理できる。

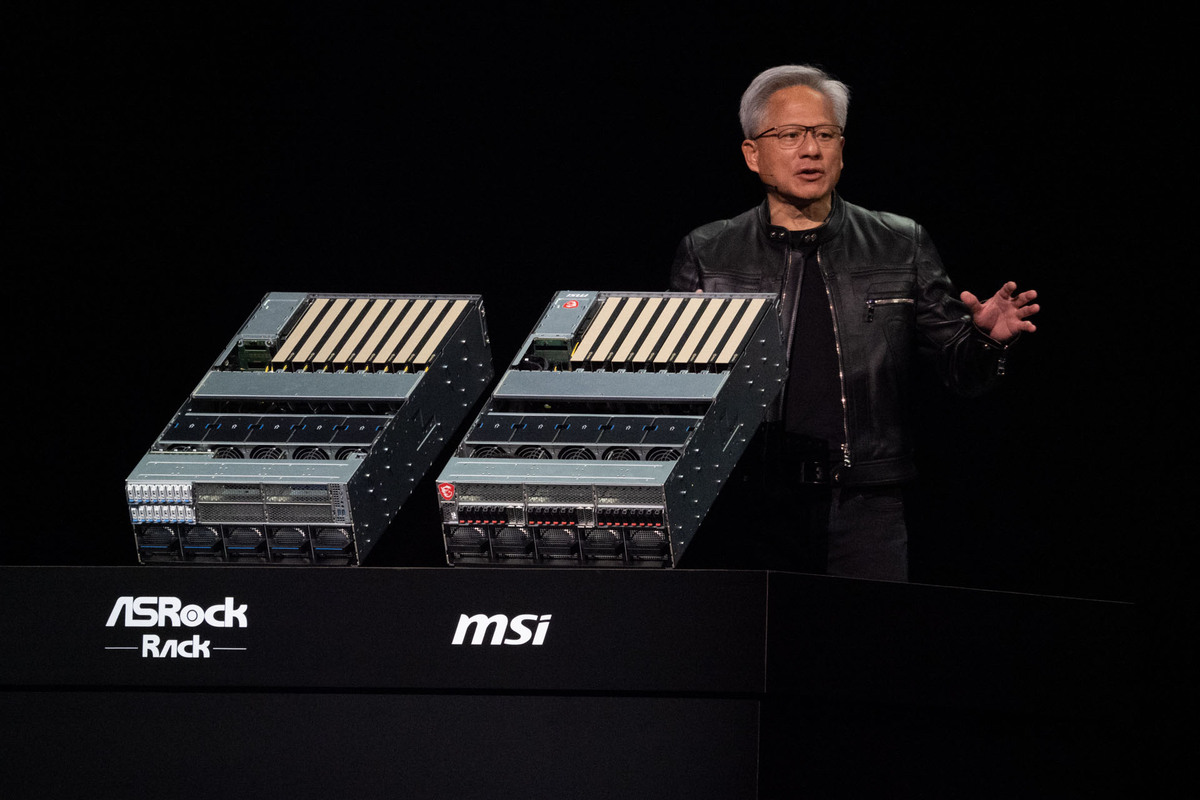

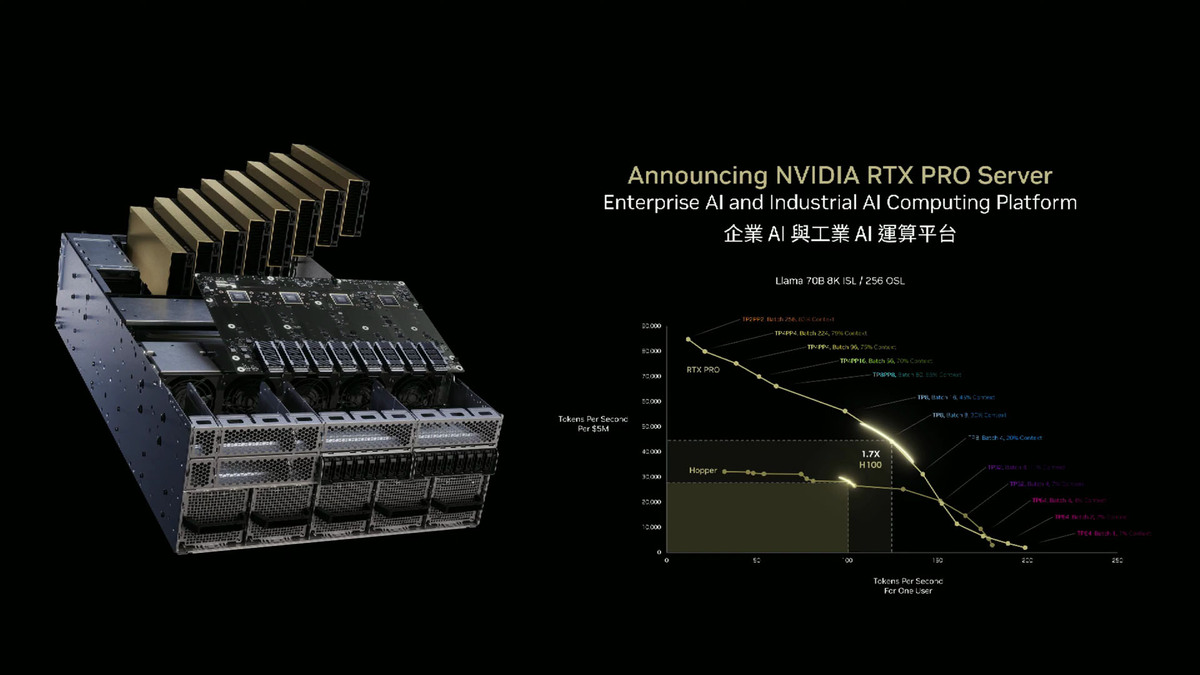

RTX Pro Serverは、新しいCX8チップによって8基のBlackwell RTX Pro 6000 GPUを接続する。CX8はスイッチングとネットワーキングの機能を併せ持ち、800ギガビット/秒の高速ネットワーキング帯域幅を提供する。性能デモでは、Deepseek R1モデルにおいて、Hopper H100ベースのHGXサーバーの4倍の性能を示した。これはDeepseek R1の最適化と貢献によるものだとファン氏は話している。

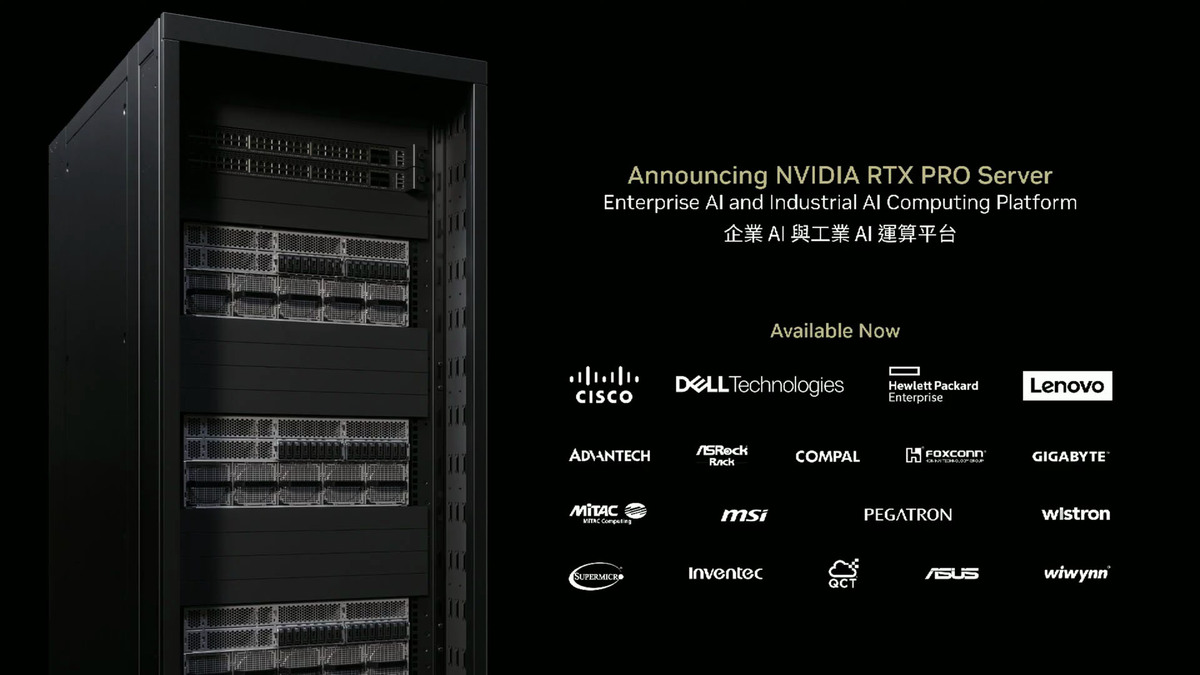

RTX Proサーバーは、Dell Technologies、Hewlett Packard Enterprise、Lenovo、Supermicro、ASUS、Gigabyte、MSIなど、主要なパートナー企業から大量生産され、これまでで最大規模の市場投入となる見込みである。

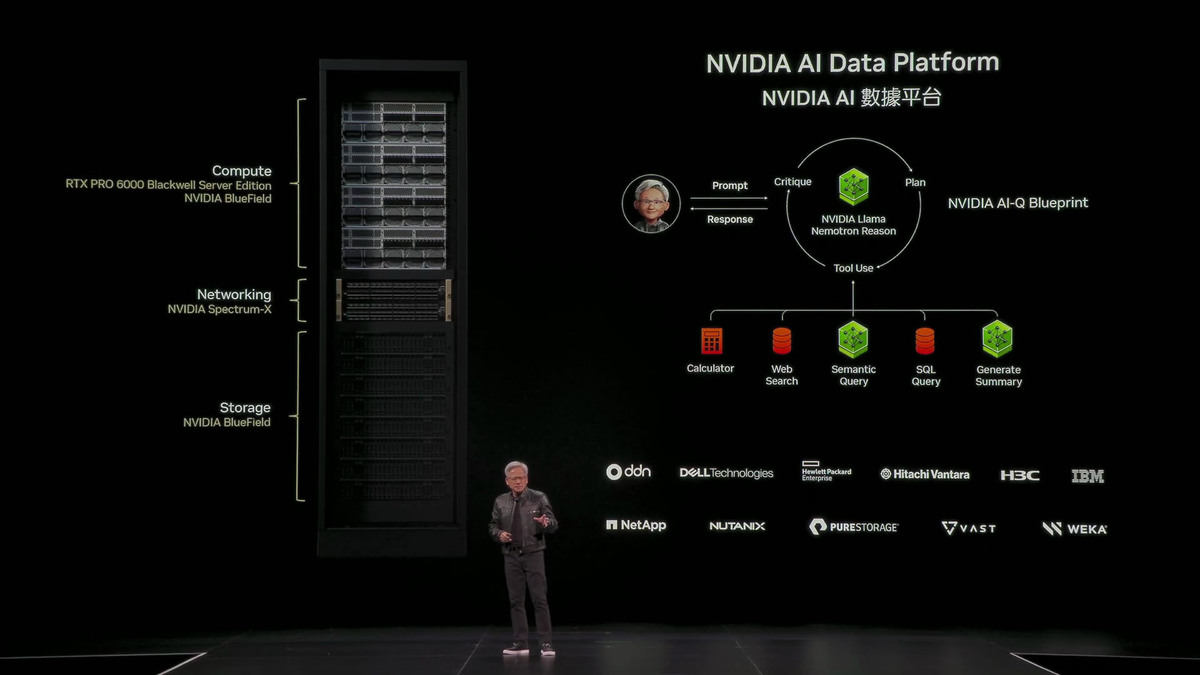

さらにファン氏は、ストレージ分野でも再発明が必要となると述べている。人間がSQLのような構造化データベースをクエリするのに対し、AIは非構造化データから意味(セマンティクス)を抽出したいと考える。このため、NVIDIAは「NVIDIA AI Data Platform」と新しいクエリシステム「NVIDIA IQ」を発表した。

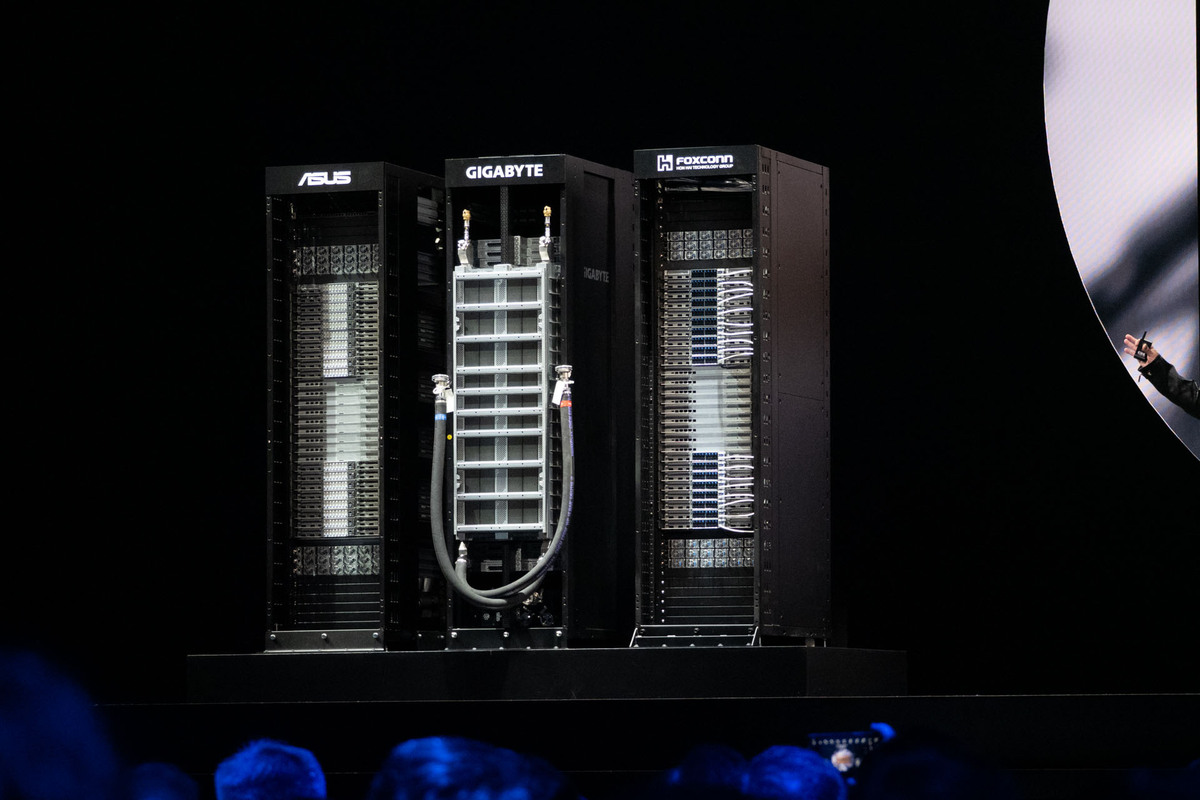

将来のストレージサーバーは、ストレージラックの前面にCPUではなくGPUコンピューティングノードを持つようになると予測。これは、非構造化データからの意味抽出、インデックス作成、検索、ランキングといった処理が計算集約的であるためである。

NVIDIAは、Llama NeMo-Tronicのような高性能な推論モデルを提供し、 retrieval-augmented generation (RAG) に必要なNemo Retrieverライブラリーを提供する。IQブループリントはオープンソースで提供され、Vast、Dell、Hitachi、IBM、NetApp、Nutanix、Pure Storage、VAST Data、WEKAといったストレージ業界のパートナー企業と協力し、AIデータプラットフォームへの統合を進める。

AI Opsは、企業のAIエージェントを管理するための新しいソフトウェアレイヤーだ。データキュレーション、モデルのファインチューニング、評価、ガードレール設定、セキュリティ確保といった機能を提供する。NVIDIAは、CrowdStrike、Data IQ、Data Robots、DataStax、Elastic、Nutanix、Red Hat、Trend Microといったパートナー企業と協力し、エンタープライズIT環境にAIを導入するためのエコシステムを構築する。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります