第765回

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ

2024年04月01日 12時00分更新

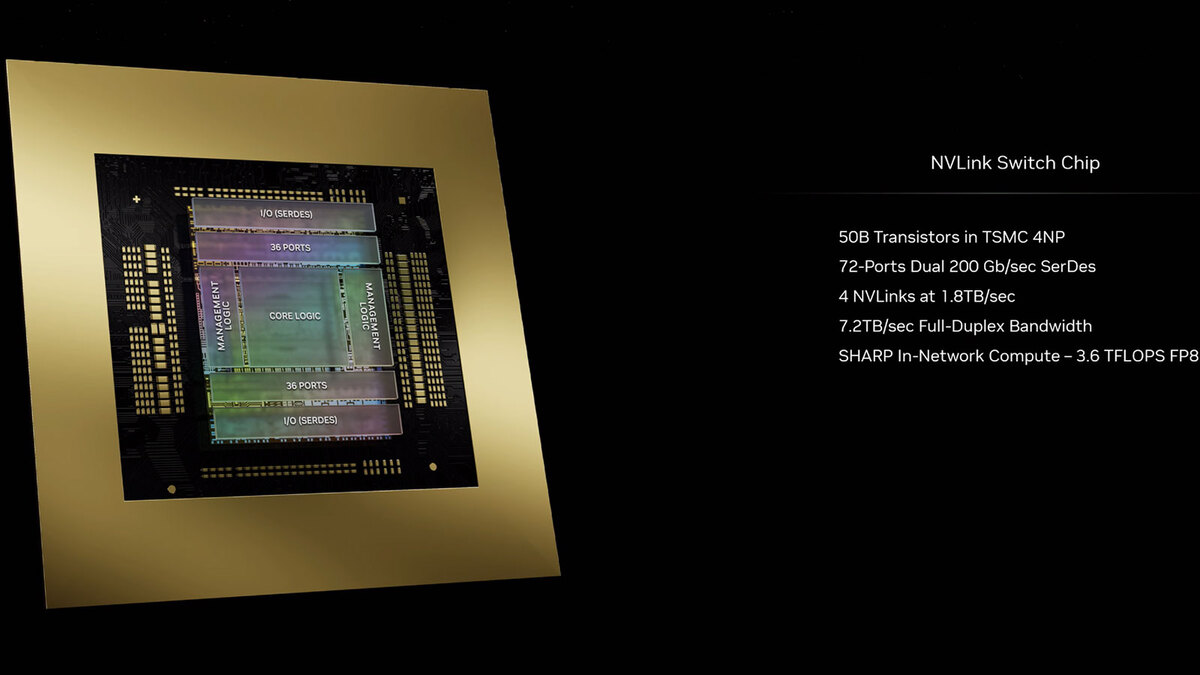

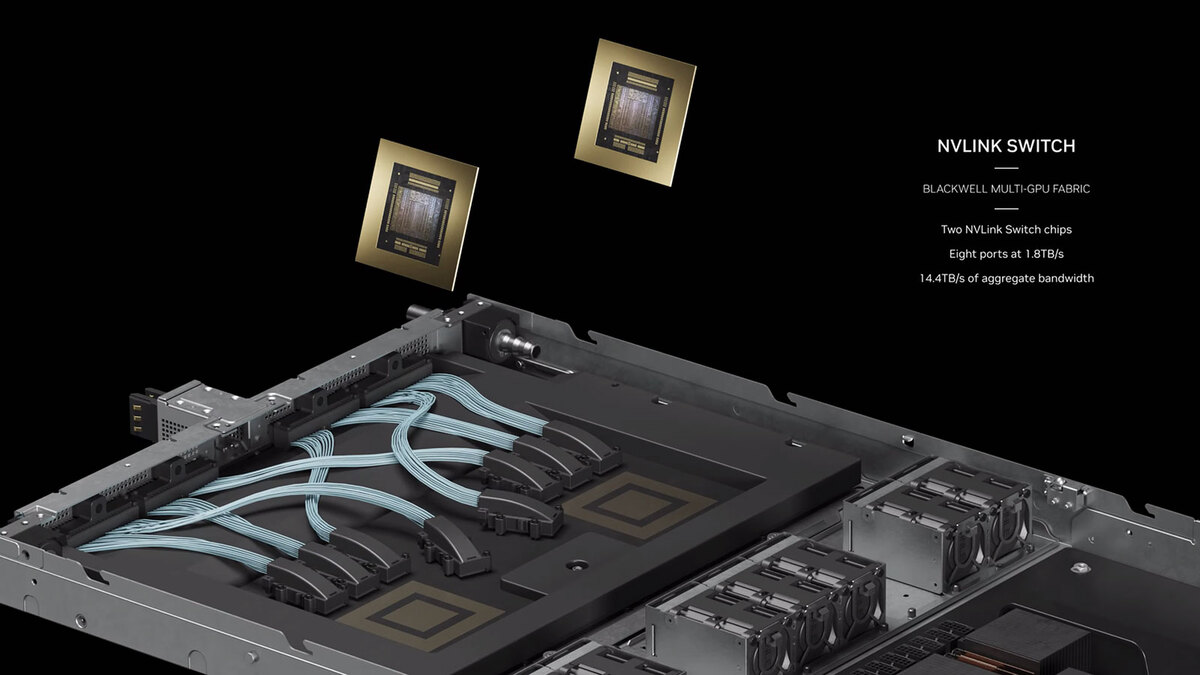

I/Fチップは1つあたり4本のNVLinkを外部に出せる

インターコネクトは引き続きNVLinkが利用されるが、こちらもなかなか壮絶な構成である。今回利用されるNVLinkは第5世代になるが、I/Fチップは1つあたり4本のNVLinkを外部に出せるようになっている。

I/Fチップ。SHARPはHierarchical Aggregation and Reduction Protocolの略で、元はInfiniBandに実装されていたもの。Switch側で一部の計算処理をすることでGPUの負荷を減らすもので、このケースではFP8で3.6TFlopsの演算性能を持つとされる

1本のNVLinkは18本の100Gbpsのレーンから構成される。上の画像には200Gbpsと書いてあるが、これはUp/Downの合計であり、1方向あたりでは100Gbpsになる。

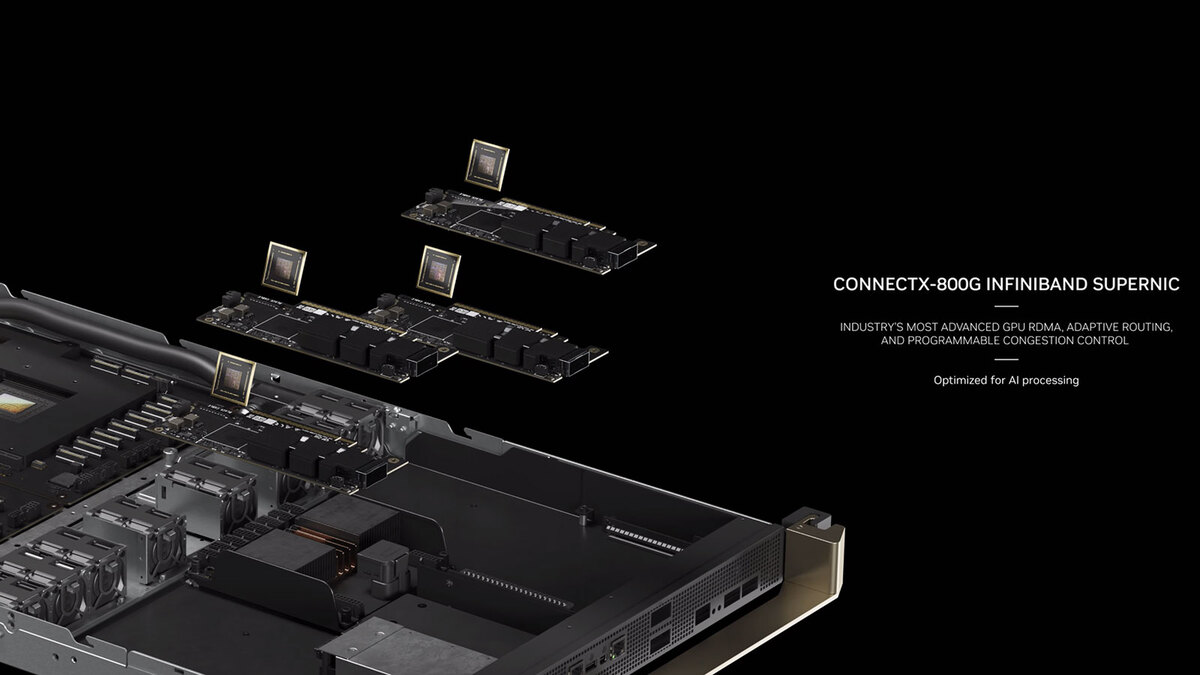

NVLinkそのものは1本あたり1.8Gbpsの帯域を持つわけだが、Blackwell Compute NodeにはこのNVLink Switchが2つ搭載される。つまり1つのBlackwell Compute Nodeから8本のNVLinkが外部に引っ張り出せる計算だ。ちなみにインターコネクトとしては、これとは別にConnectX-800 InfiniBand Switchカードを4枚搭載できるようだ。

ConnectX-800 InfiniBand Switchカード。位置的にはGB200 Grace Blackwell Superchipの下にこれが隠れている格好だが、このチップの放熱はどうするのだろう? このCGからは省かれているだけで、ヒートパイプが別に配慮されているのかもしれない

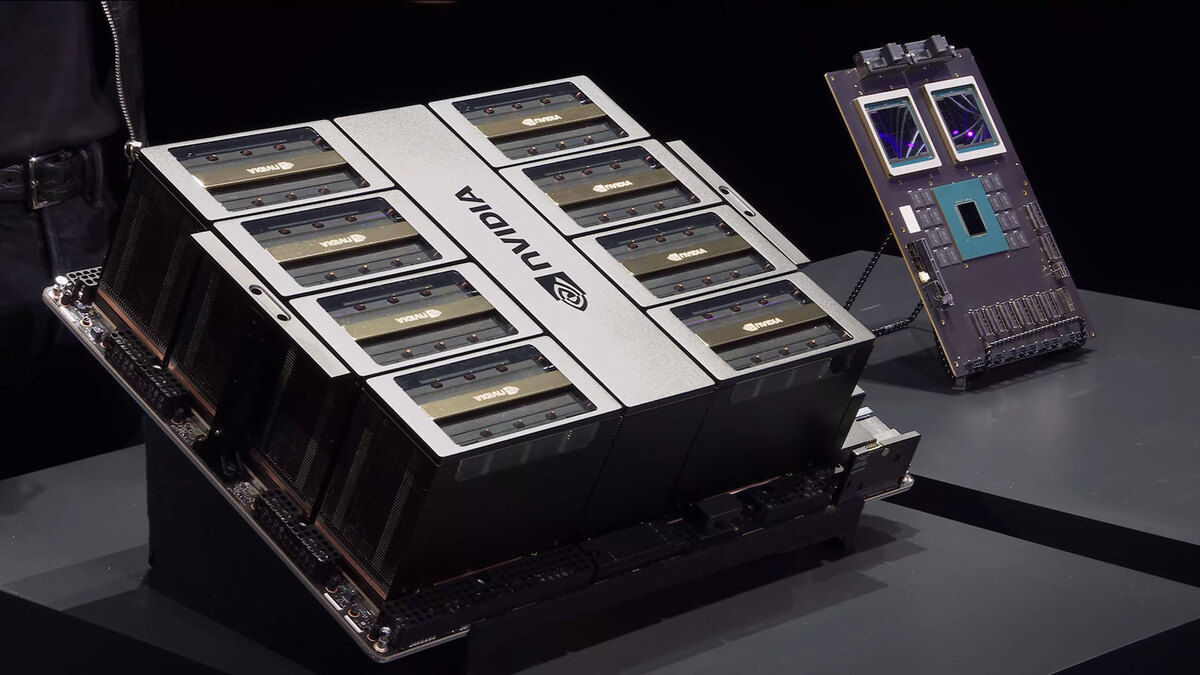

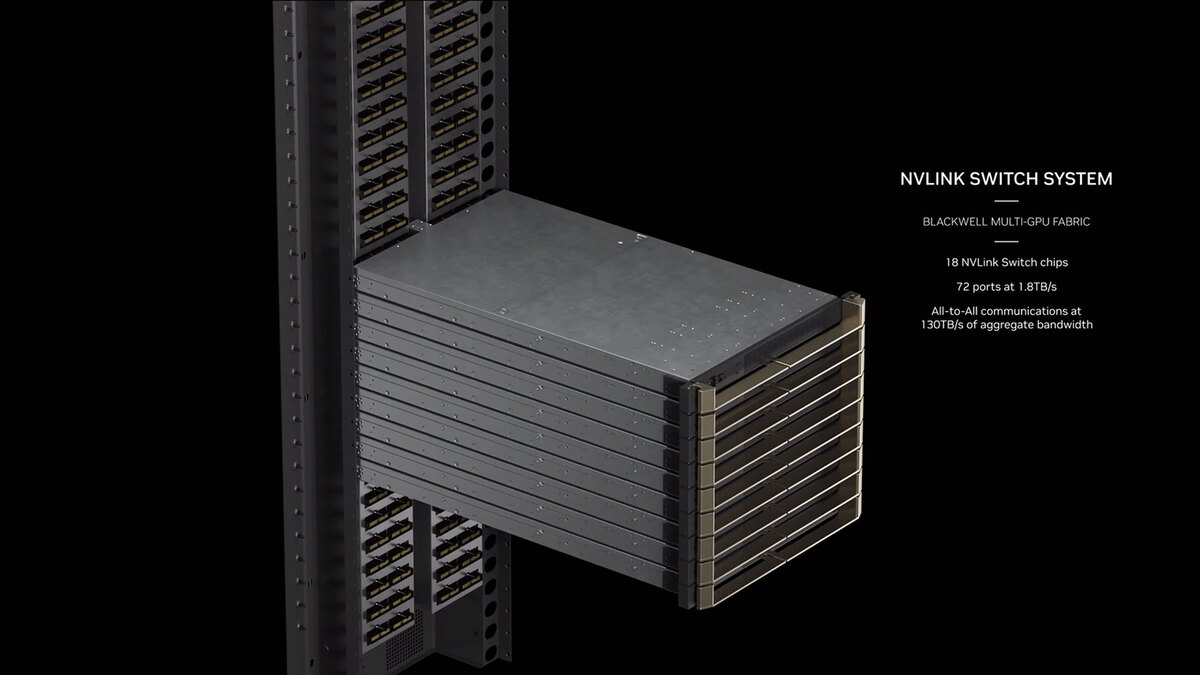

このNVLinkのI/F同士の接続に、9枚のInfiniBand Switchシステムが、Blackwell Compute Nodeの間に挟まるように入る。

これでBlackwell Compute Node同士の相互接続だけでなく、複数のNVL72同士の接続も行なう形であろう。ただこれはあくまでもBlackwell GPU同士の相互接続であって、Graceの方はこのNVLinkの接続の恩恵を受けない。いやがんばってGraceからBlackwell経由でNVLinkを使った通信を行なうことも不可能ではないのだろうが、効率が悪すぎる。

18 NVLink Switch Chipというのは、おそらく「1枚の」NVLINK Switch Systemのブレード内に実装される。つまり1枚のブレードに72ポートのNVLinkが接続できる構造であると思われる(でないと勘定が合わない)。ただ、本当に1Uのブレードに72ポートものNVLinkのコネクターを物理的に配せるのだろうか? (やりようはいろいろあるだろうが……)

こちらの用途のために、TOR(Top of Rack)にInfiniBand Switchも搭載される格好だ。

NVL72にはこのQuantum InfiniBand Switchが2つ実装され、合計64ポートあることになる。ただSwitch同士の相互接続分に加えて、GB200 Grace Blackwell Superchipへの接続に最低36ポート必要で、これだけで40ポート強が埋まる形になる。残りはNVL72同士の接続用だろう

これで1つのNVL72が構成されるわけだが、当然配線はすさまじいことになっている。

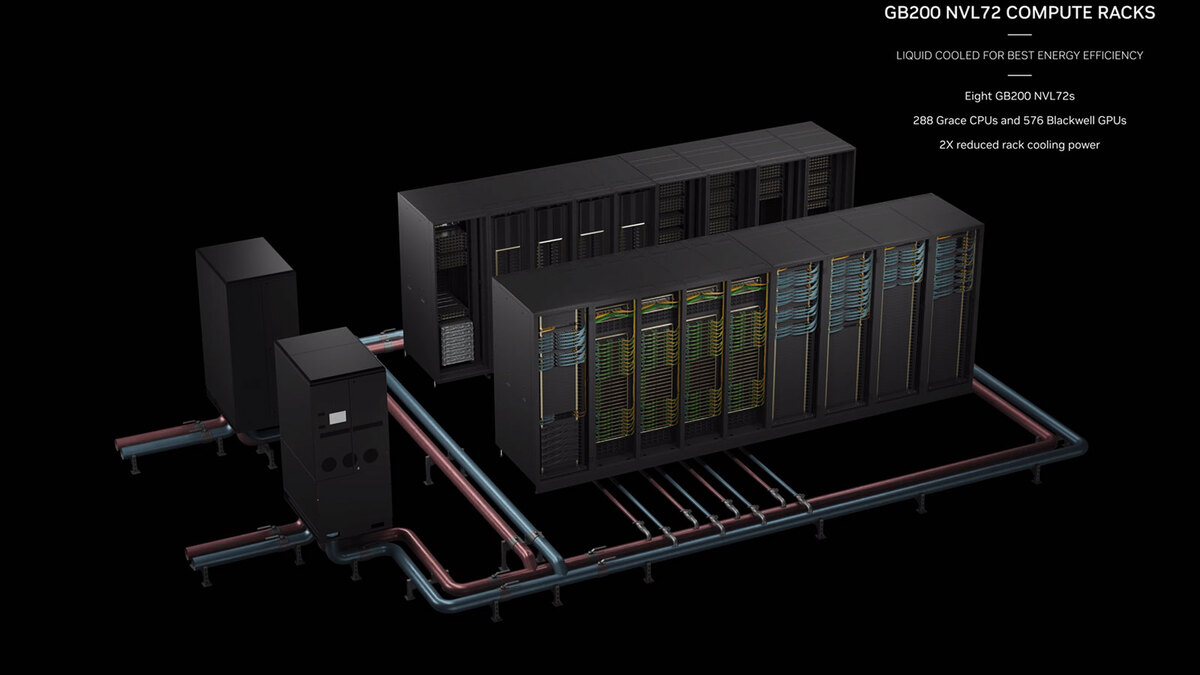

NVIDIAはこのNVL72を8本組み合わせた構成では、従来(おそらくGH200)比で冷却コストを半分にできるとしている。これは同一数のラックと比較してなのか、同一の演算処理で比較してなのかはっきりしないが、なんとなく前者な気がする。

要するにGH200ベースだと9本のラックのうち8本をGH200が占めるのに、GB200では4本なので半減という計算な気がする。さらに将来的には400本以上のNVL72を並べれば、645EFlopsの猛烈なAI Factoryが構成可能とアピールするが、そもそも16000枚のGB200 Grace Blackwell Superchipを製造できるのはいつのことなのか? というのが偽らざる感想である。

さて、ここまではGraceと組み合わせたGB200 Grace Blackwell Superchipの話だが、これ以外にキャリアボードに実装されたB100/B200のみの構成も用意されている。それがHGXB200/B100である。

8つのB100/B200をまとめて提供する形なのは、AMDのInstinct MI300Xなどと同じである。ロードマップ的にはB40という製品もあるようなので、いずれはPCIeカードの形の提供も予定されているのだろうが、当面はこのキャリアボードの形のみでの提供になると思われる。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります