第764回

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ

2024年03月25日 12時00分更新

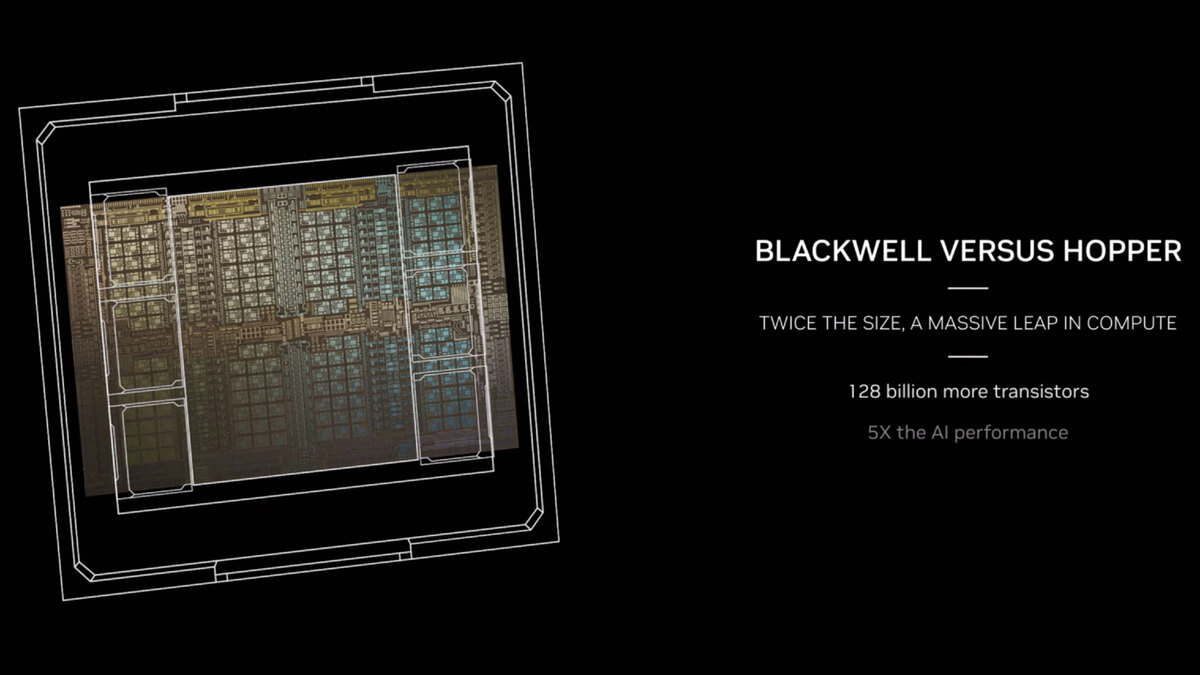

BlackwellのダイそのものはHopperよりもやや小さい

前ページでBlackwellのダイサイズを推定したが、実際にHopperのパッケージと比較したのが下の画像だ。

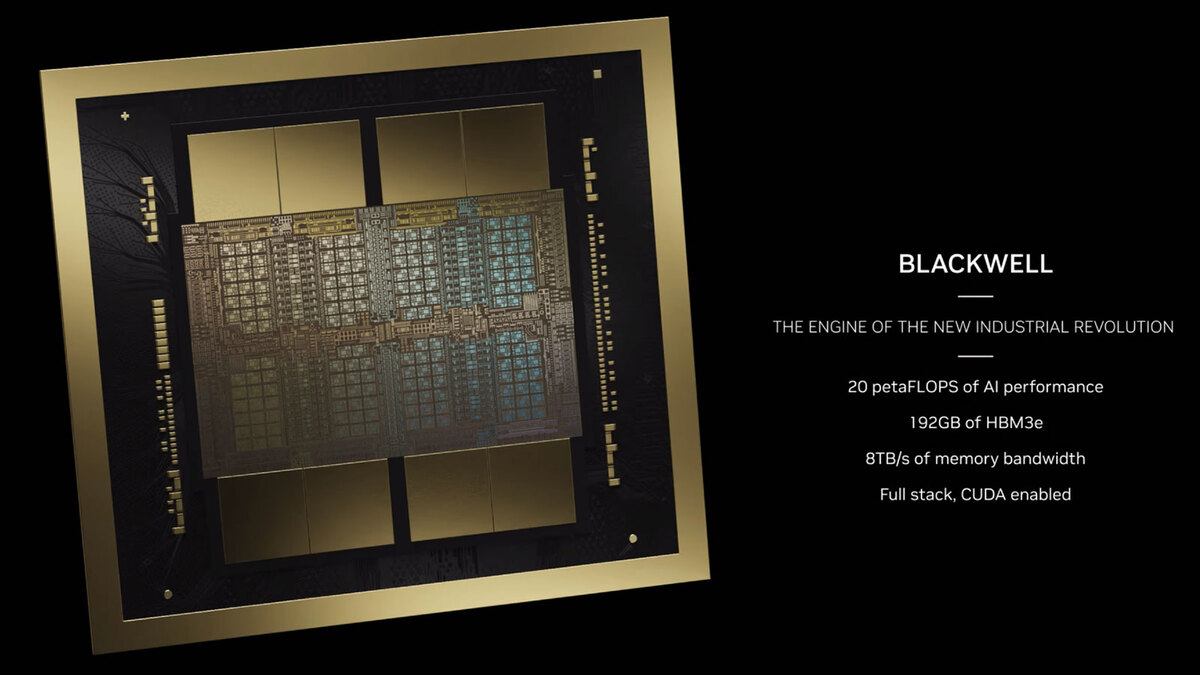

パッケージ全体で言うと、下の画像のとおりB100は一回り以上巨大である。

実際に上の画像を回転させ、歪みを補正したのが下の画像である。ここからダイサイズを計算したところ、意外もBlackwellのダイそのものはHopperよりもやや小さく、783.4mm2と算出された。

あるいは2次キャッシュの容量そのものが少し減り(これで大きく面積が削減できる)、CUDA Coreの方にトランジスタを割いた(これはSRAMほど面積が増えない)のが大きいのかもしれない。

ところで今回の基調講演を含む一連の説明の中で、一度も「2つのダイをどう接続しているか」に関する説明がなかった。可能性が一番高いのはTSMCのCoWoSだろうが、CoWoS-S(シリコン・ インターポーザーを使った2.5D積層)は最大でも1700mm2(Reticle Limitの2倍)となっており、Blackwell×2だけならともかくHBM3e×8を搭載まで搭載するのは絶対に不可能である。

ではCoWoS-R(有機パッケージを使ったインターポーザー)は? というと、HBM3eが本当に通るのかがまだ未知数である。一番可能性が高いのは、インテルのEMIBと同じく、有機パッケージの中にシリコン・ インターポーザーを埋め目込んだCoWoS-Lであろう(AMDのInstinct MI250Xのように、ASEのFOCoSを使う可能性は低いはずだ)。

B100はAI性能がH100の5倍

次は性能の話だ。"5X the AI performance"というのがB100の特徴である。つまりAI性能がH100の5倍というわけだ。もちろんこれはピーク性能なのだが。それでもB100が1個あたり20PFlopsのAI処理性能、192GBのHBM3eでメモリー帯域は8TB/秒とされている。

要するに1スタックあたり24GBのHBM3eで、12層で1層あたり容量2GBということになる。また帯域はトータル8TB/秒なので1スタックあたり1TB/秒。3月19日にSK Hynixが発表したHBM3Eあたりが一番の有力候補だ

これに絡んで今回発表されたのが、第2世代のTransformer Engineと、これを利用することでFP4/FP6のサポートが可能になった、という話だ。

Transformer EngineはA100/H100世代のGPUで搭載されている機能で、動的に変数の型を変更して精度のリキャストやスケーリングの自動調整が可能なものだが、第2世代ではFP4/FP6が追加された。

まだFP4の詳細は不明だが、普通に考えれば符号1bit、仮数部1~2bit、指数部2~1bitの合計4bitであり、FP8の半分で表現できることになる。ということは同じ規模の演算器なら2倍の処理が可能になる。性能5倍のうちの2倍が、このFP4のサポートで賄われると考えられる。

また2ダイ構成ということは、これで2倍の性能になるということで、FP4のサポートと併せて、4倍の性能向上が確保された格好だ。ということで残り1.25倍が、ダイそのものの構成あるいは動作周波数によるものと考えられる。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります