3月4日の公開以来、「Claudeやばくない?」「GPT-4を越えた」と、界隈で話題の「Claude 3」は、OpenAIの元メンバーによって設立されたAIベンチャー「Anthropic」が開発する最新の大規模言語モデル(LLM)だ。今回はChatGPTのライバルClaude 3の有料版を2週間ほどヘビーに使ってみて感じたことを、良い点と悪い点どちらも書いていきたいと思う。

Claude 3とは?

既報の通り、Claude 3はAnthropicが開発する大規模言語モデルの名称だ。

パラメーターのサイズなどが異なる3つのモデルがラインアップされている。

「Claude 3 Opus」は最も知能が高く、複雑なタスクでも最高のパフォーマンスを発揮する強力なモデル。APIやデータベースを介した複雑なアクションの計画や実行、インタラクティブコーディングなどの高度な活用が想定されている。

「Claude 3 Sonnet」は能力と速度の理想的なバランスを目指したモデル。同等のモデルと比較して低コストで強力なパフォーマンスを発揮する。主にデータ処理やマーケティング、品質管理といった企業向けソリューションでの利用が想定されている。

「Claude 3 Haiku」は、コストと反応速度に特化した、ファミリーで最もコンパクトなモデル。ランニングコストもサイズもファミリーで最も小さいため比較的小規模なプロジェクトに向いている。

Claude 3はAPI経由、またはChatGPTのようなチャット型AI「Claude.ai」を使って利用することになる。

Claude.aiではHaikuおよびSonnetモデルを無料で利用できるが、最も高性能なOpusモデルの利用には有料(20米ドル/月)プランの「Claude Pro」に加入する必要がある。

各種ベンチマークではOpusが多くの項目で、現在最高峰とされているGPT-4の数値を越えている。

とはいえベンチマークの数値が絶対かといえば、そうでもないことは皆様御存知だろう。

巨大なコンテキストウィンドウ

ここからしばらくは、筆者が実際に2週間以上Claude 3を使ってみて「よかった」と思ったところを紹介する。なお、特に断りがない限りこれ以降すべての結果は最高性能のClaude 3 Opusを利用している。

Claude 3の特徴の一つに巨大なコンテキストウィンドウがある。LLMのコンテキストウィンドウの値は、一度に参照できるテキストの量、つまりモデルが理解や生成のために「覚えている」テキストの範囲を指す。

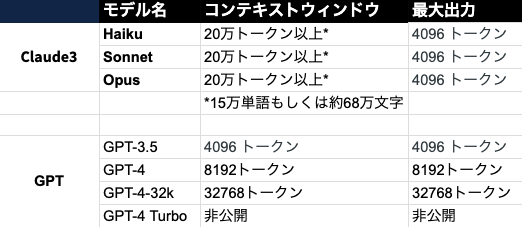

Claude 3は、すべてのモデルに20万トークンのコンテキストウィンドウが提供されている。

トークンとはテキストをLLMが理解するための最小単位で、日本語の場合テキストの傾向にもよるが、1トークンおよそ1〜3、4文字程度になると言われている。つまり、Claude 3は20万〜80万文字のテキストを一度に扱えるということになる。これがどれほどすごい数字なのかは、GPTの数値を見ればわかるだろう。

それでは実際に文字量の多いコンテンツを入力した例を見てみよう。

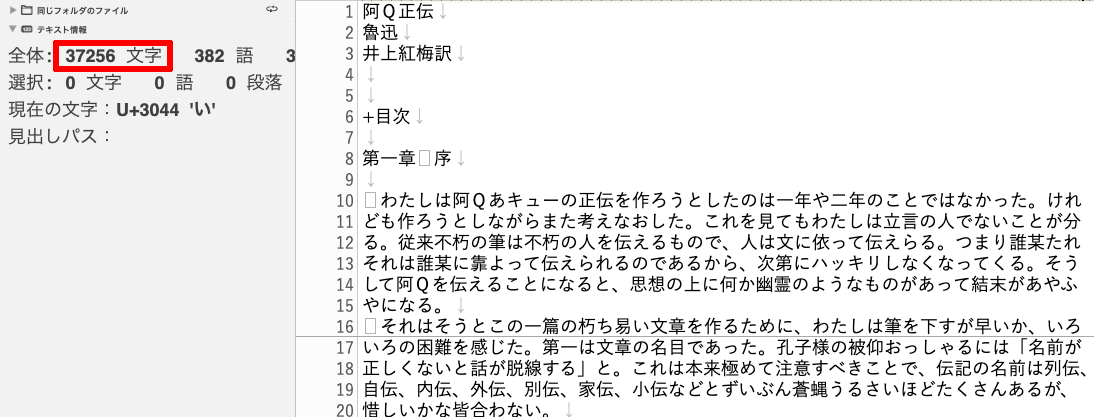

今回は青空文庫から魯迅の名作「阿Q正伝」をダウンロードして使ってみることにする。

テキストエディターで開くと文字数はおよそ3万7000字。それほど多くはないが、それでも1万トークン以上はあるだろう。

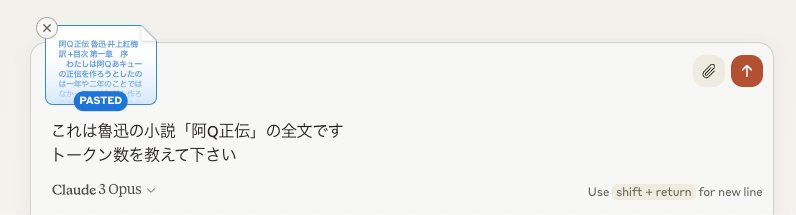

テキスト全文をClaude.aiにコピー&ペーストし、まずはトークン数を聞いてみよう。プロンプトは以下だ。

プロンプト:これは魯迅の小説「阿Q正伝」の全文です。トークン数を教えて下さい

さすがに処理時間は少し長かったが、トークン数(1万9590トークン)と簡単なあらすじが出力された。

「主な登場人物」と入力するだけで、キャラクターの名前と簡単な紹介文を作成してくれた。このような雑な指示にも関わらず期待通りの挙動をしてくれるのはとても気持ちがいい。

プロンプト:物語内の大きな出来事を時系列順に整理して

ここでは単に「あらすじを教えて」ではなく、「大きな出来事を」「時系列順に整理して」と細かい指示を与えてみたが、理解してくれているようだ。

このように、一度長文を読ませてしまえば、どんなプロンプトでもそれなりにしっかりした回答を出してくる印象だ。

プロンプト:阿Qが再び未荘に現れたときなにが起こったか、順を追って説明してください

とはいえ、このような有名作品の場合、すでに事前学習であらすじや登場人物などは知識として持っているかもしれないので、本当にテキストをすべて読んでいるのか確かめるために、物語後半の出来事をピンポイントで聞いてみたが、しっかり細かく説明してくれた。

だが、これもあらかじめ全文を読みこんだわけではなく、「質問されてから」読みに行ったという可能性も否定できない。便利は便利なのだが、100%の信頼を置くわけにはいかない、といった感じだ。

なお、ChatGPT Pro(GPT-4)で同じテキストを入力しようとすると、「長すぎる」というメッセージが出てしまう。GPT-4のコンテキストウィンドウは8192トークンなのでギリギリ足りなかった感じか。

さすがに9万字を超えるテキストはClaude 3でも読み込めないようだ。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります