4Kまで行かないと差が出ない

ここより実ゲームでのベンチマーク検証となるが、画質は基本的に最高設定、レイトレーシングが使えるならそれも使用した。さらに解像度はフルHD(1920×1080ドット)/WQHD(2560×1440ドット)/4K(3840×2160ドット)の3通りでフレームレートを比較する。フレームレートの計測は「CapFrameX」を利用し、計測時に各GPUが実際にどの程度の電力を消費しているか(平均値)というデータに加え、各ベンチマーク時の平均フレームレートと合わせて算出した10Wあたりのフレームレート(ワットパフォーマンス)も比較するとしよう。

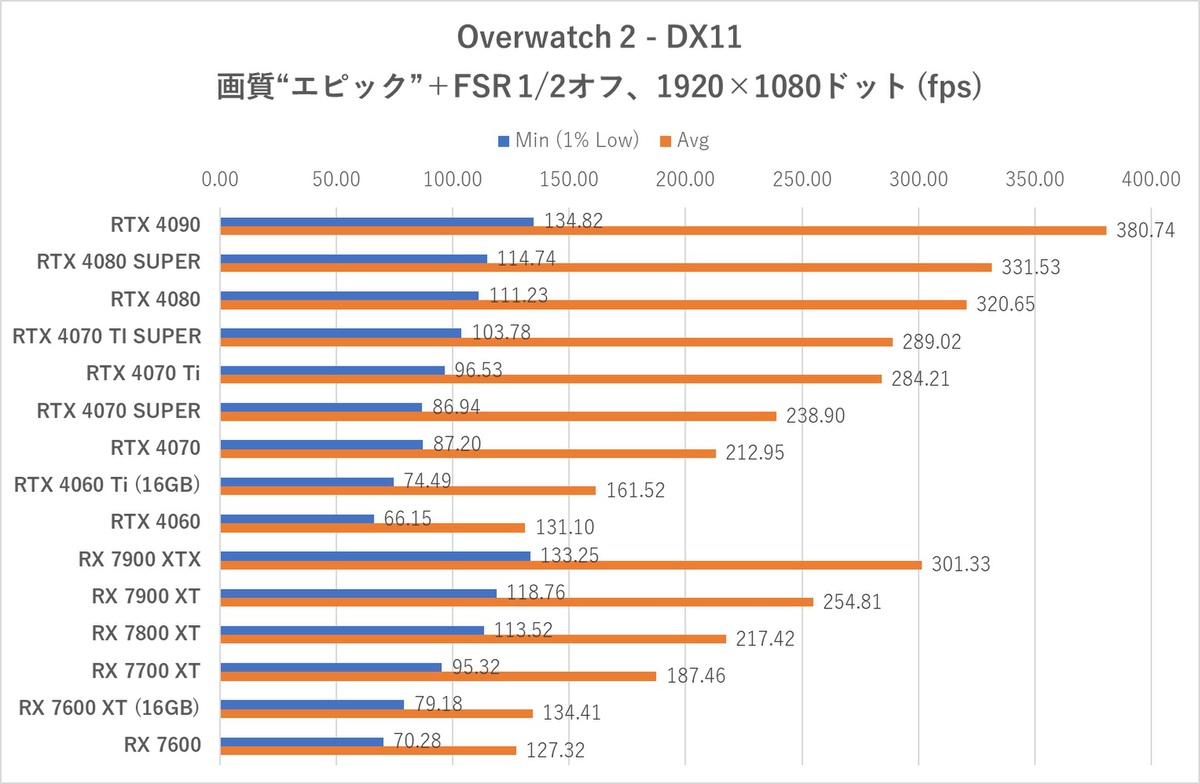

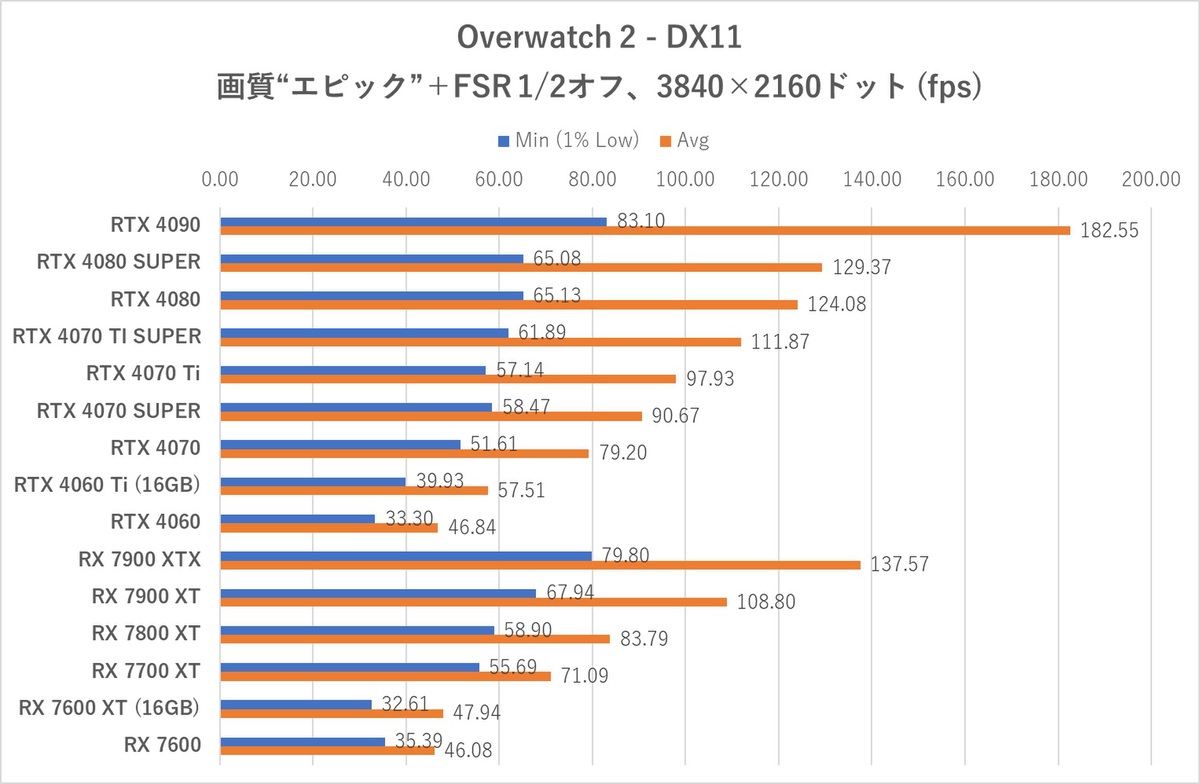

まずは「Overwatch 2」からスタートだ。画質“エピック”をベースにレンダースケール100%、フレームレート上限600fps、さらにFSR 1/2はオフに設定。マップ“Eichenwalde”におけるBotマッチ観戦中のフレームレートを計測した。

このテストはフレーム生成技術を使わない、GPUの力比べ的な意味で実施している。GeForce系への最適化が進んだゲームのせいか、Radeon勢は全体的に不調。RTX 4080 SUPERはRTX 4080よりもフレームレートは高いが、印象的にはRTX 4080のファクトリーOCモデルとあまり大差無い印象だ。

4Kともなると平均フレームレートにおいて5fps程度の差が出るが、RTX 4090の突き抜けっぷりに完全に取り残されている。SUPERと付いてはいるもののSUPER感があまりない、というのがRTX 4080 SUPERの残念なところといえるだろう。

上記フレームレートのデータが観測された際に、各GPUが実際に消費した消費電力(TBP:Total Board Power)の平均値、ならびにTBPと平均フレームレートから求められるTBP 10Wあたりのフレームレートも比較してみる。

前掲の3DMarkテスト中の消費電力は実ゲーム中の消費電力の傾向と異なる、ということがわかるだろうか? 解像度を上げてもRX 7000シリーズはほとんど消費電力が増えない一方で、RTX 40シリーズはRTX 4070より上のモデルになるほど解像度と消費電力が連動する。

これはAda Lovelace世代特有の巨大L2キャッシュがもたらす効果である。RTX 4080 SUPERの消費電力はRTX 4080と大差ない。RTX 4090はさすがに大飯食らいだが、解像度を下げれば消費電力も下がる。RTX 40シリーズのワットパフォーマンスが高いのはこのためだ。

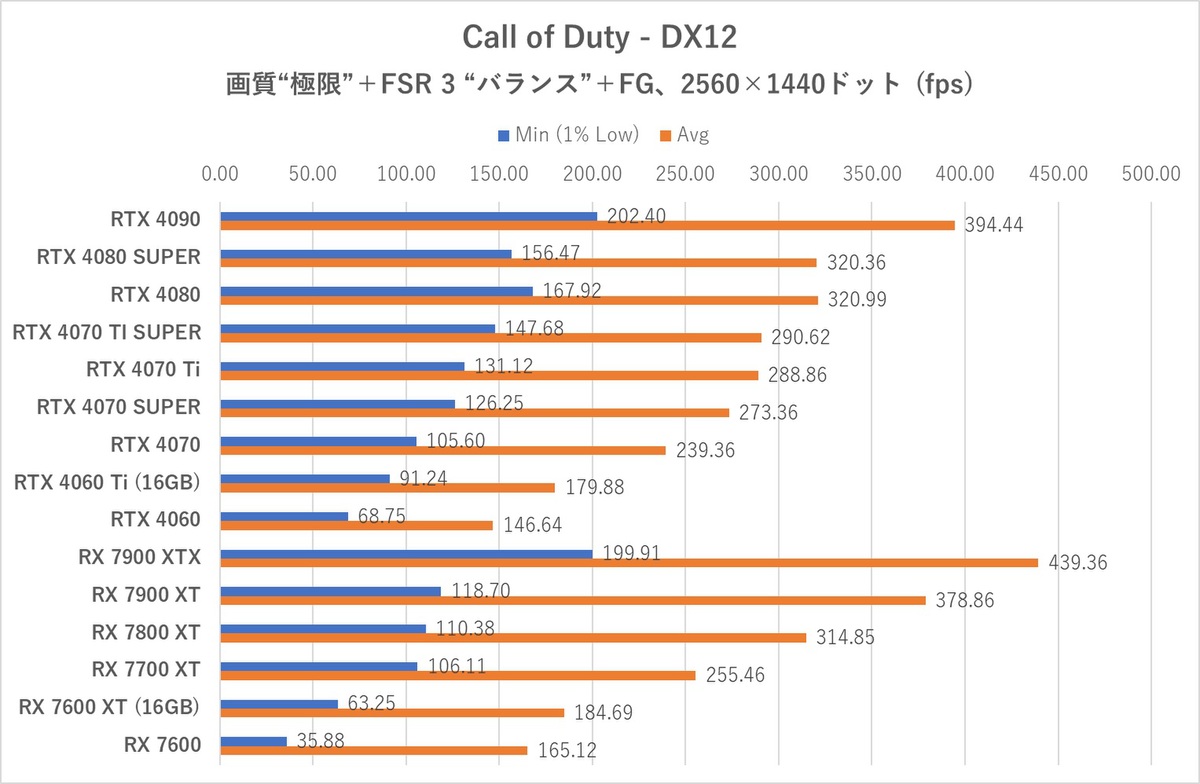

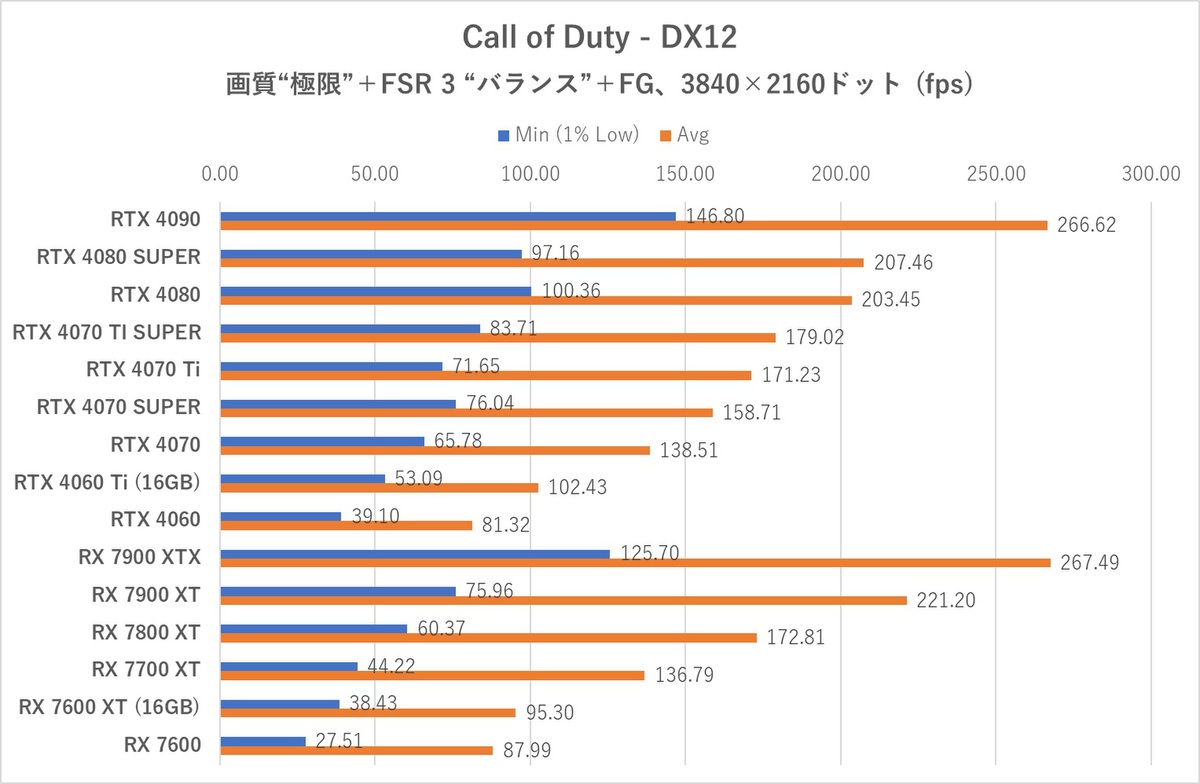

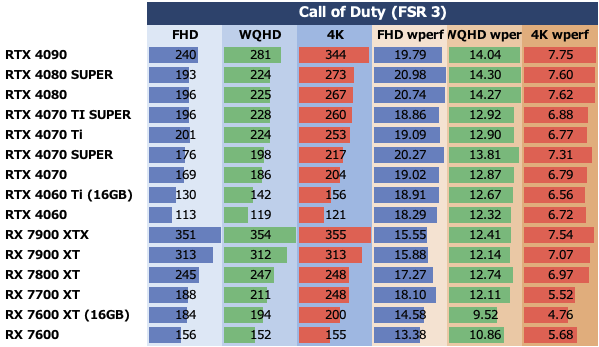

「Call of Duty」はGPUを問わず使えるフレーム生成機能「FSR 3」を利用した状態で力比べをしてみよう。画質は“極限”とし、FSR 3のフレーム生成機能はオンに、アップスケーリングは“バランス”設定とした。このゲームはレイトレーシングも実装されているが、ごく限定されたシーンでしか使われないので無視している。「Modern Warfare III」についてくるゲーム内ベンチマーク再生中のフレームレートを計測した。

Call of DutyはOverwatch 2とは逆にRadeonとの相性が良い。特に解像度フルHDではRadeonのハイエンド勢がGeForceを圧倒。RTX 4080 SUPERはドライバーに難があるのか、最低フレームレートの落ち込みが大きくなった(最近CoDの挙動がやや怪しいのも原因のひとつである)。フルHD/WQHDではRTX 4080より僅差でフレームレートが下回ったが、4Kになると逆転している。

FSR 3のフレーム生成機能と、Radeonに対する相性の良さから、Radeon勢のワットパフォーマンスがOverwatch 2に比べると高い。RTX 4080 SUPERはRTX 4080にフレームレートで負ける/ 差が出なかった解像度では消費電力も下がっているので、何らかの理由で仕事が上手く回っていなかった事を示唆している(βドライバーゆえだろうか?)。ただ、4Kになるとメモリー帯域の太さが効きだし、消費電力増とともにフレームレートもよく絞り出せるようになる……こんな所だろうか。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります