NVIDIA、テキストから4D画像を生成する技術 ゲーム等への応用に期待

2023年12月22日 17時30分更新

NVIDIAの研究機関Toronto AI Labは12月21日(現地時間)、テキストから動的な4D(3次元+時間)アニメーションを生成する技術「Align Your Gaussians(以下AYG)」を発表した。

Nvidia just announced Align Your Gaussians

— AK (@_akhaliq) December 21, 2023

Text-to-4D with Dynamic 3D Gaussians and Composed Diffusion Models pic.twitter.com/osgfjqKmtO

3Dガウス分布情報から3D画像を生成

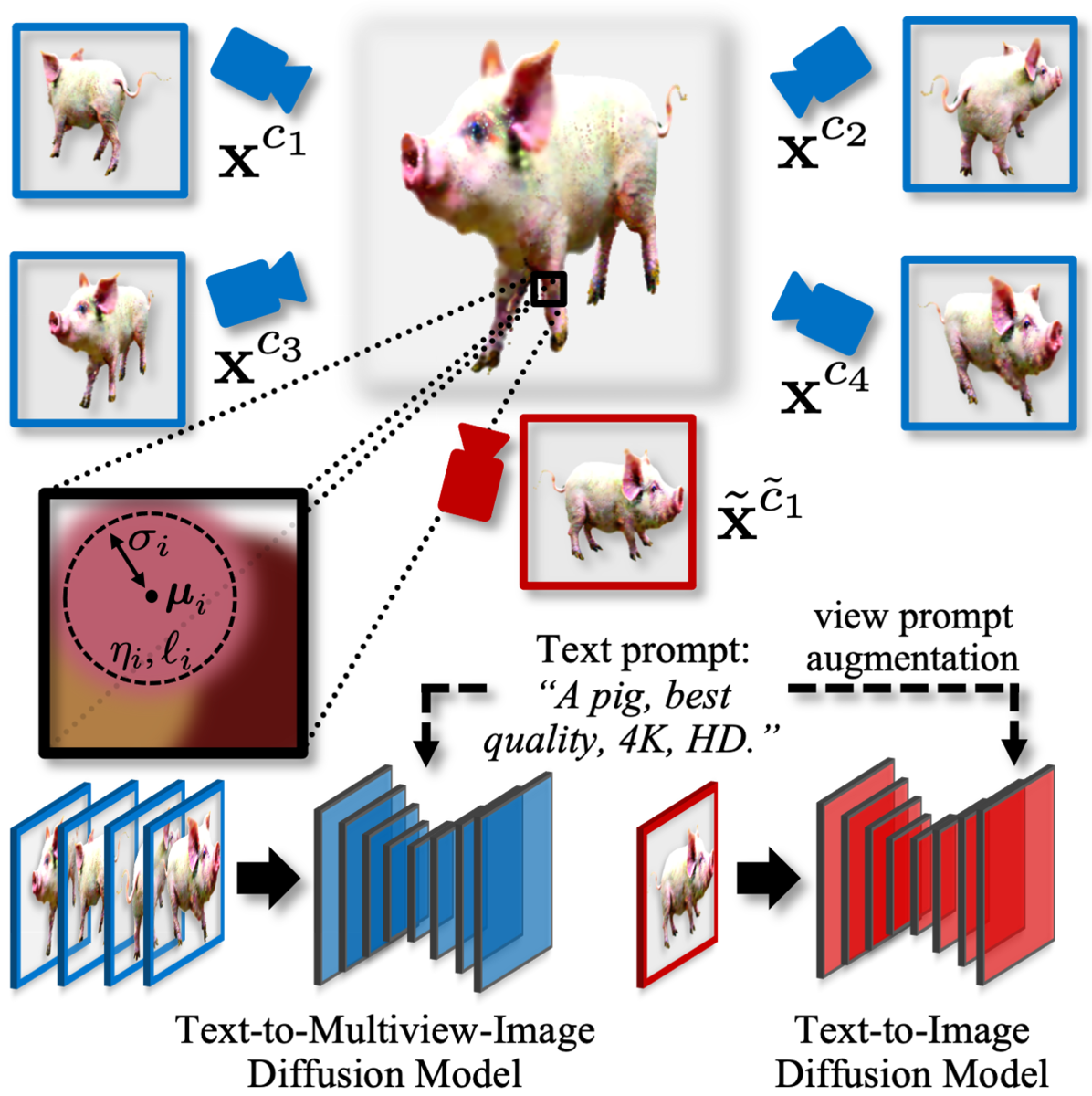

初期の3Dステージでは、最適化された3Dガウス分布(3次元空間内でデータの分布をモデル化するための統計手法)を使用し、「Stable Diffusion(Txt 2 Img)」と「MVDream(Txt 2 Multiview-Image)」の2つのモデルを活用し、3D画像(静止画)を生成する。

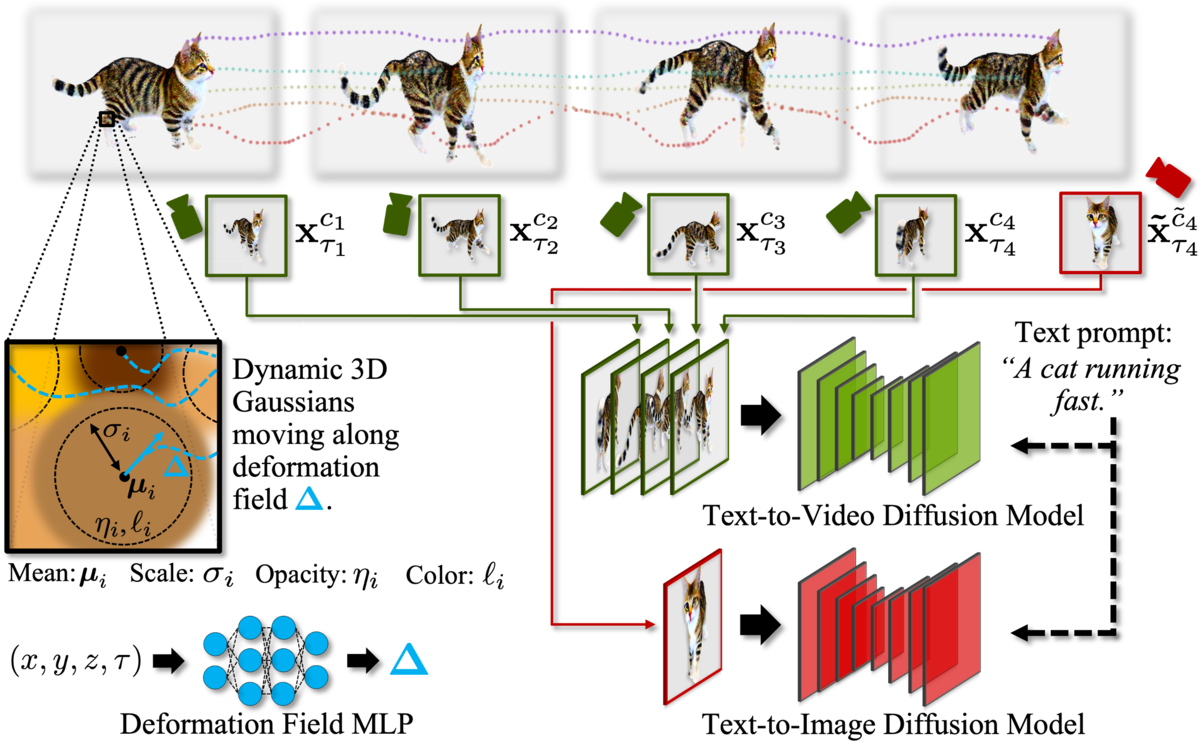

時間的ダイナミクスを追加

次の4D合成ステージでは、前ステージで生成された3D画像を元に変形フィールドを最適化することで時間的ダイナミクスを生成し、それによって動いて変形するダイナミック4Dアセットを生成するという。

使いやすい4Dアセットを大量生産

完成した4D動画は完全にループしており、固定カメラ・移動カメラの2種類の視点でレンダリングされる。

テキストプロンプトを変更することによって、同じキャラクターに別の動きをとらせることも可能だ。

このように大きなシーンで複数の合成されたダイナミックな4Dアセットを動かすことも簡単にできるという。

NVIDIAは論文で「この技術がアニメーション、シミュレーション、デジタルコンテンツ制作、合成データ生成などの新しい分野での応用を開くこと」を期待するとともに「動的4Dシーンを正確なトラッキングラベルと共に生成する技術は合成データ生成において重要なものになる可能性がある」としている。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります