動画生成AI、中国勢強すぎでは? TikTokのバイトダンス等がまたすごいの出してきた

2023年12月05日 12時10分更新

TikTokの運営会社バイトダンスおよびシンガポール国立大学からなる研究グループは12月4日(現地時間)、拡散(Diffusion)モデルを使用し、1枚の静止画像とモーションシーケンス(動きを指定するガイド)を元に、TikTokに投稿されているような人間のダンス動画を生成する「MagicAnimate」を発表、ソースコードを公開した。

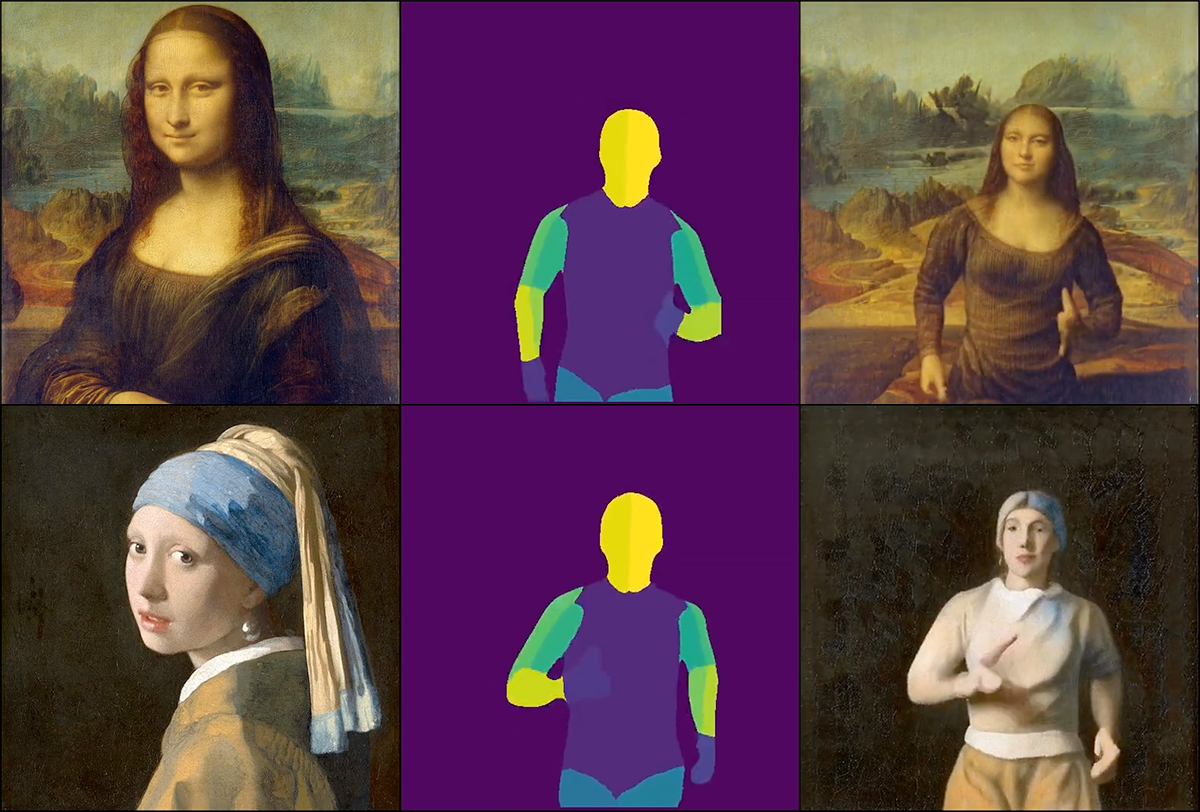

モナリザを踊らせることも可能

MagicAnimate: Temporally Consistent Human Image Animation using Diffusion Model with @Gradio demo

— AK (@_akhaliq) December 4, 2023

local demo: https://t.co/ScsEU6oG64

This paper studies the human image animation task, which aims to generate a video of a certain reference identity following a particular motion… pic.twitter.com/JCOr0yCRZs

静止画像を元に動画を作成する技術は、SNS、映画、エンターテイメントなど様々な分野で注目されており、毎日のように新しい技術が発表されている。

MagicAnimateは、時間情報を符号化するためのビデオ拡散モデルと、フレーム間の外観の一貫性を維持するための新しい外観エンコーダを導入することで、従来の技術が苦手としている、時間的一貫性の向上、参照画像の忠実な保存、アニメーションの忠実度の向上を実現したという。

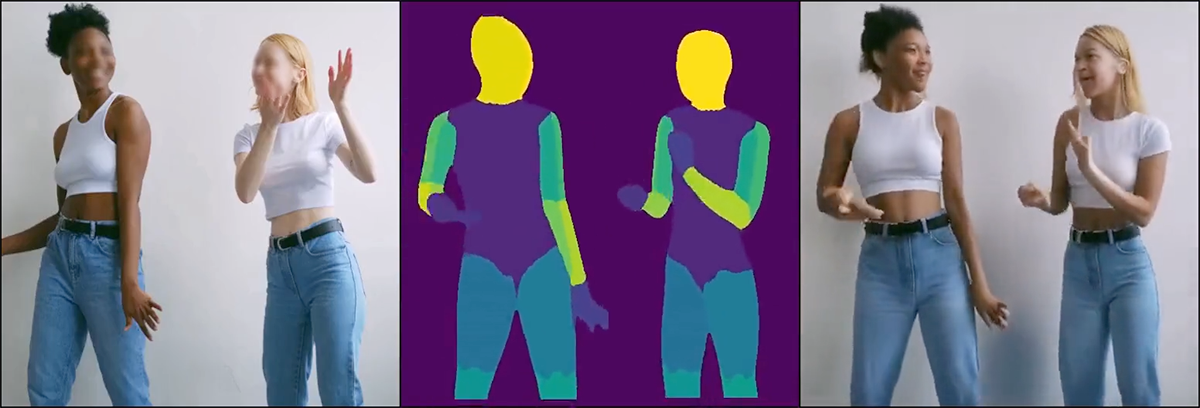

また、1枚の静止画像とモーションシーケンスから動画を作成できるだけではなく、別の動画からキャプチャーした画像を元に作成(クロスアイデンティティアニメーション)したり、複数人を含む画像のアニメーション化(マルチパーソンアニメーション)も可能だ。

特筆すべきはすでにGitHubにてオープンソース(BSD 3-Clause License)でソースコードとモデルが公開されているところだ。

同様の技術にアリババが発表した「Animate Anyone」があるが、こちらはまだデモサイトの公開のみとなっている。

架空のキャラクターや過去の偉人がTikTok上で踊り出す日も近そうだ。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります