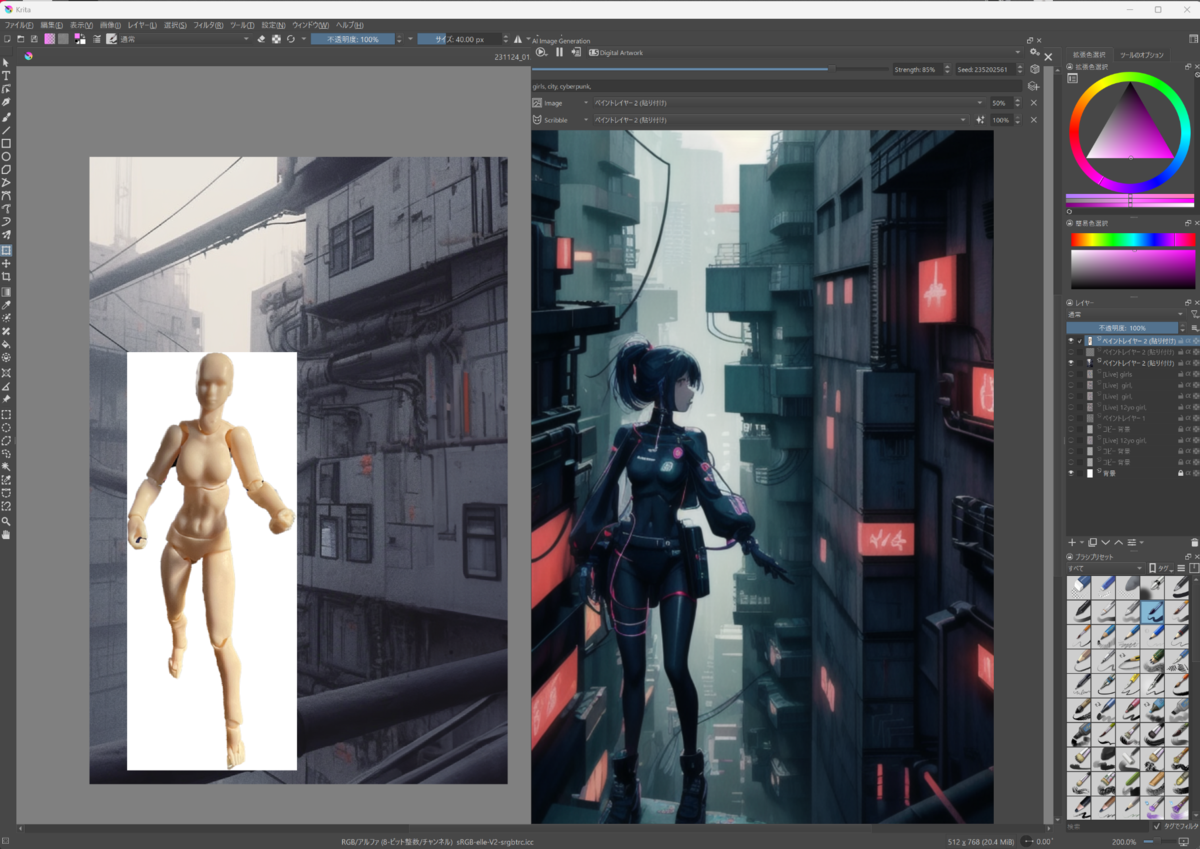

ラフを描いていくだけで「それっぽい絵」が生成されていく

たとえば、何を描こうとしているのかを「girl」などとプロンプトで指定しておきますよね。そして、画面に絵を描いていくと、一瞬一瞬で絵ができあがっていくんです。完成された絵の変化を見ながら、ラフの作成を続けていくと、それっぽい絵ができてしまう。

0~100%まででパラメーター設定ができるので、数値を上げていくと、プロンプトの影響度が高まった絵になっていきます。ラフを着彩しても生成画像は変化していきますし、プロンプトで指定すればキャラクターにメガネを加えたりもできてしまいます。

Stable Diffusionで使うチェックポイント(モデル)やLoRAも指定できるため、リアル系のキャラにしたければ、リアル系のチェックポイントを追加するだけ。アニメ系のチェックポイントを指定すれば、アニメ系になります。

▲実写風(筆者作成)

▲アニメ風(筆者作成)

これまでのStable Diffusionでは、プロンプトの効果を確認するためには、その都度出力してプロンプトをどれくらいの強さで反映するのかをいちいち生成して把握するしかありませんでした。ところが、生成がリアルタイムになると、プロンプトがどういう効き方をしているかをリアルに体感できるようになるんですね。

Generative AI for Kritaには線画を抽出できる「ControlNet」の機能が組み込まれており、これがまだ他のリアルタイムLCMを搭載したアプリにはない優位性になっています。

そのため、最初から絵を描かなくても、たとえばデッサン人形の写真を読み込ませても、イラストが生成されて、プロンプトを変えればたちどころに反映されていきます。そこで生成されたイラストを保存し、さらに手を入れて、別の絵に仕上げていくこともできます。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります