第43回

世界トップ級の画像生成AI「Midjourney」更に強力に。ライバル「Stable Diffusion」との違いもはっきり

2023年11月20日 07時00分更新

11月2日、画像生成AI「Midjourney」に新機能「スタイルチューナー(Style Tuner)」が追加されました。この機能で、ユーザー独自の画風を作成して登録して活用できます。競合するAI「Stable Diffusion」の「LoRA」と類似した機能ですが、より手軽に扱えるよう工夫されています。

使用方法は簡単です。MidjourneyはDiscordでチャットボットとやり取りしながら命令を打ち込む方式なので、まずは「tune/」というコマンドとプロンプトを入力します。すると16枚、32枚、64枚、128枚の4種から、ベースとなるスタイル(画風)を何枚生成するかを聞かれます。仮に32枚を選択すると、「0.3 fast hours GPU credits(0.3のファスト時間のGPUクレジット)」と、通常の画像生成に比べて、余計な計算コストが必要になるということが告知されます。それを承諾すると、スタイルを一覧化したリストが約2分で作成され、専用リンクで表示します。

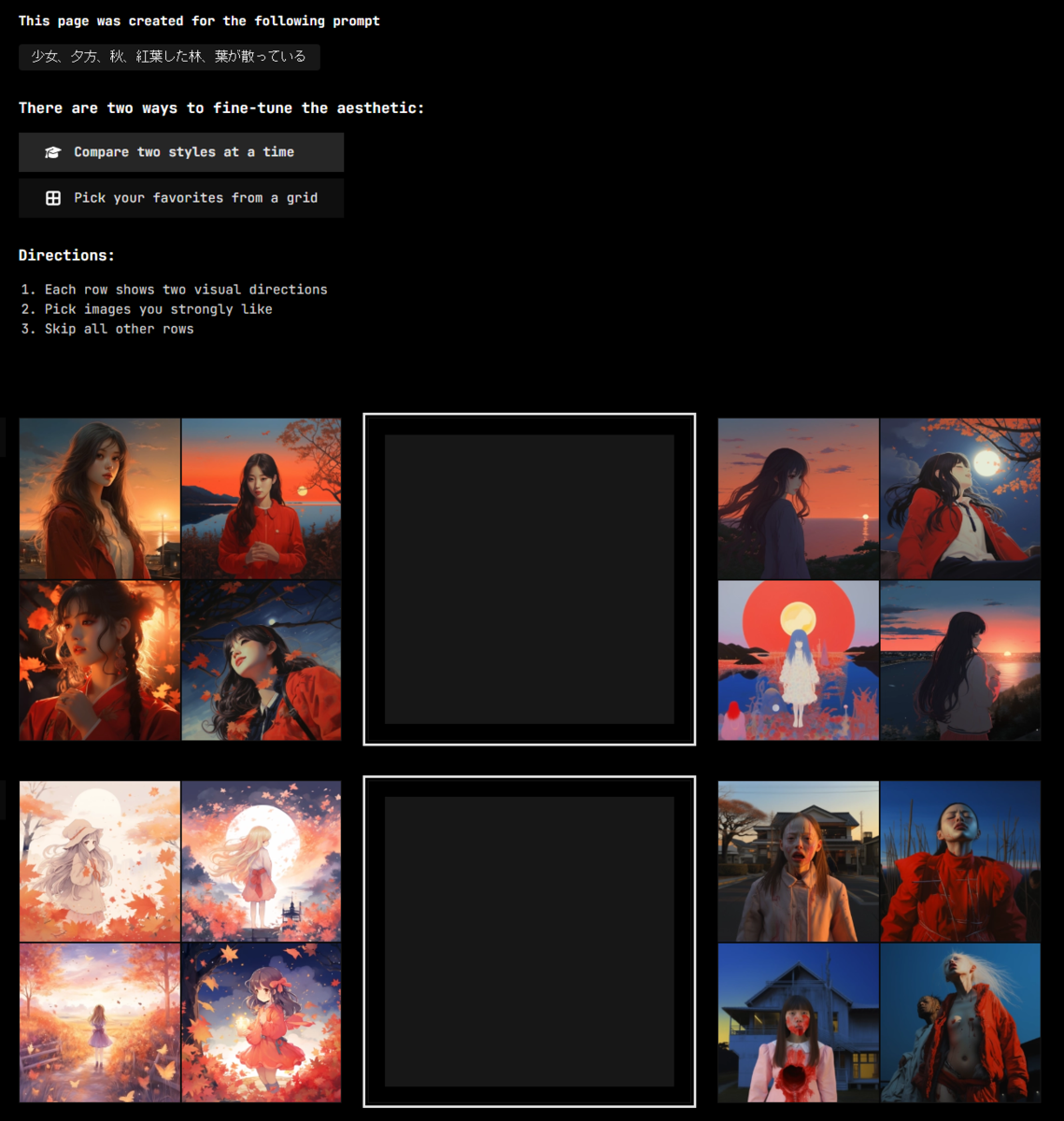

リンク先に飛ぶと、プロンプトに応じて作られた32枚の多様なスタイルの一覧が、16のペアとして表示されるので、ユーザーは自分の表現形式に近いと思われる画像を選んでいきます。16のペアのうち、気に入ったスタイルを2択から選ぶことで、そのスタイルが生成できるようになるわけです。複数のスタイルが選ばれた場合は、そのスタイルの特徴が混ぜられて、独自のスタイルが生み出されることになります。

試しに最初の2枚を選択してみました。すると画面の下方に、そのスタイルの反映を受けた「コード」が文字列として生成されます。この画面では「bDqWY7Jt」というコードになりました。スタイルを選択するたび、コードは新しいものに切り替わっていきます。

このスタイルを使って画像を生成してみると、以下のような形になりました。

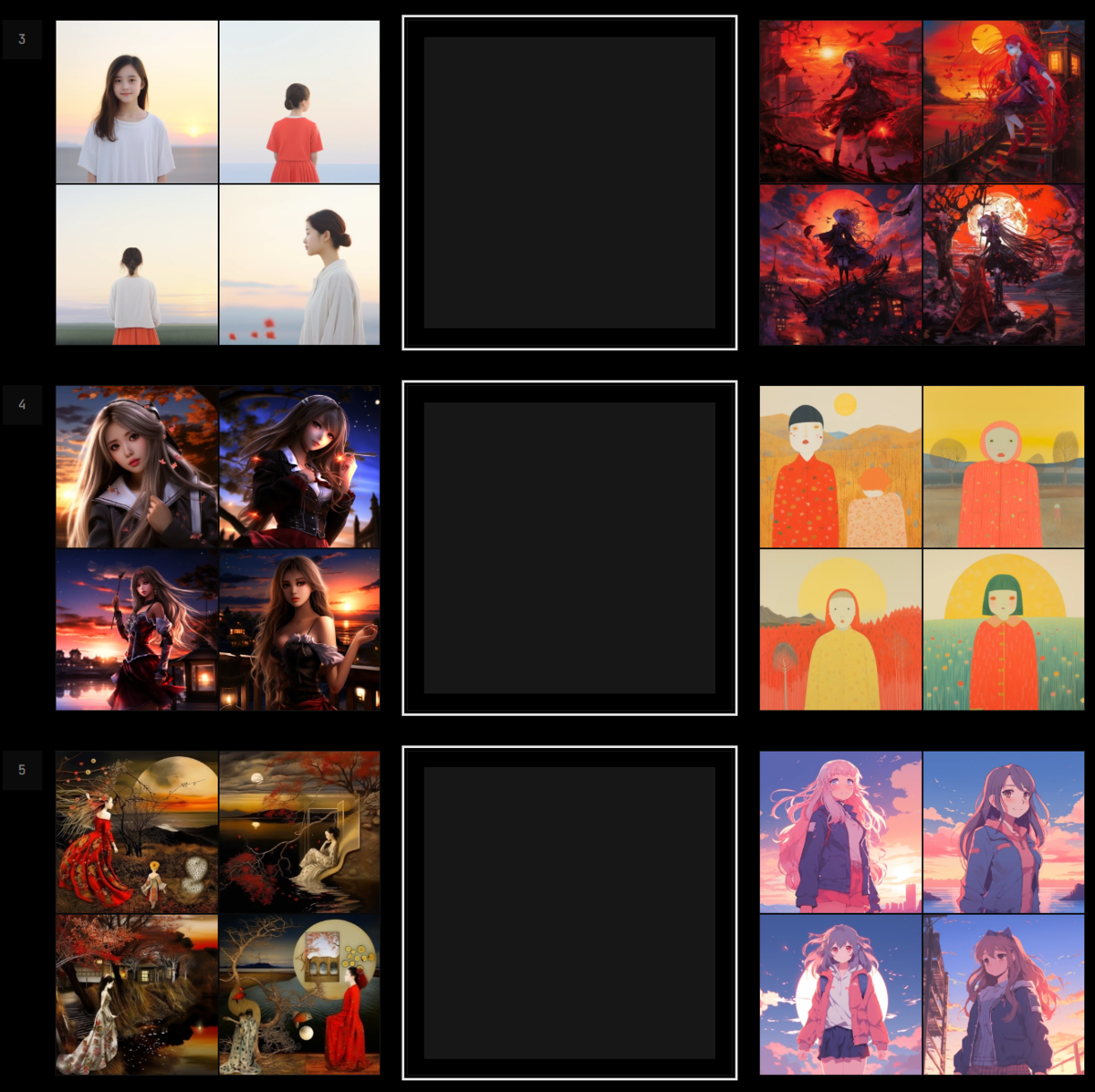

16の選択肢をすべて選んだ状態、様々な画風が混ぜられ、全体の平均のような画像が出ている。プロンプト「少女、夕方、秋、紅葉した林、葉が散っている --style btUOyMphKD7YyIzB --ar 16:9 --s 250」

一度生成したスタイルコード「btUOyMphKD7YyIzB」は自由に使えます。別のプロンプトを使っても、このスタイルを適応した画像が再現できるようになるというわけです。

画像生成AIにおけるスタイルの作成は、Stable Diffusionの追加学習の仕組みである「LoRA」がよく知られています。LoRAは自分で30~50枚の画像を用意し、その画像データを使ってスタイルのデータを作り出すというやり方を取るのが普通でした。

一方のMidjourneyは、自分たちが大量に持っている学習済みデータに抱え込んでいるスタイルを基準に、ユーザーが選択したり、掛け合わせることで独自スタイルを構築するという方法論を選択したようです。Midjourneyは画像から画像を生み出す「image2image」も直接的にはできない仕組みになっており、そっくりの画像が生まれたりしないよう配慮しているようにも見えます。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります