このところ画像生成AI界隈で話題になっているのが、「Latent Consistency Models(レイテント・コンシステンシー・モデル」(以下「LCM」)。10月6日に中国精華大学のシミアン・ルオさんが中心となって発表された論文で、日本語にすると「拡散的一貫性モデル」。新しいタイプの効率性の高い生成モデルを使い、Stable Diffusion=安定拡散モデルより高速に画像を生成。結果としてビデオメモリーの少ないローレベルのPCでも画像生成AIを動かせるようにしようというものです。

0.5秒で4枚出力。Stable Diffusionの5倍

Stable Diffusionの拡散モデルは、ランダムなノイズ情報から、学習済みの特徴点データを利用することで、段々と画像を生み出していくサンプリングプロセスを繰り返します。それによって画像を生成する仕組みです。通常、1枚の画像を生み出すのに必要なサンプリングプロセスは約20~30回。1回ずつの計算に時間がかかるため、1枚あたりの生成にも時間がかかり、性能の高いハイエンドPCが必要でした。

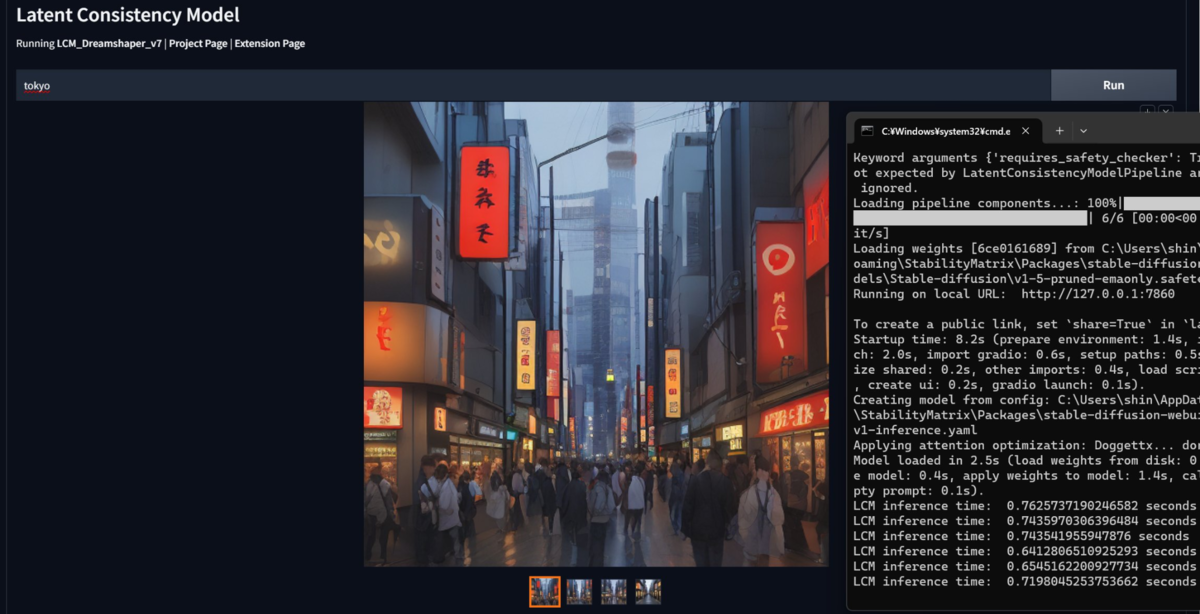

これに対してLCMは、ランダムノイズの状態から1ステップで画像を生成することで、劇的な高速化をはかっています。さらに2~4ステップを追加すれば、画像の品質も引き上げられます。Stable Diffusionのやり方だと、1ステップ目はまだノイズが多く残っている状態で、どのような画像が成立しようとしているのかわかりませんが、LCMでは1ステップだけで明確な画像が生み出されてくるわけです。

LCMを使って、生成した画像のステップごとの違い。1ステップもかなり具体的な像が姿を表しているが、4ステップではかなりしっかりとした画像になっているのがわかる(画像は公式サイト「Latent Consistency Models」より)

Stable Diffusion v1.5のベースモデルで、1ステップ、2ステップ、4ステップ、10ステップ、20ステップと同じ条件で作成したサンプル。4ステップ目でもまだ画像が形になっていない(筆者作成)

LCMはこれまでのモデルと異なる方法で処理されているため、Stable Diffusion向けに作成された学習モデルとの互換性がありません。そのため使用するにはLCM専用の学習済みモデルを作成する必要があります。LCM用のアルゴリズムに合わせて既存の学習済みモデルを利用して新しいモデルを生み出したり(「蒸溜」と呼ばれます)、最初から新しく専用に作る必要があります。

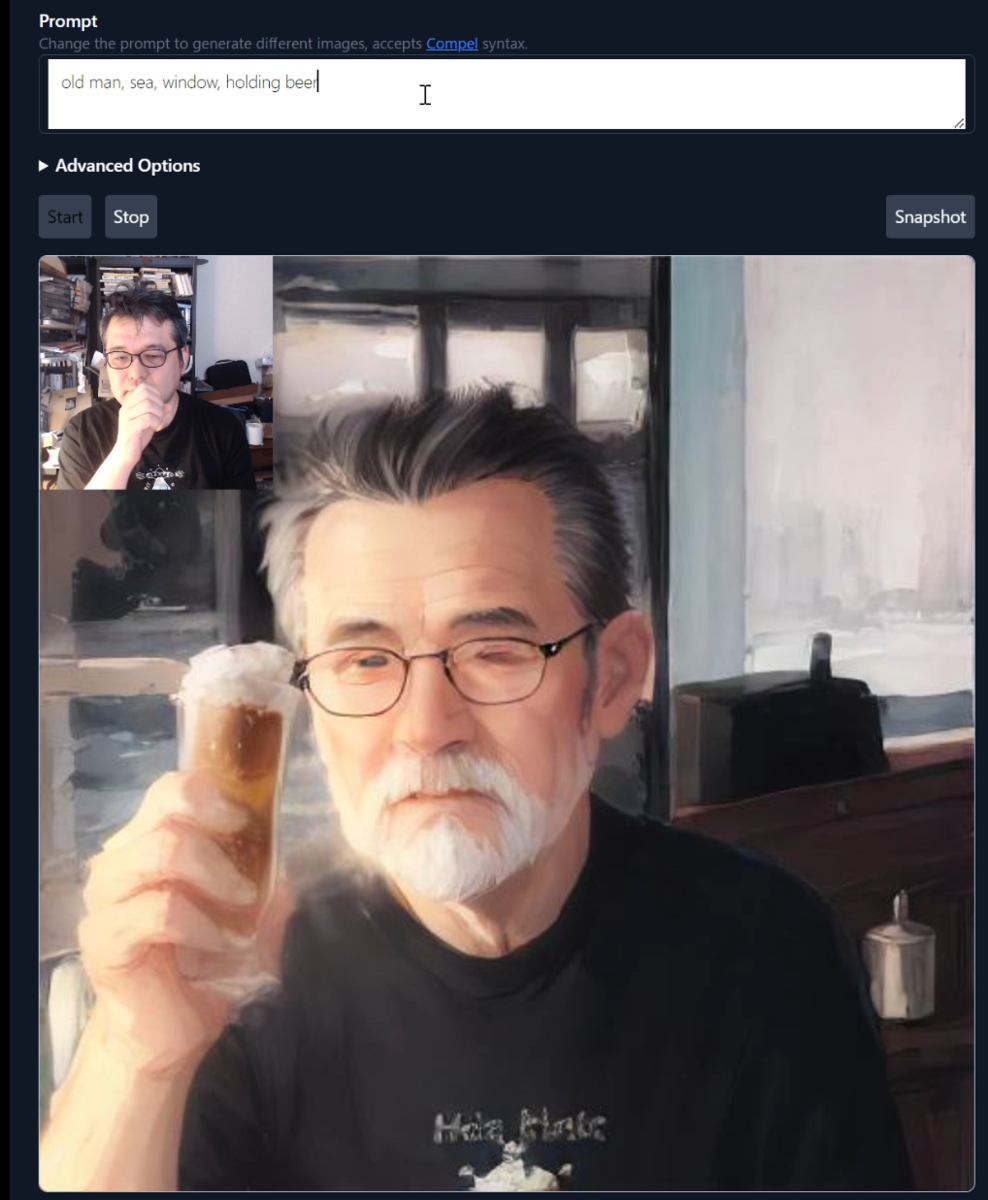

ただし、論文発表に合わせて、LCM専用モデル「LCM_Dreamshaper_v7」がサンプルモデルとして公開されています。AUTOMATIC1111 WebUIで動作させるための拡張機能「Latent Consistency Models for Stable Diffusion WebUI」も公開されているため、こちらで試すことができます(※ただし11月10日現在、拡張機能はエラーで正しく動作しない状態です。近くアップデートされると思われます)。

そこで実際にPCのローカル環境で動かしてみるとその驚異的な性能がわかりました。

NVIDIA GeForce RTX 4090の環境で「tokyo」と簡単なプロンプトを書き、512×512ピクセルの画像をステップ「20」の設定で4枚生成したところ、生成にかかった時間はわずか約0.7秒、1秒未満でした。もはや「Run」ボタンを押した瞬間に4枚が出てくるような感覚です。同じ設定で、Stable Diffusion V1.5で生成すると4枚で3.8秒程度。LCMの方が約5倍も速いことになります。これは単純に、デフォルトのステップ数が5分の1になっているため、それだけ速くなっていると考えられます。

StableDiffusionとは違って、ControlNetなどはまだ使えませんが、高速化の流れが見えます。しかも、ちゃんとした画像がこの速度で出てくるのが驚きです。今後は、画像から画像を生成するimage2imageや、ビデオから画像を生成するVideo2Videoに対応することもアナウンスされており、生成速度の圧倒的な速さは特に動画領域での利用が期待されています。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります