グーグル、翻訳したテキストと音声を同時に生成する大規模言語モデル「AudioPaLM」発表

2023年06月26日 18時05分更新

グーグルは6月22日(現地時間)、音声認識と音声生成を目的とする大規模言語モデル(LLM)「AudioPaLM」を発表、デモページを公開した。

2つの既存LLMを統合

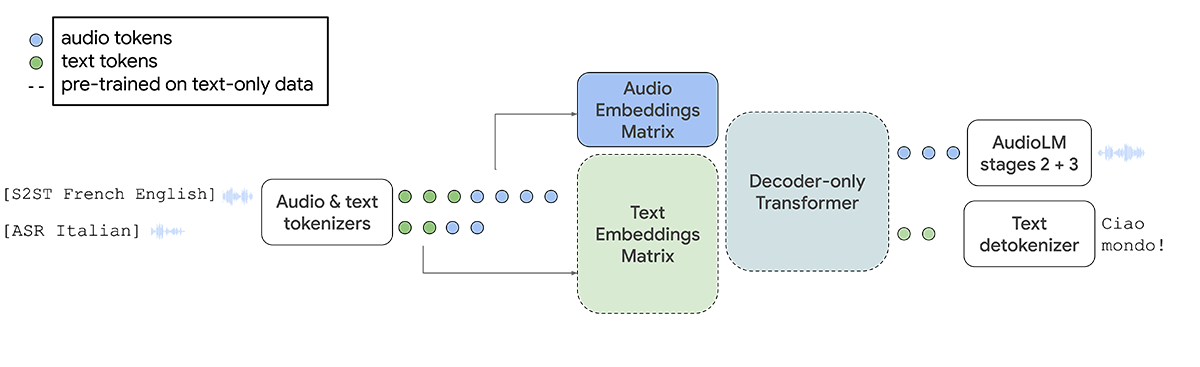

AudioPaLMはテキストベースのLLM「PaLM-2」と、音声ベースのLLM「AudioLM」を統合したマルチモーダルアーキテクチャを採用。

音声を入力すると、声色やイントネーションといったパラ言語情報を抽出し保持できるAudioLMの機能と、複数の言語で構成された大量のデータセットで学習したPaLM-2の言語知識を活かし、テキストと音声を単一のモデルで処理・生成することが可能。

具体的には事前に学習されたテキスト専用モデル(破線)を音声データも処理できるように拡張することで、テキストだけではなく音声トークンも生成し、後段のAudioLMステージで生の音声に変換されるようになっている。

その結果、音声翻訳タスクにおいて既存のシステムを大幅に上回り、テキストでしか学習していなかった多くの言語に対して、ゼロショット(初見)の音声テキスト翻訳が可能になったという。

また、短い音声データを元に、話者の声を別の言語に変換することもできる。この機能が進化すれば、音声チャットなどで発言する際、その声のトーンや抑揚を保ったまま別の言語に変換することが可能になるのだ。

現時点で日本語はまだ微妙

デモページには、外国語の音声データを入力すると、入力されたデータと同じ話者、イントネーションで英語に翻訳された音声データが生成される「Speech-to-speech translation」、外国語の音声データを入力すると英語に翻訳されたテキストが生成される「Speech-to-text translation」、そして外国語の音声データを音声認識して文字起こしする「ASR(自動音声認識)」の3パターンのデモが公開されている。

言語によって学習データ量に大きく差があるため、リソースの多い言語(フランス語、ドイツ語、カタルーニャ語、スペイン語)、標準的な言語(ペルシャ語、イタリア語、ロシア語、中国語、ポルトガル語)、少ない言語(オランダ語、トルコ語、エストニア語、モンゴル語、アラビア語、ラトビア語、スロベニア語、スウェーデン語、ウェールズ語、日本語、タミール語、インドネシア語)に分類されている。

リソースの多い言語、たとえばフランス語のデモでは、まるで本人がフランス語なまりの英語を話しているような自然な音声が出力されていた。一方、リソースの少ない言語に分類されている日本語はあまりできがよくなかった。これはリソースの量もだが、学習データの質(実際サンプルの日本語音声データには明らかに非ネイティブ話者のデータが混じっていた)も関係しているように感じた。

その人の国籍・使う言語に関係なく自由に音声コミュニケーションができる未来はすぐ側まで来ている。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります