iPhoneで視覚・発話障がいユーザーをサポート! 新「アクセシビリティ機能」をアップルが発表

2023年05月18日 07時30分更新

初の発話アクセシビリティ機能を追加

続いてアクセシビリティには初めて加わる、発話障がいを持つユーザーのコミュニケーションをサポートする2つの新機能に注目します。

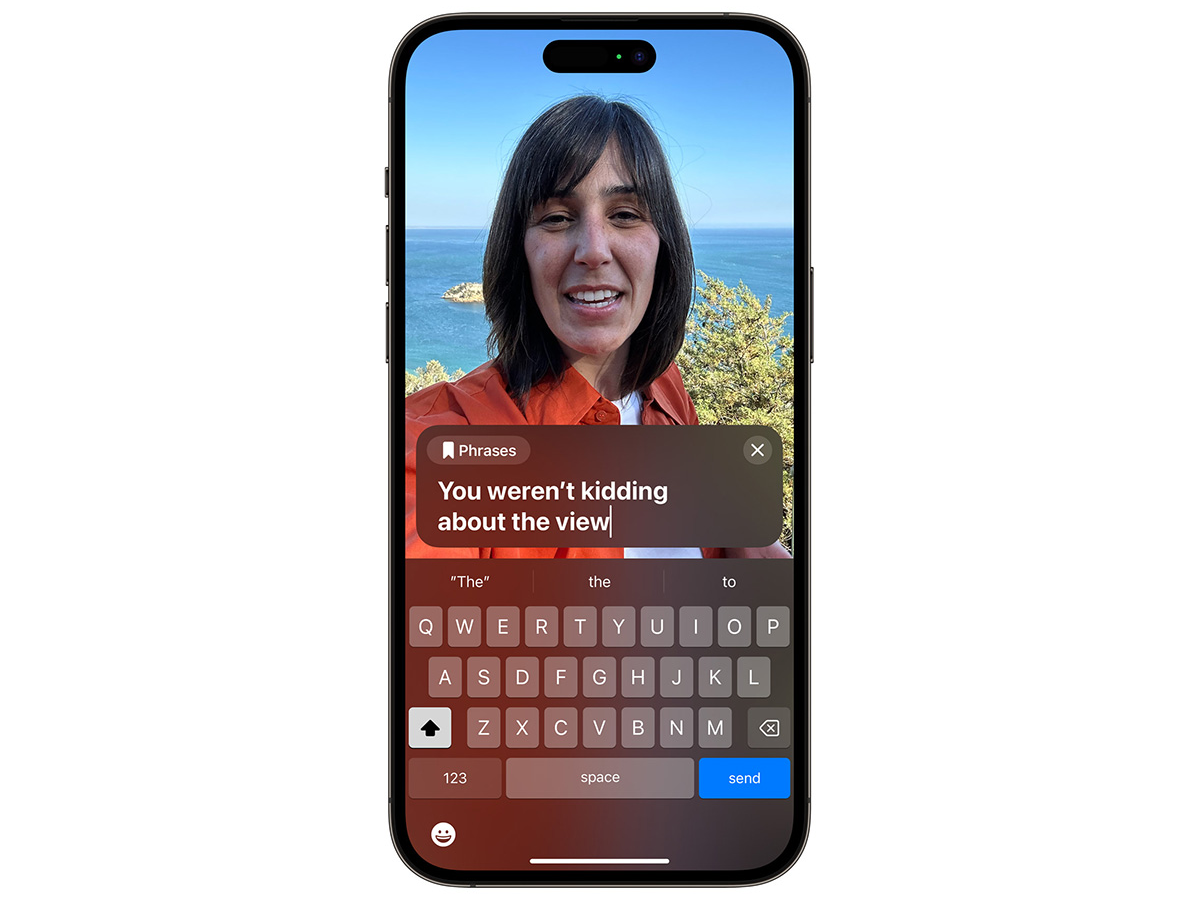

ひとつは電話またはFaceTime通話、対面での会話中にユーザーが話したいことをタイピングすると、機械音声が読み上げてくれる「Live Speech」です。iPhone/iPad/Macなど様々なデバイスに対応します。頻繁に使うフレーズを登録して、素速く呼び出せる機能も付いてきます。

もうひとつが「Personal Voice」という、自分の声をベースとした機械音声を作成してLive Speechとして使える機能です。ALS(筋萎縮性側索硬化症)など、徐々に発話能力に影響が及ぶ可能性のある病気と診断されたユーザーがPersonal Voiceを登録しておけば、発話能力を失った後もiPhoneなどのデバイスを使って、自分が話しているように聞こえる声でコミュニケーションを交わせます。

Personal Voiceは米国でALS患者を支援する団体、Team Gleasonとアップルが共同開発によりつくった機能です。通常、一般の方が自分の声を元にした合成音声の制作を依頼すると費用が高額になり、手間も発生します。Personal VoiceはiPhone/iPad、Appleシリコンを搭載するMacなどのデバイスだけで、本人の声に近い高精度な合成音声が作れるところに魅力があります。なお、Personal Voiceは当初英語から提供がスタートします。

テキストラベルを読み上げる「Point and Speak」

最後に、視覚障がいを持つ方のためアクセシビリティに追加される機能を紹介します。

アップルはiOS 16からアクセシビリティの拡大鏡の「検出モード」に「ドアの検出」機能を追加しました。ロービジョンのユーザーがiPhoneのカメラを使いながら、ドアのある場所を安全に移動できるように開発された機能です。

今年は拡大鏡に「Point and Speak」の機能が加わります。VoiceOverと連携して、iPhoneのカメラを向けた対象のテキストラベルを音声で読み上げてくれます。

Point and SpeakはLiDARスキャナを搭載するiPhoneとiPadに対応しています。言語は日本語を含む11の言語をサポートしています。

アクセシビリティに関連する大きな発表はWWDCにも続いている?

アップルがiPhoneやMacを使うユーザーのために拡充してきたアクセシビリティ機能の全貌は、同社の特設サイトに全貌が詳しく紹介されています。

プレスリリースで発表されたアクセシビリティの新機能はその数が多いだけでなく、内容も多岐に渡っています。今年、アップルがデバイスのアクセシビリティ強化にますます本腰を入れて取り組む意気込みが伝わってきます。

今年はアップルのWWDC(世界開発者会議)が6月5日(日本時間6月6日 午前2:00)から米国で開催されます。イベントが近付くに連れて、アップルによる「スマートグラス」に関連するウワサも賑わってきました。情報の真偽はさておき、今回アップルが発表したアクセシビリティ機能については、本来は障がいを持つ方々がスマートグラスのような両手をフリーにしながら扱えるデバイスとより相性が良いのかもしれません。

スマートグラスと聞くと、最初にAR/VRに対応するエンターテインメントを視聴したり、メタバースとつながってコミュニケーションを楽しむためのデバイスを連想してしまいます。でも、スマートグラスの中には独自のレーザ網膜投影技術により、ロービジョンの方々の生活の質(QoL)を高めることを使命に掲げたQDレーザーの「RETISSA」シリーズや、アイウェアブランドのJINSが開発した、メガネとして装着するヘルスケアデバイスである「JINS MEME」のようなデバイスもあります。

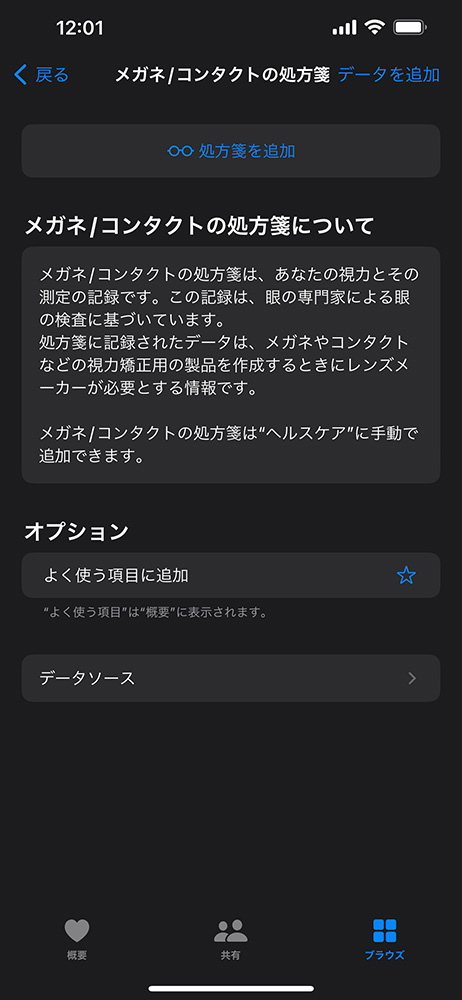

iOS 16からヘルスケアアプリのデータに「メガネ/コンタクトの処方箋」が追加できるようになりました。アップルが開発しているスマートグラスが、身に着けるユーザーの知覚能力を高めて、アクセシビリティを向上することを目的としたウェアラブルデバイスである可能性にも筆者は期待したいと思います。

筆者紹介――山本 敦

オーディオ・ビジュアル専門誌のWeb編集・記者職を経てフリーに。取材対象はITからオーディオ・ビジュアルまで、スマート・エレクトロニクスに精通する。ヘッドホン、イヤホンは毎年300機を超える新製品を体験する。国内外のスタートアップによる製品、サービスの取材、インタビューなども数多く手がける。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります