グーグルは2月8日(現地時間)、オンラインイベント「Live from Paris」を開催した。

同社は前日に大規模言語モデル「LaMDA」を活用した実験的な会話型チャットAIボット「Bard」を発表しており、その直後となるこのイベントではBardを活用した新しいGoogle検索がお披露目されるのではないかと期待を集める中、同社シニアバイスプレジデントのプラバカール・ラガヴァン氏が登壇した。

「Google翻訳」対応言語の追加や文脈検索の改善

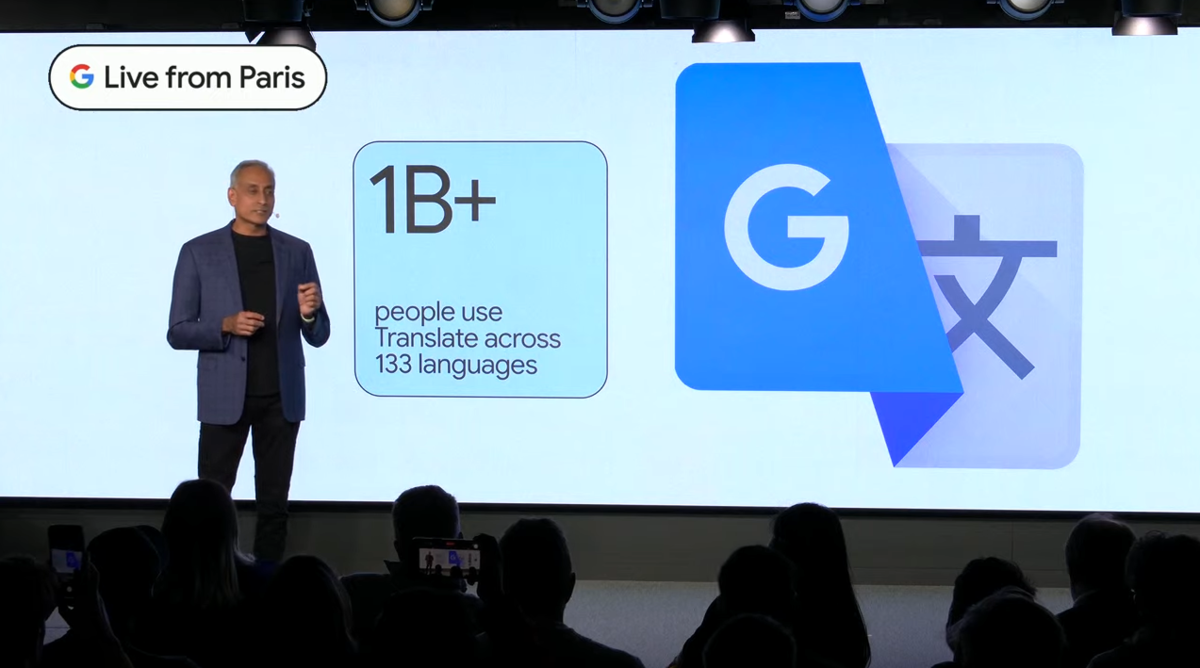

まず発表されたのはGoogle翻訳のアップデートだ。現在Google翻訳は133の言語に対応しており、世界中で10億人以上の人々が利用している。

今回新たに、インターネットにアクセスできない人でも利用できる「オフラインモード翻訳」に33の新しい言語を追加。

また、複数の意味や訳語を持つ単語をより直感的に翻訳できるよう「文脈検索」を改善した。これは今後数週間のうちにいくつかの言語から適用される。

さらに、中間言語を介さない「ゼロショット機械翻訳」を用いて、新たに24の言語が翻訳可能になった。新たに追加された言語の話者は3億人以上、これはアメリカ全土の翻訳利用者とほぼ同数となる。

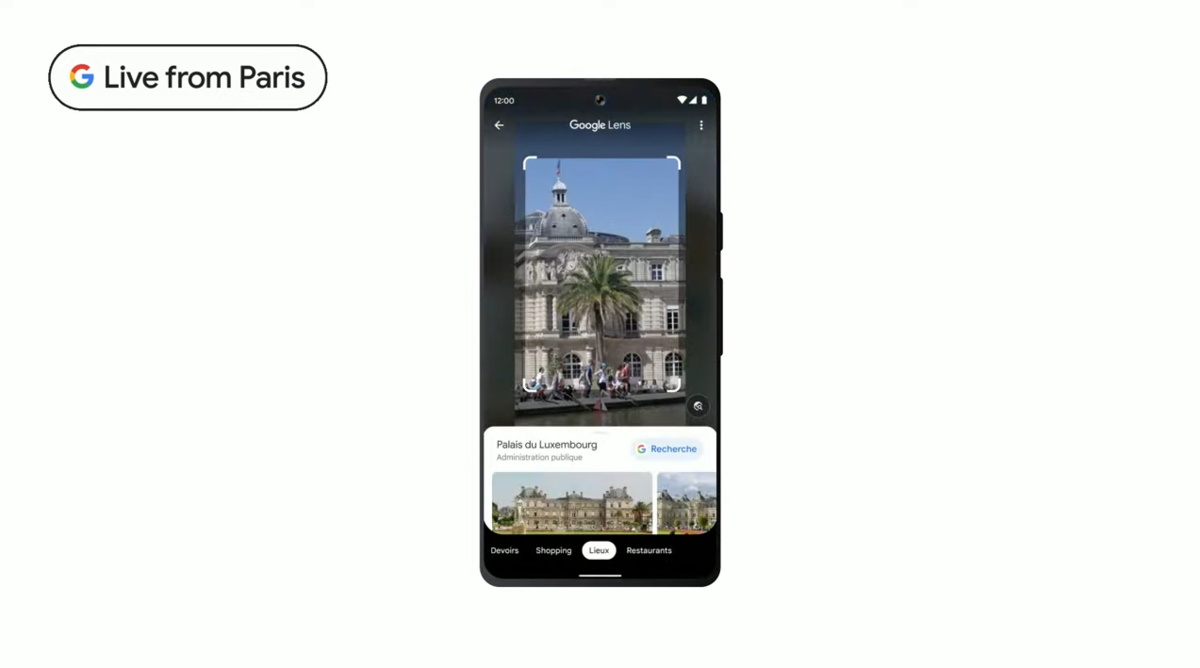

「Googleレンズ」マルチ検索に対応

次の話題は、カメラアプリから直接検索ができる「Googleレンズ」だ。月間利用回数が100億回を突破したことで、ビジュアル検索が目新しいものから普通のものへと変化しているという。

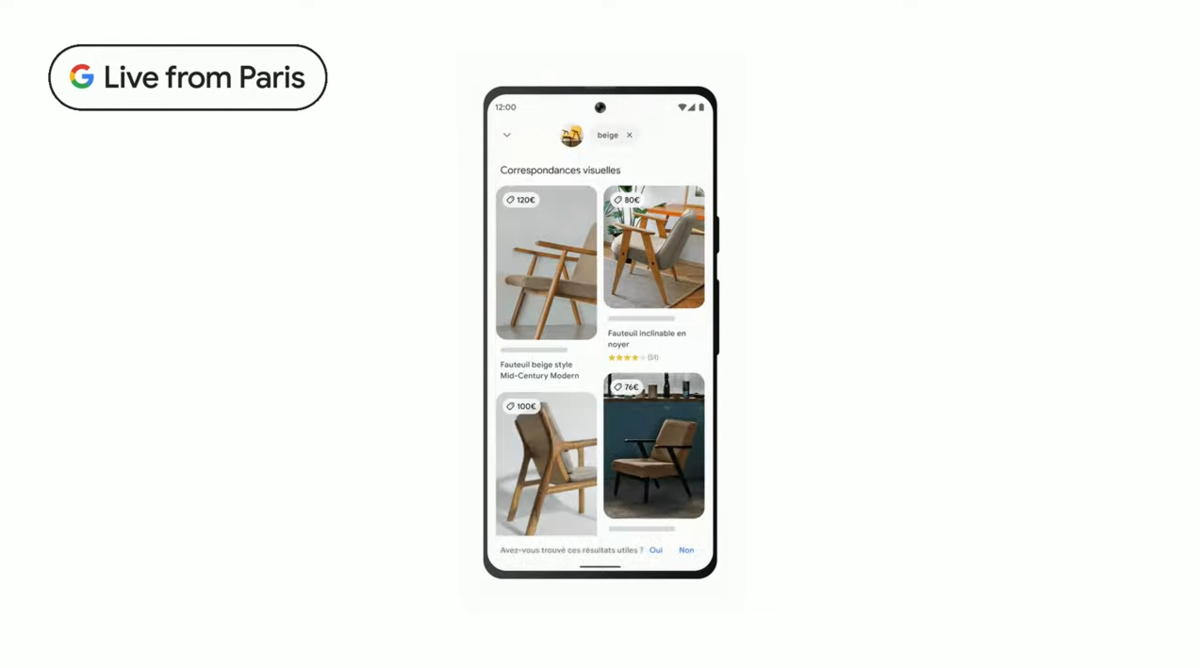

今回のアップデートでは、画像とテキストを組み合わせて検索できる新機能「マルチ検索」が発表された。

たとえば、素敵なデザインの椅子を見つけたけど、もう少し落ち着いた色がほしいとおもったときに「ベージュ」という検索ワードを加えることで、同じデザインで色違いの椅子を探すことができるのだ。

また、マルチサーチの際に「near me」という検索ワードを追加すると、近所の店舗からその商品を購入できる店舗をリストアップしてくれる機能も米国で追加された。数ヵ月かけて順次日本を含むそのほかの国々でも公開予定。

さらに、今後数ヵ月のうちにスマホ上に表示されるあらゆる画像を使ってマルチ検索ができる「画面を検索」機能を追加する。たとえば、YouTube動画を再生中に気になる商品が表示されたら、Googleアシスタントを起動し、その商品を検索することができるのだ。

ほかにも、カメラや撮影画像中のテキスト翻訳も改善されている。翻訳されたテキストを複雑な画像に溶け込ませることができるため、見た目も感覚もより自然になった。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります