1980年代以降、日本は世界をリードするロボット先進国であり続けてきた。特に主要産業である自動車や電気電子産業で用いられる産業用ロボットに関しては、世界トップクラスの出荷台数・稼働台数を誇っている。一方で、いまや世界最大の製造業大国となった中国におけるロボット産業の伸長に伴い、日本のロボット産業の世界シェアは徐々に下がってきており、より高機能・高性能なロボットの開発は急務となっている。

そのカギとなる新技術の1つ、ハプティクス(触覚技術)が注目を集めている。機械的な刺激を力や振動としてフィードバックするハプティクスは、例えば遠隔医療ロボットにおけるデリケートな患部の処理などでは必須の技術と言える。

慶應義塾大学発のベンチャーであるモーションリブ株式会社は、対象物をつかんだり触ったりしたときの反応を、対象物の物理特性に応じてフィードバックする独自の力触覚技術「リアルハプティクス」を用いたソリューションの開発を行っている。今回、同社の事業概要とその進捗を代表取締役CEOの溝口 貴弘氏から伺う機会を得た。

力触覚技術「リアルハプティクス」とは

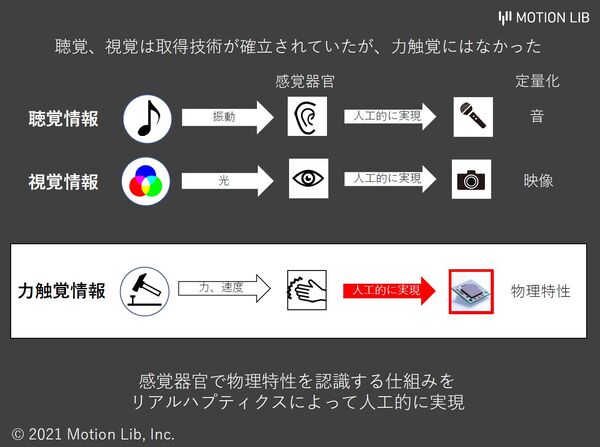

人が持つ5つの感覚のうち、聴覚と視覚については、マイクロフォンやデジタルカメラなど、その情報をデータ化する技術が確立されている。しかし物体に力を加えた時の反応である触覚についてはそれをデータ化する技術がなかった。特に、つるつるしているとかざらざらしているといった触ったときの感覚ではなく、固い/柔らかいとか、伸び縮みする、たわむなど、対象物の物理特性を含む反応を認識すること(力触覚)は非常に困難であった。

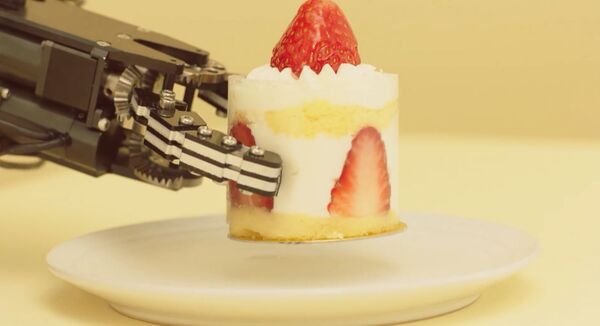

従来、(特に産業用)ロボットが扱う対象物の多くは金属やプラスチック部品など、その物理特性を深く考えずにつかんでも深刻な問題とならないものが多かった。しかし、例えば介護用ロボットなどのような生物を対象としたロボットや、ケーキや寿司など力を入れてつかむと潰れてしまう食品を扱うロボットなどでは、対象物の力触覚情報を認識して、それに応じた動きを行う必要がある。

力触覚のわかりやすい例として、溝口氏は同じ重さの重りとばねを挙げる。

「100gの重りと100gの力を出すばねがあったとする。力だけを考えた場合、目をつぶってしまうとそれらを仕分けることはできない。それらを(見ないで)仕分けるには、上下に動かしてみて、重さが変わらなければ重りだし、(伸び縮みで)変化すればばねということがわかる。つまり、位置と力、そして時間的な変化がそろって初めて力触覚を計測可能になる」(溝口氏)

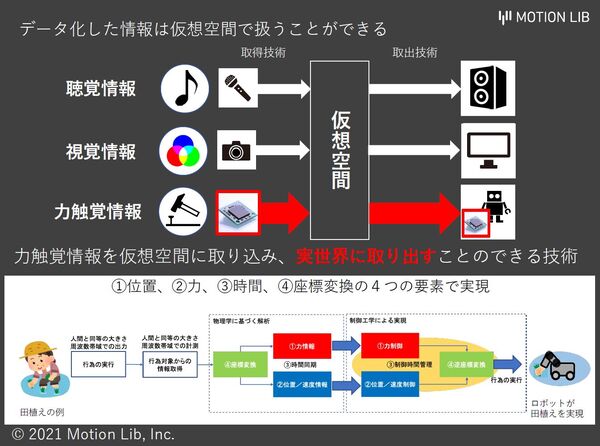

モーションリブのリアルハプティクスでは、対象から取得した情報に対して座標変換を行い、着目する座標系での力情報と位置情報に分解する。これらのデータ分析により、固いのか柔らかいのか、重いのか軽いのか、一定の力で押していくと途中で(折れる、割れるなどして)特性が変わるのかなど、対象物の特性を調べられる。また、そのようなデータに逆座標変換を行い制御することで、もともとの人の動きや物の感触を再現することも可能になる。これは、ネットワーク経由でデータを送れば、感触を伴った遠隔操作が仮想空間などでもできるようになるということだ。

週刊アスキーの最新情報を購読しよう