CES2017のDay0、つまり本開催前日は例年一日を通して1時間刻みで各社の記者会見が行われ、CES合わせで初公表になる様々な新しい取り組みのニュースに世界中から集まったプレスは話題持ちきりになる。

そのDay0の夜に行われるCESで最初の基調講演は、ほぼ毎年、CESを代表するにふさわしい”大物企業"が登壇するのが慣わしだ。折しも今年はCES開催50周年という大きな節目で、CES自体にもどこかお祭りムードがある。

2017年、その重要なスロットで登壇したのは、PC/ITの世界では古くからゲーミンググラフィックスを支えてきたGPU企業として知られ、いまや押しも押されぬ「人工知能銘柄」のど真ん中に位置する企業となったNVIDIA創業者のジェンスン・ファンCEOだ。

NVIDIAの高性能GPUはいま、人工知能開発に必須のディープラーニングの演算を高速に行なうために欠かせない計算資源として、世界中の研究機関や企業の間で争奪戦になっている。そうした背景から業績は過去最高を記録し、アメリカの経済指標のひとつS&P500企業のなかで、2016年のNo.1のパフォーマンス企業にも選ばれた。まさに時代の波にノリに乗っているというのが、いまのNVIDIAの状況だ。

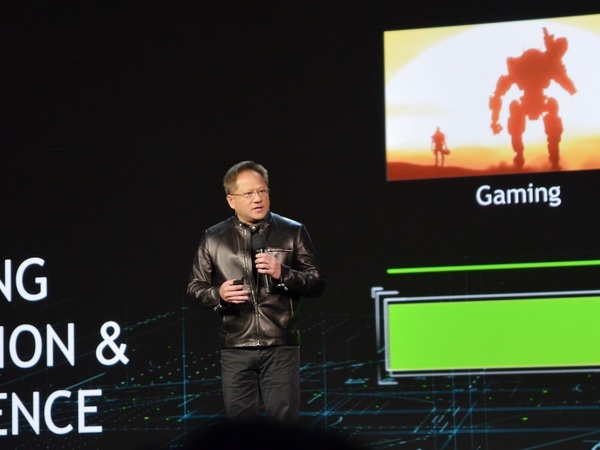

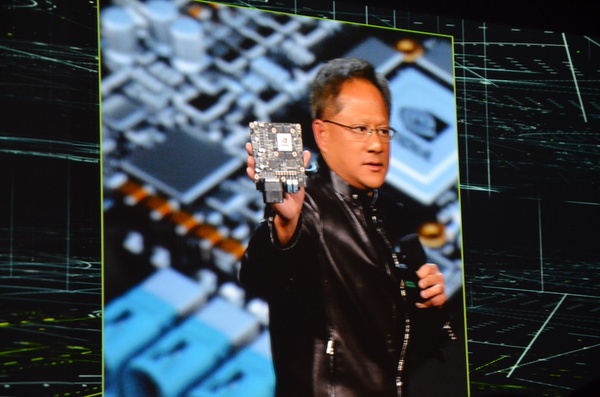

CESの主催団体CTAの代表ゲイリー・シャピロ氏の呼びかけて壇上に現れたファンCEOは、前身黒ずくめ、上半身はレザーのジャケットという、定番の出で立ち。とはいうものの、その基調講演の中で公表された多数の発表は、例年のCES以上にパワフルなものだった。

PCゲームで培った技術が、人工知能企業への躍進につながった

NVIDIAはいま、ゲーミングとVR/AR/MR、データセンター、自動運転車の4ジャンルにフォーカスしており、これらはビジュアル&AIコンピューティングというジャンルに当てはまると説明。それらすべてにおいて、GPUの性能が重要なファクターになっている。ディープラーニングが2017年現在のようにもてはやされるようになったきっかけについてファン氏はこう表現する。「ディープラーニングがGPUと出会って、AIの世界にビッグバンが起きたのです」

「AIが成し遂げた驚くべき成果」で紹介されたのは、まさにこの1-2年で起こったことだ。作るのが非常に難しいとされていた囲碁AIは人間のプロに勝つようになったし(イ・セドル九段をAlphaGoが破ったのは、信じられないことにわずか10ヵ月前だ)、写真の内容を認識してテキストで説明したり、機械の腕が自分自身で学んでモノのつかみ方を覚えたりといったことは、既に特に新しい発見ですらなく、AI分野を語る際の前提知識になっている。

さて、ファン氏のトークは基本的に以下の写真の順序で進んでいった。

まずゲーミングについて。NVIDIAはゲーム支援アプリ「GeForce Experience」の機能として、ゲームプレイをFacebook Liveに配信する機能の提供を開始する。これは現地時間1/5からまずβ版ユーザー向けに提供され、来週からは一般配信もされるという。

さらに、「ゲーム対応じゃなマシンを使っている10億人のPCユーザー」に向けて、クラウドゲーミング環境であるGeForce NowのPC版の提供をアナウンス。これはWindows、Macを問わず利用でき、早期アクセスユーザー向けに2017年3月からリリースする。料金体型は、20時間のゲームプレイあたり25ドル。

ゲーミングの最後は新型「NVIDIA SHIELD」の発表で、2017年のトレンドである4K HDR表示をサポート。PCから4KでのゲームプレイをTV画面で楽しめるほか、アメリカではネットフリックスやAmazonVideoの4K配信もサポートする。

Googleとの提携、世界初のGoogleアシスタントTV

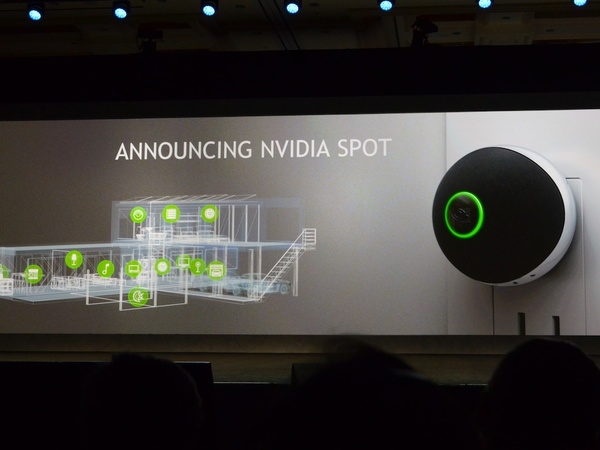

まったく新しいデバイス「NVIDIA Spot」

ゲームに直接かかわる話はここまで。以降は、AIの色が濃いテーマになっていく。

話は逸れるが、今回のCESでは自然言語入力による操作、というのが大手企業の発表の流行になっている。たとえば、LGはスマート冷蔵庫にAmazonのAlexaを組み込んで、音声入力で食材の宅配をできるようにした。レノボも、AmazonのAlexa対応のパーソナルアシスタントを発表した。

そんななか、NVIDIAが選んだ提携の相手は、Googleだ。新しいSHIELDには、音声認識としてGoogleアシスタントが採用される。NVIDIAいわく、Googleアシスタントが動くTV画面デバイスは世界初という。

これに合わせて、スマートホーム向けの新たなデバイスとして「NVIDIA Spot」を披露した。手のひらに乗る球体形状のデバイスで、これはどうやら壁や床に取り付けられるタイプの音声コントローラ(マイク)のようだ。写真では、コンセントに直接差し込めるようにも見える。 宅内に複数設置することで、どこの部屋にいても「OK, Google」でGoogleアシスタントを呼び出せるというもの。出荷時期は「近日中」。

新世代の車載向けスーパーコンピューター

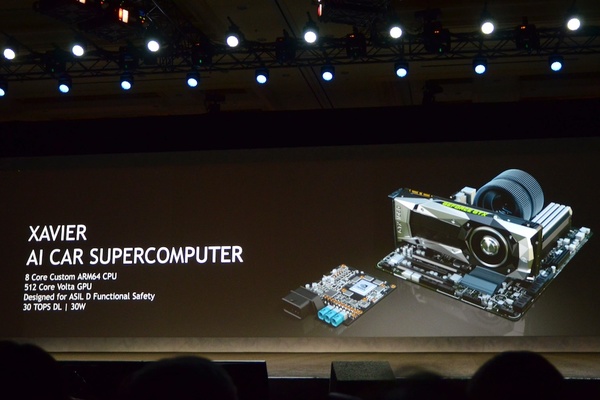

「Xavier(エグザビア)」の基板を披露

基調講演後半は、いま最もホットな自動運転車についてだ。

NVIDIAは昨年のCESで自動運転開発向けのプロトタイピング用車載スーパーコンピューター「DrivePX2」を発表した。

NVIDIAとしては、自動車そのものの制御やメーターなどのディスプレイ化によるインフォテイメントなど、操作系のIT化が進む自動車における「車内の複数の箇所に別々の仕事をするコンピューターが設置されている」という問題と、自動運転に使うであろう処理能力の高いコンピューターを、TEGRAで一元管理することを狙っている。ただし、昨年のCESで発表した当初のDrivePX2は、完全にプロトタイピングにしか使えないものだった。理由は簡単で、消費電力が250Wもあるからだ。

約4ヵ月前の2016年9月、NVIDIAは第2世代のPX2「Xavier」(エグザビア)を公表した。この実物が、基調講演で披露されたボードだ。

第1世代は250Wで24DLTOPS、第2世代のXavierは30Wで30DLTOPS。性能を損なうことなく大幅な省電力化を果たしたことで、Xavierはすでにシリコンバレーの電気自動車メーカー・テスラが今後全車種への採用を表明している。また、CES2017会期に合わせて、自動車サプライヤー大手のZFも自動運転システム「ZF Pro AI」の心臓部にPX2を採用することを公表した。

ここでファン氏は、以前から開発を進めている自動運転機能の開発車「BB8」のムービーを披露したあと、「AI助手(AI Co-Pilot)」の現在の開発状況を語った。

NVIDIAは、自動運転AIをA地点からB地点にドライバーを運んでくれるだけの存在ではなく、AIによって車の周囲の安全を常に見張ってくれ、また同時にドライバー自身の状況もモニターして、適切な提案をしてくれるものとして考えている。

NVIDIAのAI Co-Pilotの技術を使えば、たとえば、気づきにくいバイクの追い越しをカメラによる環境認識でいち早く関知し、ドライバーに知らせて安全なドライブを手助けしたり、また車内環境においても、ドライバーを顔認識することでパーソナライズしてくれたりする。

視線認識で注視しているものを察知したり、唇の動きを読心術のように認識して(Lip Reading)、ラジオやオーディオの操作、好みの曲の再生をやってくれたりといった具合だ。

こうした映像認識技術はまさにディープラーニングによる学習成果の賜で、ファン氏によればLip Readingの精度は95%あるという。

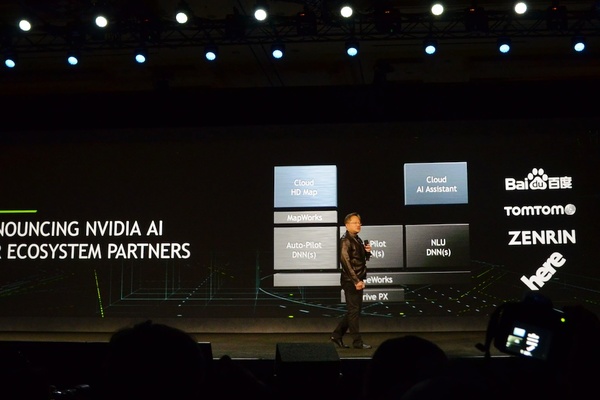

基調講演の最後は、自動運転に関する多数のパートナー発表で締めくくられた。先ほどのZFのほか同じくメガサプライヤーのボッシュ、そして新たに高精度な地図の提供で日本のゼンリンがパートナーになったことが公表された。

また、以前から提携関係にあるアウディのアメリカ法人のプレジデントも登壇し、2020年までにアウディとの共同開発をすすめ、自動運転車を市場投入する計画も明らかになった。

このように、発表内容が盛りだくさんで、最後のスライドではファン氏自ら、「もう新しいアナウンスはない(笑)」と苦笑するほどだった基調講演。

今回の発表のいくつかが、いよいよ明日からの会期本番のブースで展示されるはずだ。会期中のNVIDIA関連情報には注目しておきたい。

週刊アスキーの最新情報を購読しよう

本記事はアフィリエイトプログラムによる収益を得ている場合があります