第766回

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ

IODを貫通して直接シリコン・インターボーザーから電力を供給できる

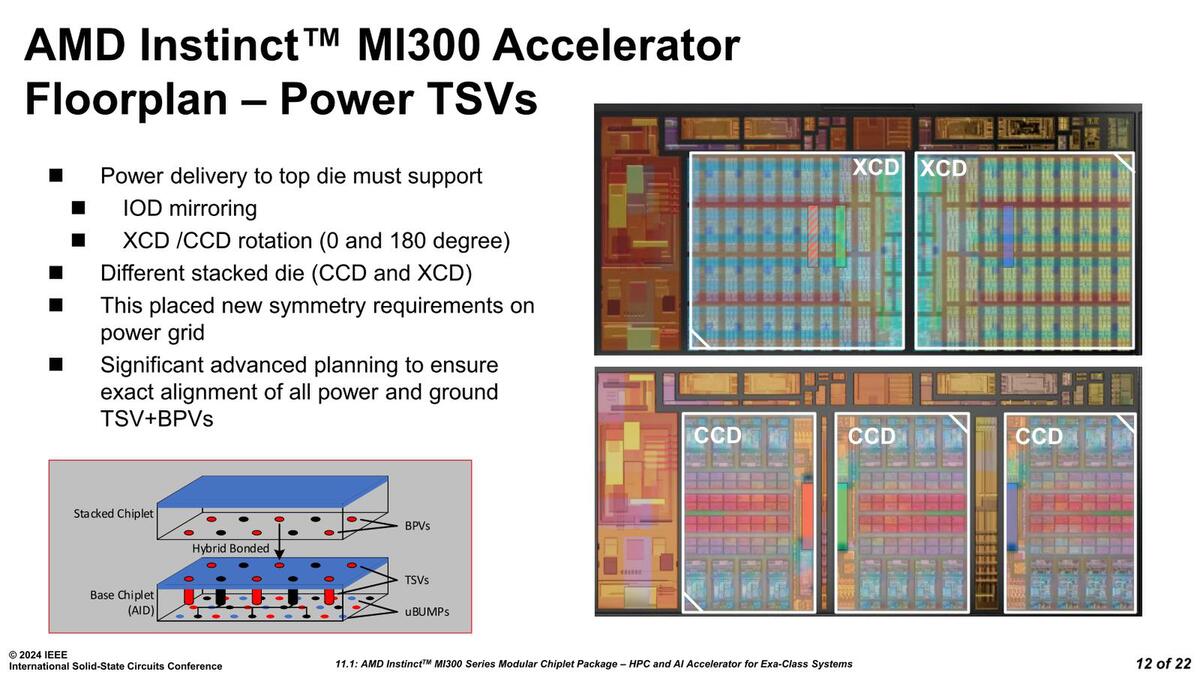

配線に関しては、信号だけでなく電力供給周りもずいぶん苦労したようだ。IODには3ヵ所に電力供給用のTSVが集中的に配置されており、XCDはこれを2+1で、CCDはそれぞれ1つづつ接続する形で配している。

もっとも2+1といっても、2つ上の画像で言えば上段左側のXCDは、この両方を使うわけではなく、片方だけを使っていると思うのだが。このPower TSVに関しては、IODを貫通して直接シリコン・インターボーザーから電力を供給できるような工夫がなされているらしい。

この配線に関して、電力以外はいいのか? という疑問もあるのだが。ただ3D Vキャッシュと異なり、CCDの3次キャッシュとインフィニティ・キャッシュは別に連携しているわけではない(CCDからは4次キャッシュとしてインフィニティ・キャッシュが見えている形になっていると思われる)ので、まだどうにかできるということかもしれない。

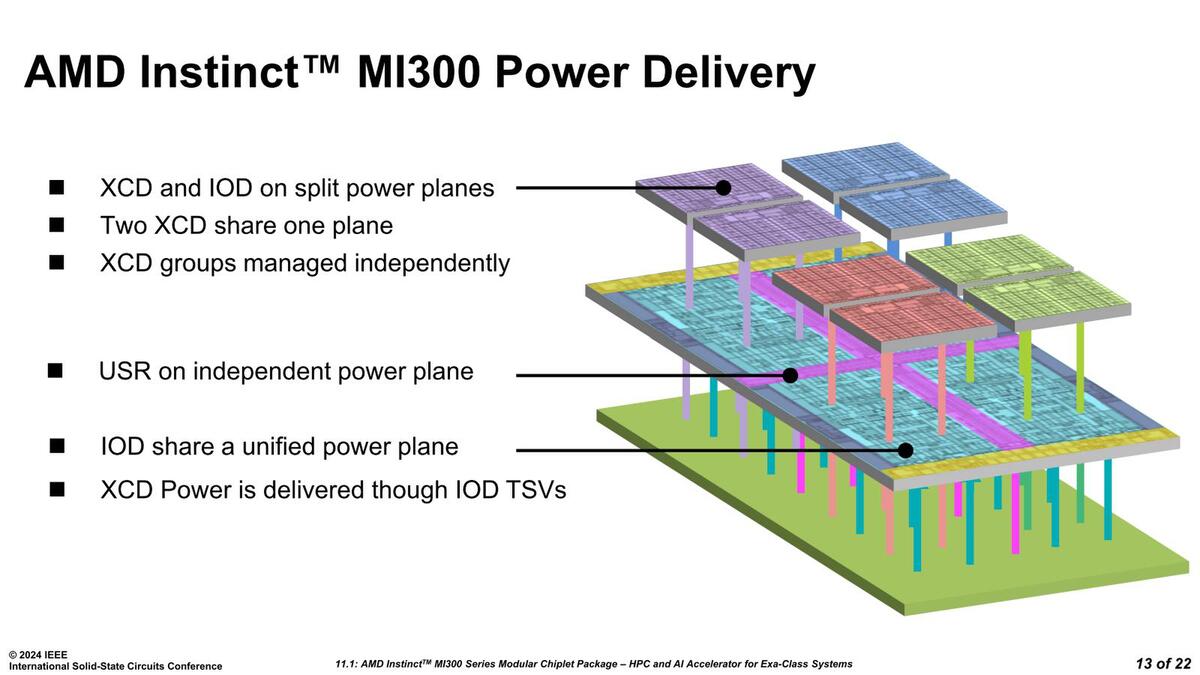

このあたりの模式図(ただしMI300X)が下の画像だ。パワープレーンはIODあたり1つになっているようで、MI300Xは2つのXCDで1つのパワープレーンを共用することになる。

電源周りの模式図。MI300Aの場合は、3つのCCDが1つのパワープレーンになるということだ。このあたりはがんばればCCDなりXCDごとにやることも不可能ではないのだろうが、配線の複雑さが増すデメリットもあるので、妥協したのだろう

ただRyzen同様に、オンダイでLDO(Low Drop Out Regurator)による電圧調整は可能だろうし、Power Gatingも可能になっていると思われるので、これはそれほど問題にはならないだろう。ちなみにUSRというのはUltra Short Reachの略で、これはIOD同士の接続の配線の意味である。

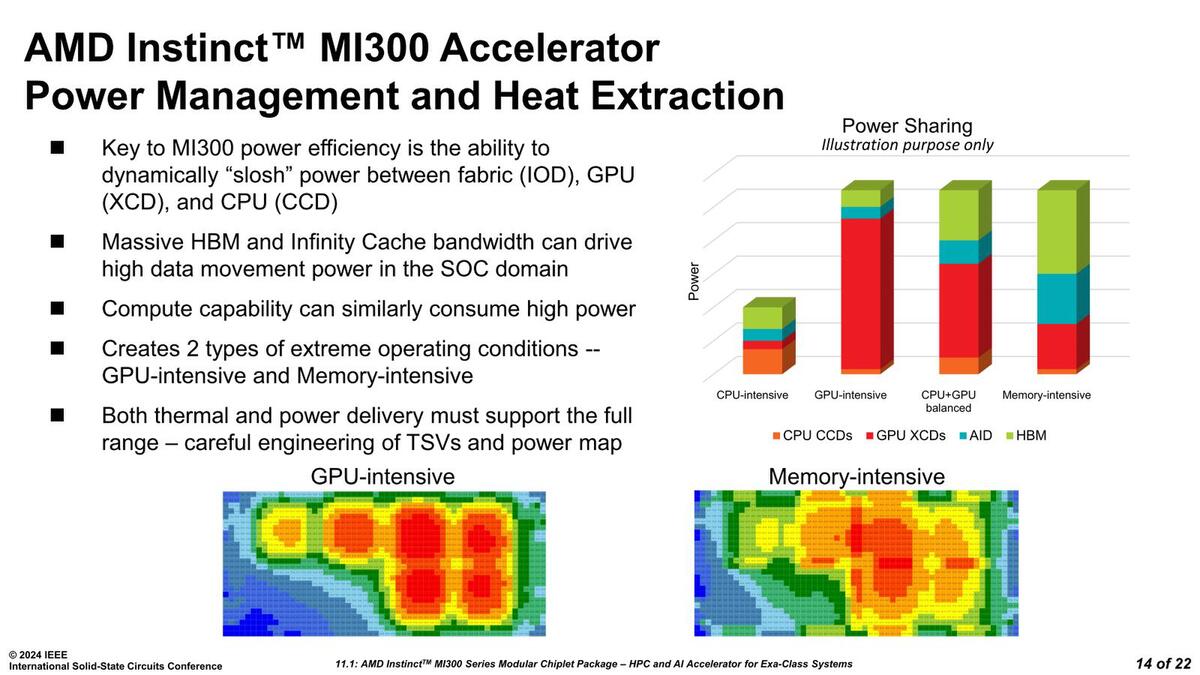

あと、冷静に考えれば当然そうなのだが、モバイルチップ的なパワーシェアリングの機能も搭載されていることが説明された。

TDPはMI300Aで760W、MI300Xで750Wとなっており、さすがにすべてのコンポーネントをフル稼働させたらこれをオーバーするのだが、それを液冷でなんとか動かすのではなく、超えないようにすることで過度の温度上昇を防ぐのは3D Vキャッシュの場合と同じだと思われる

あくまでも上限のパワーは決まっており、この枠の中でワークロードに応じて電力枠を配分する仕組みが入っているというわけだ。サーバー向けだからといって、むやみに電力枠を増やしても性能電力比が悪化するだけであり、このあたりはAMDらしい実装という気がする。

3D構造のチップレットを利用したGPUという観点で言えばインテルのPonte Vecchioが先行しているわけであるが、AMDの実装は過去の同社の実装(3D VキャッシュやInstinct MI250Xなど)の延長にあることが改めて確認できた格好である。

そして、CPUとGPUのユニファイド構成という観点で言えば今のところInstinct MI300Aが唯一であり他社製品にはない。NVIDIAのGH100/200やBH100/200は単に同じパッケージにCPUとGPUが載っているだけで、メモリーはそれぞれ別々になっており、メモリー同士のインターコネクトも存在しない。インテルはFalcon Shore待ちである。

しかもそれを最小限のコストで実装している(まさかIODが共通とは思わなかった)ことを改めて確認できた発表であった。

週刊アスキーの最新情報を購読しよう